scrapy爬虫报错内容

pymongo.errors.DuplicateKeyError: E11000 duplicate key error collection: scrapy_data.qiushibaike index: id dup key: { _id: ObjectId(‘61989dfcfe585e2673d7ee1b’) }, full error: {‘index’: 0, ‘code’: 11000, ‘keyPattern’: {’_id’: 1}, ’

keyValue’: {’_id’: ObjectId(‘61989dfcfe585e2673d7ee1b’)}, ‘errmsg’: “E11000 duplicate key error collection: scrapy_data.qiushibaike index: id dup key: { _id: ObjectId(‘61989dfcfe585e2673d7ee1b’) }”}

2个步骤解决:

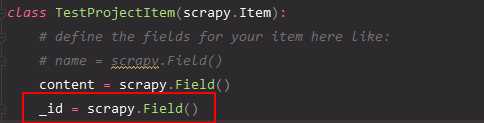

1.爬虫items.py加入_id字段

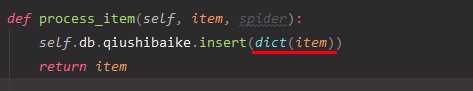

2.我们使用 MongoDB 只能插入字典,但是item 是类似字典所以报错。

插入数据的时候做一个字典的转化动作:

注:我的scrapy版本是2.5.1

今天的文章解决scrapy爬虫报错 pymongo.errors.DuplicateKeyError: E11000 duplicate key error collection分享到此就结束了,感谢您的阅读,如果确实帮到您,您可以动动手指转发给其他人。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌侵权/违法违规的内容, 请发送邮件至 举报,一经查实,本站将立刻删除。

如需转载请保留出处:https://bianchenghao.cn/32591.html