A Personalized Affective Memory Model for Improving Emotion Recognition

icml2019论文链接:https://arxiv.org/pdf/1904.12632.pdf

摘要:

最近的情绪识别模型强烈地依赖于监督深度学习解决方案来区分一般的情绪表达。然而,当他们在线识别和个性化的面部表情时,例如,对于个人特定的情感理解,他们是不可靠的。本文提出了一种基于条件对抗性自编码器的神经模型来学习如何表达和编辑一般的情绪表达。然后,我们提出了在需要时成长的网络作为个性化的情感记忆来学习个性化的情感表达。我们的模型实现了最先进的性能在情绪识别时,评价在野生数据集。此外,我们的实验包括消融研究和神经可视化,以解释我们的模型的行为。

1. Introduction

由于深度学习技术的成功,面部表情的自动识别成为近年来的热门话题。曾经是调整人工面部描述符的专家领域(赵等,2003),成为了深度学习爱好者的许多视觉识别任务之一(Schmidhuber, 2015)。其结果是近十年来自动情绪识别性能的不断提高(Sariyanidi et al., 2015),反映了硬件和不同深度学习解决方案的进展。

然而,面部表情识别的深度学习模型的性能最近停滞不前(Soleymani et al., 2017;(Mehta et al., 2018)。最常见的原因是这些解决方案高度依赖于平衡、强标记和多样化的数据。最近的方法提出通过引入转移学习技术来解决这些问题(Ng et al., 2015;(Kaya et al., 2017),神经激活和数据分布正则化(Ding et al., 2017b)和面部表征的无监督学习(Zen et al., 2014;Kahou等人,2016)。当对特定数据集进行评估时,这些模型中的大多数都表现出性能的改进。尽管如此,这些解决方案中的大多数都需要严格的监督训练,这可能会影响他们概括情绪表征的能力。基于对抗性学习的神经模型研究进展(Kim等,2017;克服了强标记数据的必要性。这些模型依赖于它们以非监督方式学习面部表情的能力,并且与强监督模型相比,它们在情绪识别方面表现出了竞争力。

此外,基于深度学习的端到端模型很难适应不同的情绪识别场景,尤其是现实世界的应用,这主要是由于非常昂贵的训练过程。一旦这些模型需要学习一种新的情感表达,它们就必须被重新训练或设计。这些问题的出现是由于将面部表情识别理解为典型的计算机视觉任务,而不是根据面部表情的具体特征来调整解决方案(Adolphs, 2002)。

针对适应性情绪表征的学习问题,我们重点研究了基于人类情绪表达多样性和情感理解个性化这两个面部感知特征的情绪表达识别。例如,一个人可以通过微笑、大笑和/或移动眼睛来表达快乐,这取决于他或她在和谁说话(Mayer et al., 1990)。当我们考虑到诸如文化背景、内在情绪、性格甚至基因等人际特征时,情感表达的多样性会变得更加复杂(Russell, 2017)。除了多样性,学习个性化表达的适应性也很重要。当人们已经了解一个特定的人,他们可以调整自己的感知,以适应特定的人如何表达情感(哈曼&Canli, 2004)。识别个体面部特征之间的相互作用,即他们如何移动脸上的特定肌肉、嘴巴和眼睛的位置、脸红强度,并将它们聚集成情绪状态,是建模类人情绪识别系统的关键(Sprengelmeyer et al., 1998)。

针对适应性情绪表征的学习问题,我们重点研究了基于人类情绪表达多样性和情感理解个性化这两个面部感知特征的情绪表达识别。例如,一个人可以通过微笑、大笑和/或移动眼睛来表达快乐,这取决于他或她在和谁说话(Mayer et al., 1990)。当我们考虑到诸如文化背景、内在情绪、性格甚至基因等人际特征时,情感表达的多样性会变得更加复杂(Russell, 2017)。除了多样性,学习个性化表达的适应性也很重要。当人们已经了解一个特定的人,他们可以调整自己的感知,以适应特定的人如何表达情感(哈曼&Canli, 2004)。识别个体面部特征之间的相互作用,即他们如何移动脸上的特定肌肉、嘴巴和眼睛的位置、脸红强度,并将它们聚集成情绪状态,是建模类人情绪识别系统的关键(Sprengelmeyer et al., 1998)。

面部表情学习多样性的问题比较出名的最近的发展野生情绪表达数据集(Zadeh等,2016;Mollahosseini等人,2017;Dhall等,2018)。这些语料库利用大量的数据来增加情绪表征的可变性。虽然使用这些语料库训练的深度学习模型提高了不同情绪识别任务的表现(de Bittencourt Zavan et al., 2017;Kollias,(Zafeiriou, 2018),他们仍然缺乏对个性化表达的适应性。

无监督聚类和动态适应探索解决个性化情感表达的问题(陈et al ., 2014;禅宗et al ., 2014;Valenza et al ., 2014)。大多数最近的解决方案使用一组不同的情感刺激(例如脑电图、视觉和听觉)和神经结构,但原理是一样的:火车与数据从一个个人识别模型,提高情感表示。虽然在特定的基准评估表现良好,这些模型不能适应网络和持续学习场景在现实世界的应用。

情感记忆模型(Barros &Wermter, 2017)提出了一个在需要时增长的(GWR)网络来从一个特定的人那里学习情感表现集群,从而解决了持续适应的问题。每个人产生一个情感记忆,它由卷积神经网络(CNN)的最后一层表示填充而成。这个模型创造了代表每个感知到的面部表情的原型神经元。虽然与最先进的模型相比,该模型提高了情绪表达识别能力,但在在线场景中并不可靠。原型神经元只有在感知到某种表情后才会形成,它严重依赖于有监督的CNN,所以模型只有在感知到所有可能的情绪表情后才会产生良好的表现。

在本文中,我们提出了一种个性化的情感记忆框架,它改进了原有的在线情感识别的情感记忆模型。在互动的开始,人类往往严重依赖自己的先验知识来理解面部表情,这种先验知识是在多次互动中习得的(Nook et al., 2015)。提出了一种新的生成对抗式自编码模型来学习情绪表征的先验知识。我们对模型进行调整,通过生成具有可控情绪表情的编辑过的面孔,将习得的表征转移到未知的人身上(Huang et al., 2018;Wang et al., 2018)。我们使用一个人生成的面孔来初始化个性化的情感记忆。然后,我们通过在线方式更新感知到的面孔的情感记忆,并使用它在线识别面部表情。

我们评估我们的模型在两个步骤:第一,模型可以学习如何情感表达式的一般表示,使用AffectNet数据集(Mollahosseini et al ., 2017)。其次,小说如何个性化情感记忆执行当认识到情感的表达特定的人使用连续表达式在OMG-Emotion数据集(Barros et al ., 2018)。我们比较两个数据集模型与最先进的解决方案。除了性能,我们还提供一个探索性研究如何使用我们的模型作品基于其神经活动激活可视化技术。

2. The Personalized Affective Memory

个性化情感记忆(P-AffMem)模型由两个模块组成:先验知识学习模块(PK)和情感记忆模块。该先验知识学习模块由一个对抗性的自编码器组成,该自编码器学习面部表情表示(z),并使用可控的情绪信息生成图像,表示为连续唤醒和价值(y)。

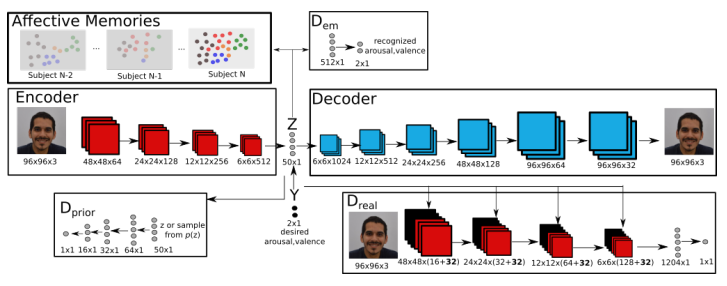

autoencoder训练后,我们使用它来生成一系列的编辑图像用不同的表情从一个人使用不同的y值。我们使用这个集合生成的面孔,初始化growing-when-required(吉尼斯世界纪录)网络代表特定的个性化情感记忆的人。我们使用个性化情感记忆的簇来识别那个人的情感表达。图1说明了P-AffMem模型的拓扑细节。

2.1. Prior-Knowledge Adversarial autoencoder

我们的PK模型是条件对抗式自动编码器(CAAE)的扩展版本(Zhang et al., 2017),其目的是学习如何将年龄信息表示和编辑为面部图像。我们选择CAAE作为我们的先验知识模块的基础,因为它可以在没有配对数据(同一个人不同年龄的图像)的情况下工作,并且对输入数据分布的统计变化具有鲁棒性。

PK模型由编码器和生成器架构(E和G)以及三个鉴别器网络组成。第一种是学习唤起/效价表征(Dem),第二种是保证面部表情表征具有均匀分布(d先验),第三种是保证生成的图像具有真实感,表达了期望的情绪(Dreal)。该模型接收一个图像(x)和一个连续的唤醒/效价标签(y)作为输入。它产生一个面部表征(z)和一个编辑过的图像来表达所选择的唤醒/效价(xgen)。

图1所示。P-AffMem模型由先验知识对抗自编码(PK)和情感记忆组成。PK实现了一个编码器/解码器架构和特定的鉴别器,以详细的唤醒和价态(Dem),以确保编码表示(Dprior)的先验分布,并确保一个逼真的图像生成(Dreal)。情感记忆是个体在需要时的成长(GWR)网络,它学习面部表情的个性化方面。

2.1.1. ENCODER AND GENERATOR

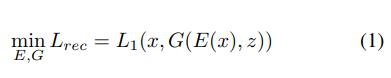

编码器网络(E)由四个卷积层和一个完全连接的输出层组成。我们利用2的卷积步来避免池的使用,从而学习其自身的空间降采样(Radford et al., 2015)。E接收尺寸为96x96x3的RGB图像作为输入,输出尺寸为(50×1)的面部表情表示(z)。将z与所需的情感表示(y)连接起来,作为解码器网络(G)的输入,G网络生成具有所需情感表达y的图像(xgen)。前四个步骤是2,后面两个步骤是1。所有的E和G的卷积和转置卷积都使用一个5×5的核大小。E层和G层都使用ReLu激活函数。E和G都经过图像重建损失(Lrec)训练:

其中L1为平均绝对误差。

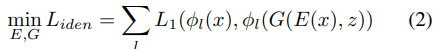

CAAE的问题之一是在重建的图像上出现了鬼影。CAAE的作者通过使用总变差最小损失函数(Mahendran &但结果令人质疑。我们通过ExprGan (Ding et al., 2017a)和G2-GAN (Song et al., 2017)对重构图像使用的保持身份丢失(Liden)来解决这个问题。使用预先训练的VGG人脸模型计算身份保留损失(Parkhi et al., 2015)。VGG人脸模型对VGG16模型进行了拓扑更新,并对其进行了人脸识别训练。为了计算Liden,我们比较了x和xgen下VGG面前5个卷积层的激活情况:

2.1.2. AROUSAL/VALENCE REPRESENTATION DISCRIMINATOR

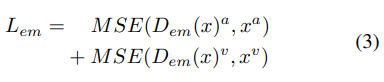

唤醒/效价表征鉴别器(Dem)强制编码器学习能够用于情感识别任务的面部表征。这个鉴别器对于保证z适合表达情感表达是很重要的,因为z将被用来填充情感记忆。Dem由两个完全连通的隐层组成,第一个实现ReLu激活函数,最后一个实现tanh线性函数。最后一层作为输出,表示连续的唤醒值和价值。损失的计算方法是:

其中MSE为均值平方误差,Dem(x) a和Dem(x) v分别表示Dem的唤醒值和价态输出,x a和x v分别表示图像输入x对应的唤醒值和价态值。

2.1.3. UNIFORM DISTRIBUTION DISCRIMINATOR

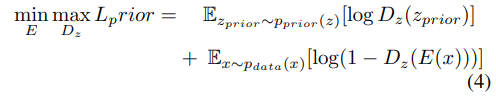

将均匀分布鉴别器(d先验)施加于z上,使其均匀分布。重要的是,z是均匀分布的,以增加模型的泛化,当代表一个面部表情。它接收z本身或从均匀分布的pprior(z)中随机选择的样本作为输入,并以区分它们为目标。Dprior由四个完全连接的层组成,每个层实现ReLu激活功能。定义E与Dprior之间的对抗性损失函数为:

其中E为似然,pprior(z)对内部表示施加先验分布z, pdata(x)对训练图像的分布。

2.1.4. PHOTO-REALISTIC IMAGE DISCRIMINATOR

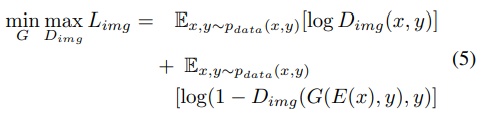

真实感图像鉴别器(Dreal)基本上是典型生成对抗网络(GAN)上的一个普通真假鉴别器。在我们的例子中,它也作为一种机制来施加解码器(G)来生成具有所需的情感表达(y)的逼真的图像。Dreal实现了四个卷积层,步长为2,内核大小为5×5,然后是两个完全连接的层。为了将期望的唤醒和效价(y)增强到生成的图像(xgen)中,我们对y执行重新塑造和补零操作,并将其与Dreal的每个卷积层连接起来。在我们的实验中,y与所有卷积层的连接被证明是生成逼真的编辑过的面部表情的重要一步。为了将期望的y强制转换成G生成的xgen,我们使用下面的对抗损失函数:

其中pdata(x, y)为训练数据的分布。

2.1.5. OVERALL LOSS FUNCTION

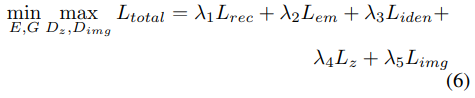

为了训练我们的模型,我们使用一个定义为的整体损失函数:

系数λ1λ2、λ3λ4和λ4是用来平衡面部表情歧视,生成的高保真图像和所需的情感的存在对生成的图像。

2.2. Affective Memory

根据需要增长(GWR)网络(Marsland et al., 2002)最近被用于解决持续学习的问题(Parisi et al., 2017;2018)。使用在线方式创建原型神经元的能力允许GWR快速适应输入数据的变化。这使它成为我们在线学习机制的理想选择。

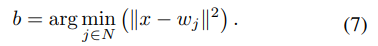

GWR的每个神经元由一个权向量wj组成,wj表示输入数据的原型信息。一个新感知到的情绪表达将与一个最佳匹配单元(BMU) b相关联,这个最佳匹配单元是通过最小化面部表情与GWR上所有神经元之间的距离来计算的。给定一组N个神经元,b关于输入x R N的计算为:

在BMU和第二个BMU之间创建与输入相关的新连接。当BMU被计算时,BMU所连接的所有神经元被称为它的拓扑邻居。每个神经元都配备了一个适应计数器hi[0,1],该计数器根据一个简化的模型来表示它被激活的频率。

习惯化的规则是由嗨=τi·κ·(1嗨)τi,κ和τi常数控制的减少行为习惯化计数器(Marsland et al ., 2002)。为了确定一个神经元是否具有习惯性,它的习惯性计数器hi必须小于给定的习惯性阈值th。

网络由两个神经元初始化,在每次学习迭代中,每当网络活动时,它都会插入一个新的神经元,当感知到一个习惯神经元的i表达时,它小于给定的阈值。

P-AffMem模型使用的吉尼斯世界纪录情感记忆执行个性化学习原型神经元。吉尼斯世界纪录第一次面部表情时创建的一个人。PK模块产生200编辑图像的组合唤醒和价区间内的[1],增量为0.01。这些图片是用来初始化情感记忆和作为知识转移的PK的初始估计。为了避免生成的样本主导情感记忆更新随着时间的推移,我们停止生成样品在一定数量的表情被感知。

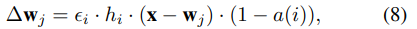

为了保证PK不会长期主导情感记忆的训练,我们使用了一个新的更新函数来调节PK对GWR的影响。网络的训练是通过使BMU适应t来实现的:

当学习速率恒定。如果感知到真实的人脸,并且这些人脸与PK所编码的人脸不同,则网络的激活程度会更小,对权值更新的影响也会更大。情感记忆将被鼓励创造新的神经元来代表新感知的表情,而不是来自PK的表情。

为了让GWR对情绪表达进行分类,我们对每个神经元进行了联想标记(Parisi et al., 2017)。在训练阶段,我们给每个神经元分配两个连续的值,分别代表唤醒和价态。当使用生成的图像进行训练时,我们使用所需的唤醒和效价来更新BMU的标签。标签的更新调整学习因子γ是定义在训练。要对新感知的表达式进行分类,只需阅读与之相关的BMU的标签。

2.3. Parameter Optimization

我们使用Ltotal训练PK模型,使用TPE优化策略优化模型s拓扑、系数、批量大小和训练参数(Bergstra et al., 2013)。优化基于两个特征:唤醒/效价鉴别器的目标性能和Ltotal的最小化。最后的系数值如下:λ1 = 1,λ2 = 0.02,λ3 = 0.3,λ4 = 0.01和λ5 = 0.01。批号是48所有层的权值初始化采用均值为0,标准差为0.02的正态分布。所有偏差最初都设置为0。优化器优化,亚当有学习率α= 0.0002,β1 = 0.5β2 = 0.999的工作。

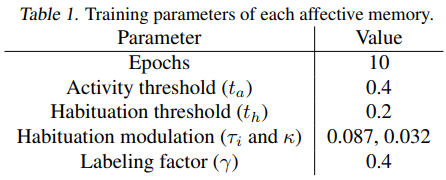

我们也使用TPE优化来调整情感记忆的参数。尽管它们是为一个特定的人单独创建的,但是它们都具有相同的超参数,以简化我们的评估任务并允许在线使用模型。假设GWR适应输入数据分布,并且我们保持相同的数据性质,我们不认为将每个GWR微调到每个人会在识别性能上获得很大的收益。表1显示了最终的情感记忆参数。

3. Experimental Setup

为了更好地评价和理解PK和情感记忆对情绪表达识别的个体影响,我们进行了两种不同类型的实验。首先,我们进行了一系列消融研究,以评估PK中各机制对一般情绪识别的贡献。其次,我们在整个框架下进行了一个情绪识别实验,以评估个性化对情绪识别性能的影响。

3.1. Datasets

情感网数据集(Mollahosseini et al., 2017)由100多万张从不同的野生来源(如Youtube和谷歌图像)收集的面部表情图像组成。超过40万幅图像被手工标注上持续的唤醒和效价。数据集在训练、测试和验证样本之间有自己的分离。由于没有测试样本的标签,所以我们所有的实验都是使用训练样本和验证样本进行的。情感网络的大标记数据分布是保证PK学习一般情绪识别的重要保证。它提供了一个理想的语料库来使用一个客观的可比较的度量来评估PK中每个提议的机制的影响。

此外,由于网络不会区分来自同一个人的图像,因此个性化并没有发挥重要作用。为了评估个性化的贡献,我们在一分钟渐进情绪行为数据集(OMGEmotion)上提供了最后的实验(Barros等,2018)。OMG-Emotion是由一分钟左右的Youtube视频组成,并根据持续的情感行为进行注释。这些视频是使用爬虫技术挑选出来的,爬虫技术使用基于长期情感场景的特定关键词,如独白、试镜、对话和情感场景,这保证了每个视频只有一个人在进行情感展示。总共收集了675个视频,总计10h左右的数据。视频中的每个话语都用两个连续的标签标注,分别代表唤起和价态。OMGEmotion dateset中所表现出来的情绪表达受到了个体特性的强烈影响,这一点在整个视频中通过情绪行为的逐渐变化得到了凸显。

3.2. Experiments

我们的实验分为两类:消融研究(A)和个性化的情感识别(P)。一个类别分为一系列的实验中,他们每个人评价一个鉴别器的PK:写实的图像鉴别器(Dreal),均匀分布(Dprior)和兴奋/价鉴别器(民主党)。在这些实验中,我们使用affect tnet语料库的训练子集训练PK,并使用验证子集对其进行评估。

我们首先在没有任何先前提到的甄别器(PKbase)的情况下训练PK,以保证一个无偏的基线。然后,我们重复训练,现在分别添加每个鉴别器。我们结合各鉴别器的存在来报告实验结果。最后,我们添加所有的鉴别器(PKall)并再次训练PK。

为了提供一个标准的评价指标,我们使用编码器表示(z)作为输入的情感识别分类器。该分类器由与唤醒/效价鉴别器相同的拓扑结构组成,使用与情感网数据集相同的训练子集进行后训练。在使用唤醒/效价鉴别器训练PK时,我们不使用情感识别分类器,这样我们就可以评估这个特定鉴别器的性能。

将P类划分为两个实验:首先,使用affect tnet数据集对PK进行预训练,用于评估OMG-Emotion数据集的测试集。然后我们使用整个P-AffMem框架与情感记忆和重复实验,现在使用一个为每个测试集的视频情感记忆。在我们优化常规我们发现如果PK生成面临超过1 s的视频,情感记忆并改善最终结果。因为OMG-Emotion数据集有一个framerate每秒25帧,我们关闭PK图像生成在前25帧之后。

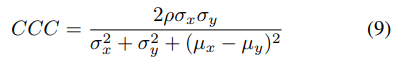

为了评估维度唤起和效价识别,我们使用一致性相关系数(CCC) (Lawrence &在模型的输出和真实标签之间。CCC可以计算为:

其中ρ是皮尔森年代之间的相关系数模型预测标签和注释,x和y表示对模型预测和注释和σ2 x和y是相应的方差σ2。

4. Results

4.1. Ablation Studies (A)

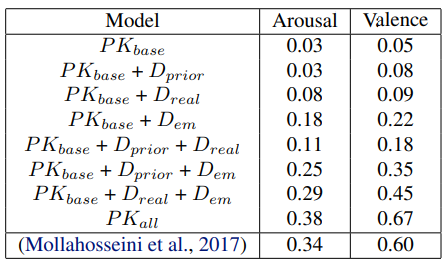

我们的消融研究总结在表2中,帮助我们理解和量化每一个PK模块对识别情绪表达的影响。基线模型不需要任何额外的鉴别器,可以作为一个简单的生成式对抗网络(GAN)进行评价。毫无意外,基线模型在情绪识别方面表现不佳,在我们的实验中得到了最差的结果。这反映了基线模型无法提供良好的面部表情识别能力。通过引入每个鉴别器来评估模型,我们可以评估它们的影响。情绪识别识别器(emotion recognition discriminator, Dem)似乎是对PK表现影响最大的一个,这并不奇怪,因为它强制PK编码器学习面部表情识别的具体特征。然而,我们也观察到对真实感鉴别器(Dreal)的强烈影响,这表明网络从强制编码和产生鉴别个体的特征中获益良多。先验分布鉴别器(d先验)的个体贡献比其他所有鉴别器都要小。但是,当与其他鉴别器结合使用时,识别效果有了很大的提高。

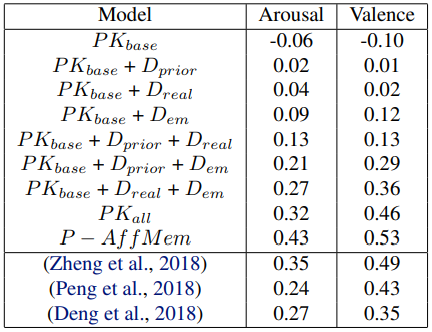

表2。在情感网数据集的验证子集上评估PK的不同鉴别器时,唤醒和效价的一致性相关系数(CCC)。

训练PK与所有的甄别产生最好的结果。据我们所知,在情感网语料库中,仅有的关于唤起和效价的CCC来自数据集的作者本身(Mollahosseini等,2017)。他们使用AlexNet卷积神经网络(Krizhevsky et al., 2012)重新训练识别唤醒和效价。我们的PK模型提出了一个更好的一般性能,提高CCC在超过0.4的觉醒和0.7的觉醒。因为我们的消融研究只是为了阐明我们的PK模块的影响,我们没有使用其他数据集进行纯基准研究。

4.2. Personalized Recognition (P)

为了量化情感记忆对P-AffMem模型的贡献,我们分别进行了有情感记忆和无情感记忆的实验。表3总结了在OMG-Emotion数据集上实现的CCC和当前的最新结果。情感记忆的存在大大提高了模型的性能,与所有鉴别器PK相比,唤起和效价分别提高了0.9和0.7的CCC。

到目前为止,在OMG-Emotion数据集上,P-AffMem取得了最好的结果。该数据集最近被用作挑战的一部分,并提出了不同的解决方案,大部分基于预先训练的深度学习模型。我们的模型与挑战的获胜者(Zheng et al., 2018)相比,兴奋度提升0.9,效价提升0.4。次优模型也是如此(Peng et al., 2018)。仅使用面部表情的最佳模型(Deng et al., 2018)的唤醒和效价CCC分别比我们的模型小0.16和0.18。

表3。在OMG-Emotion数据集的测试子集上评估我们的模型时,唤醒和效价的一致性相关系数(CCC)。

5. Discussions

PK模块必须经过预先训练,以实现更好的情绪表达识别泛化。PK模型有1600万个参数,与任何对抗性网络训练一样,它具有广泛且计算量大的训练过程。我们的假设是,一旦训练,PK将提供一般的情绪识别能力。我们使用OMG-Emotion数据集进行的实验表明,PK在识别一般的情感表达方面取得了与其他预训练的深度学习模型相似的性能。

情感记忆通过提供一种自适应机制,通过聚集一个人表达情感的个体特征来提高PK的表现,从而有助于P-AffMem。这一假设得到了客观的证明,P-AffMem的CCC值高于PK。

为了扩展我们对P-AffMem的理解,并确定我们对一般与特殊情感识别的主张,我们将在下一节讨论PK和情感记忆各自的贡献。我们还将深入了解这些模型如何有助于提高性能。

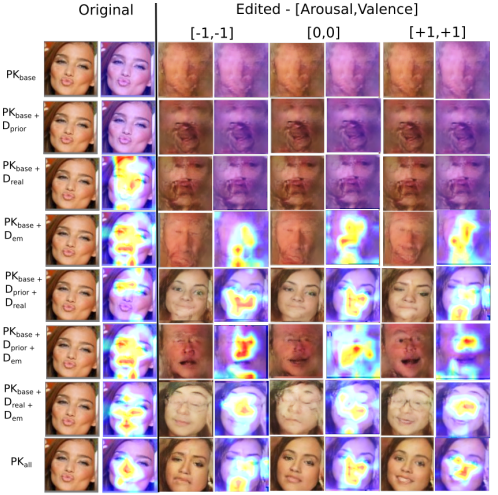

图2。列的第一对表示感知到的情绪表达和编码器最后一层的神经激活图。剩下的几对列使用指定的唤醒值和价值显示编辑后的人脸,以及相应的神经激活图。

5.1. The Impact of the Discriminator Mechanisms

作为一个对抗式的自动编码器,PK被训练来编码和编辑面部图像。每个鉴别器对编码和编辑任务都施加了一个特定的特征,在我们的设置中,它们一起被证明是情感表达识别的最佳选择。虽然我们的实验客观地测量了这些识别器对面部表情编码的影响,但我们只是含蓄地评估了它们对面部编辑的贡献。通过证明情感记忆改善了模型的性能,我们保证了用于初始化和训练情感记忆的编辑过的面孔确实具有所需要的面部表情。

由于对模型进行了优化以识别面部表情,因此对经过编辑的人脸像素质量的分析可能会产生误导。为了说明这一假设,我们给在我们的A类实验中提出的每一个PK组合提供一张图像,并生成三张经过编辑的面孔,它们的唤起和效价的极值是[-1,-1]和[1,1],中性值是[0,0]。然后,我们计算了每一个例子中鉴别器最后卷积层的平均神经激活图(Zhou et al., 2016)。图2展示了四对列,其中第一对列由提供给PKs的原始图像和获得的编码器激活可视化结果组成。其他的树列显示了经过编辑的图像,显示了唤醒和价值以及编码器的激活。由于编码器的训练直接受到鉴频器的影响,因此这些可视化的结果为我们提供了每个鉴频器如何影响学习表示的指示,并帮助我们解释网络目标性能。

显然,只使用PKbase训练的编码器并没有学习到任何有意义的信息,这反映在编辑后的图像和激活中。这也得到了我们客观结果的支持。鉴别器的组合以可分辨的方式影响所编辑的面和编码器。PKreal在编辑后的人脸上增强了逼真的特征,但它对编码器聚焦面部结构产生了影响,而这种聚焦对于面部表情的表达是不可靠的。例如,与Dem相比,这一效应在较低的CCC上得到了体现。当Dem存在时,编码器清晰地过滤面部表情丰富的区域,如眼睛和嘴巴区域。这一点在PKbase + PKprior + PKphoto组合中表现得很明显,例如,在PKbase + Dreal + Dem的基础上,呈现出明显的面部编辑,但CCC值低于PKbase + Dreal + Dem。前者的编码激活表明它忽略了一些面部特征,这可以解释其性能较低的原因。

最后,所有鉴别器的组合使PK获得了最佳的客观性能,这反映在经过编辑的图像和激活上。图像包含了当前清晰的面部特征,没有形成扭曲的伪影,保持了一般的面部比例和特征。激活表明,编码器在大多数情况下明显聚焦于眼-嘴区域。这些可视化结果证明了PK在编码和编辑面部表情方面的可靠性,这对于情感记忆的最佳功能非常重要。

5.2. Affective Memory Behavior

在om – emotion数据集上的视频受到了个性化特征的严重影响,因为它们包含一个人执行类似独白的动作超过1分钟。由于P-AffMem是由PK编辑的图像初始化的,它从一开始就包含了具有广泛的相关唤醒和价电子标签的原型神经元。随着视频的进行,情感记忆的神经元更容易受到新感知的面部表情的影响,从而使神经元的激活增加。需要注意的是,新感知的表达不会改变神经元的标签,只会改变其原型信息。这样,我们保证了网络保持一个可靠的分类。

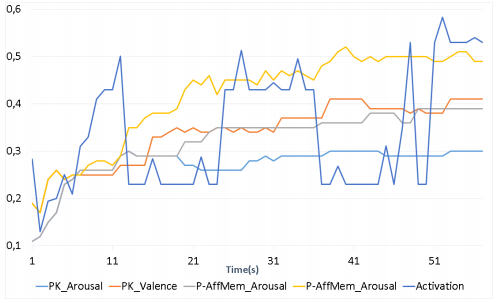

图3。在处理OMG-Emotion数据集的fd41c38b2视频时,模型在CCC中对PK和P-AffMem的性能以及神经激活进行了测量。

PK已经给了情感记忆一般的原型神经元可靠的标签,神经更新使它们对新感知的表情的具体特征更准确。一些秒过去后,情感记忆开始执行比PK。这种效果是显示在图3中,它说明了PK的性能和P-AffMem测量唤醒和价CCC,和情感记忆的神经活动演化在处理视频fd41c38b2 OMG-Emotion数据集。

6. Conclusion and Future Work

我们的个性化情感记忆(P-AffMem)模型的发展受到两个面部知觉特征的启发:广义情感概念的理解和面部表情个性化方面的在线适应。一般先验知识(PK)对抗的自动编码器被训练来转移面部特征,表现为唤醒和效价,到未知的人。情感记忆通过在线方式为特定的人创建情感的原型表征,从而促进了学习表征。我们的评估表明,我们的模型在面部表情识别方面达到了最新水平,我们对我们的模型如何工作以及为什么工作提出了不同的见解。

我们的模型的一个明显的局限性是对即时情绪表达的处理。为了解决这个问题,我们将鼓励最近关于循环自组织和序列生成的工作(Parisi et al., 2017;2018)。另一个可以探索的方向是多感官信息的整合,但要特别注意非同步的情感感知,如韵律语言和语言理解。

Acknowledgments

作者感谢德国研究基金会在CML项目下的部分支持(TRR 169)。

今天的文章一种个性化的情感记忆模型分享到此就结束了,感谢您的阅读。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌侵权/违法违规的内容, 请发送邮件至 举报,一经查实,本站将立刻删除。

如需转载请保留出处:https://bianchenghao.cn/62637.html