数据时代来临,数据量的爆炸式增长是最为显著的特征。当高性能硬件的普及还跟不上这样的数据大潮时,如何在有限的时空资源内处理海量数据成为了计算机科学以及数理统计等领域最大的挑战。

所谓“数据处理”,在本文中特指通过计算机技术,对海量数据进行存储、统计、查询等操作。我将在下面介绍一些基本的海量数据处理的方法,供大家参考。需要明确的一点是,现实情况复杂多变,所以对于海量数据处理这样大的主题,是不可能用一篇博客就说清楚的。但方法论可以一通百通,我们通过一些已经被无数次实验证明有效的方法,就能大致理解对此类问题的解决思路,之后在面临新的问题时,至少能找到一个大致的方向。

1. 海量数据处理的困难

海量数据处理的困难用一句话概括,就是时空资源不够。具体来说,

- 时间受限:无法在有限时间内,完成针对海量数据的某项处理工作;

- 空间受限:无法将海量数据一次性读入内存

对于时间受限的问题,我们一般的解决办法是高效的算法配合恰当的数据结构,比如哈希表,Bloom Filter,堆,倒排索引,tire树);而对于空间受限的问题,一般的解决办法是“大而化小,分而治之”的策略,既然一次性行不通,那就一部分一部分读,每读入一部分可以生成一个小文件,小文件是可以直接读入内存的,我们这样分割大数据之后,再依次处理小文件的数据。

注意,本文我只介绍对于海量数据执行一些简单的数据处理(比如存储,查重,排序,统计数量等)时的一些通用的方法,至于更复杂的计算,涉及具体算法性能层面的东西,由于世界上算法以千万记,面对不同情况,又有着无数变形,所以不可能总结出来。

2. 海量数据处理方法归纳

July的博客 教你如何迅速秒杀掉:99%的海量数据处理面试题 对海量数据处理的方法进行了细致的总结,这篇文章写的非常全面,建议大家一读。但我读完之后,窃以为许多问题和解决思路有所重复,没必要全部都详细探究。为了理清思路、抓重点,我将那篇文章中涉及的问题以及相应方法更加简化地总结为如下7点。

2.1 哈希映射 + 统计 + 排序

解决问题:海量数据不能一次性读入内存,而我们需要对海量数据进行的计数、排序等操作

使用工具:hash函数(hash表);堆

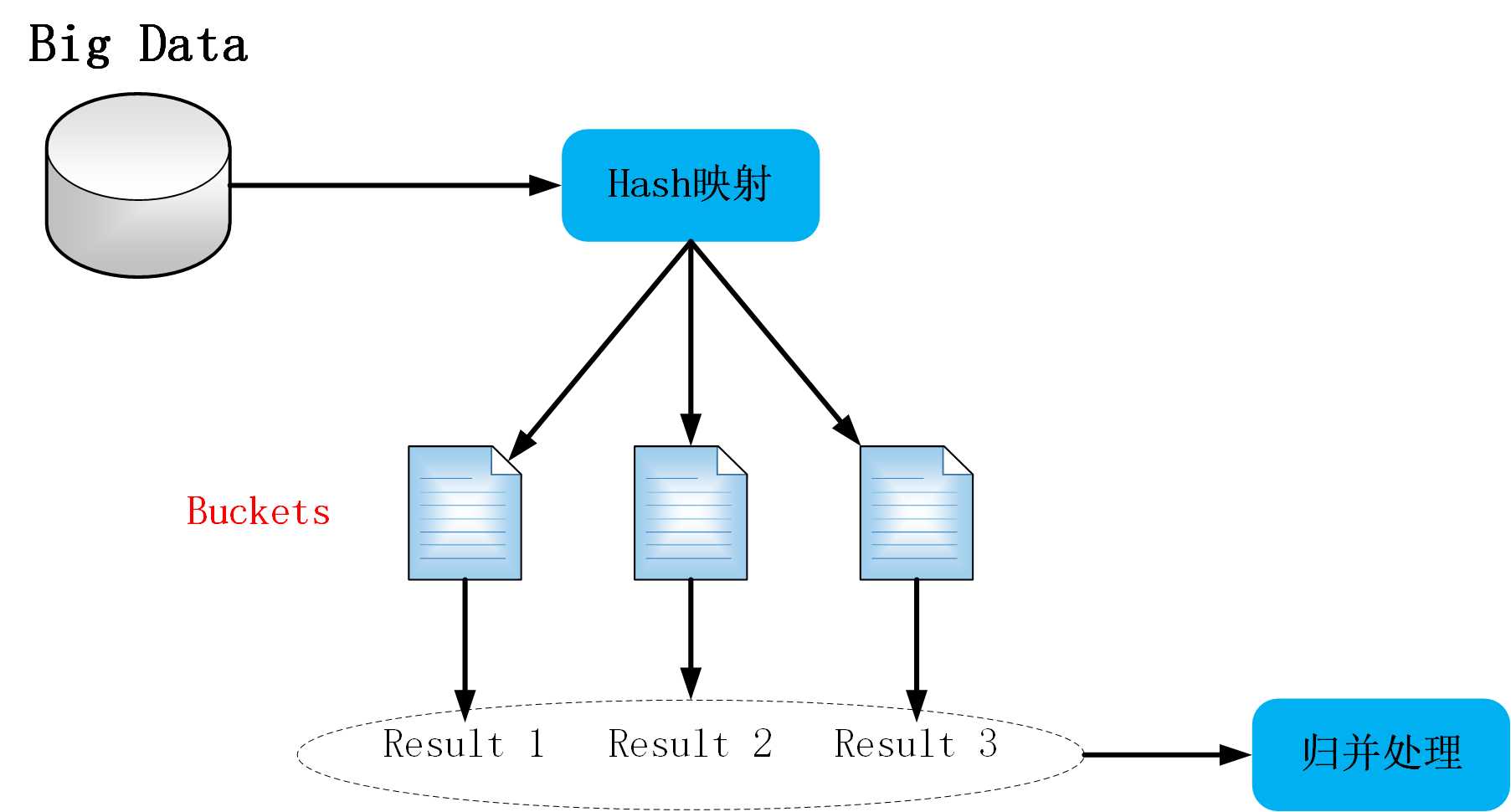

这种方法是典型的“分而治之”的策略,也是解决空间限制最常用的方法。基本思路可以用下图表示。先借助哈希算法,计算每一条数据的hash值,按照hash值将海量数据分布存储到多个桶中(所谓桶,一般可以用小文件实现)。根据hash函数的唯一性,相同的数据一定在同一个桶中。如此,我们再依次处理这些小文件,最后做合并运算即可(有点类似于Map-Reduce的思想)。

注:一般用hash函数将数据映射到桶的方法是:

其中 mi m i 为第 i i 条数据,bucket_ID为桶标号,n为要设置的桶数量。关于桶数量(即小文件数量)设置的基本的原则是:每个小文件的大小比内存限制要小。比如处理1G的大文件,内存限制为1M,那就可以把大文件分成2000个小文件(甚至更多),这样每个小文件的大小约500K(甚至更小),我们就可以轻松读入内存处理了。下面看一些具体的例子:

问题1 top-k筛选:海量数据存储于多个文件,任何一条数据都可能存在于任何一个文件当中,现需要筛选出现的次数最多的

k

条数据。

今天的文章海量数据处理技巧_数据处理分析的方法和工具「建议收藏」分享到此就结束了,感谢您的阅读。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌侵权/违法违规的内容, 请发送邮件至 举报,一经查实,本站将立刻删除。

如需转载请保留出处:http://bianchenghao.cn/77811.html