这篇文章的主要思路是先对原始空间的数据集 X∈Rn×d 用PCA进行降维处理,设经过PCA降维后的数据集为 V∈Rn×c ,该问题就可以转化为将该数据集中的数据点映射到一个二进制超立方体的顶点上,使得对应的量化误差最小,从而而已得到对应该数据集优良的二进制编码。

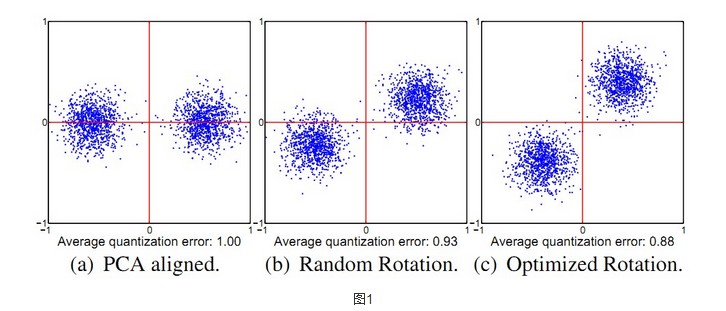

对于PCA降维部分,不做详解,具体可以参阅该文[1]。设 v∈Rc 为原特征空间中某一数据点经过PCA降维后的表示形式,对应在超立方体中的顶点用 sgn(v)∈{ −1,1}c 来表示,要使量化误差最小,即 v∈Rc 与 sgn(v)∈{ −1,1}c 的欧式距离最小,即 min||sgn(v)−v)||2 ,对于所有的数据点进行二进制编码后用B表示,PCA降维后 V=X×W ,对整个数据集为 min||B−V||2 。由于对矩阵进行旋转可以降低量化误差,如下图示:

从图1可以看出,对投影后的矩阵V进行随机旋转后,量化误差降低至0.93,对于找到的最优的旋转矩阵,量化误差降低至0.88(矩阵与正交矩阵相乘实际上就是对矩阵做旋转)。基于这样一个事实,考虑将投影后的数据集V进行旋转变换, min||B−V||2 便变换为 min||B−VR||2 ,R为旋转矩阵。整个问题域就变成了 min||B−VR||2 的优化问题,即找出最优的旋转矩阵R和与之对应的编码B。该式的优化可以采用交替跌倒的求解方法:先生成随机矩阵并对其进行SVD分解得到对应的正交矩阵作为R的初始值,然后固定R求B, B=sgn(V×D) (注意这里截距 b=0 ,因为在原空间已对数据中心化,非常重要),B求出来再通过对 B×V 进行SVD更新R,交替迭代若干次即可,文中选用的是50次。

通过上面过程便可经过PCA降维后的数据完成编码过程,后面的相似性采用汉明距离进行度量,这里不赘述。

总结一下,整个过程可以概括为:先对数据集进行PCA降维,然后寻找量化误差最小的旋转矩阵即可得到对应该最优旋转矩阵下的特征向量的二进制编码。

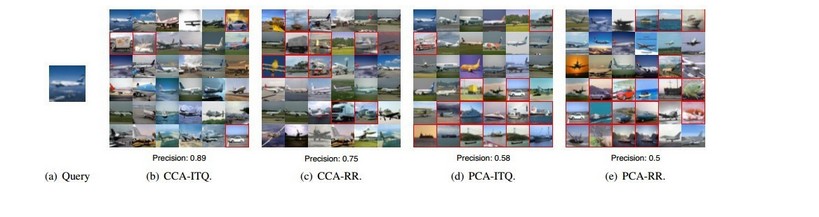

论文给出了检索飞机的一个实例效果:

Matlab源代码:Yunchao Gong Homepage上公开了源码,不过并提供数据库,直接运行不了,我已经对源码进行了modify,有需要的可以看LSH、ITQ、SKLSH图像检索实验实现(Code)这篇文章,在这篇文章中提供了modified后的代码,也可以直接到我的GitHub主页上下载modified后的代码。

Github: https://github.com/willard-yuan/ITQ_ImageRetrieval

[1]. Yunchao Gong and S. Lazebnik. Iterative Quantization: A Procrustean Approach to Learning Binary Codes. In: IEEE International Conference on Computer Vision and Pattern Recognition (CVPR), 2011.

今天的文章 ITQ(Iterative Quantization)迭代量化方法详解 hash 哈希算法分享到此就结束了,感谢您的阅读。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌侵权/违法违规的内容, 请发送邮件至 举报,一经查实,本站将立刻删除。

如需转载请保留出处:https://bianchenghao.cn/bian-cheng-ji-chu/96600.html