最近在eclipse构建spark java开发环境走了很多坑,把步骤记录下来。

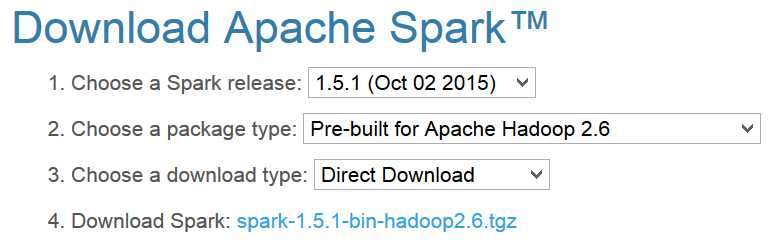

第一步、从spark官网上下载spark安装包,我下载的为spark-1.5.1-bin-hadoop2.6

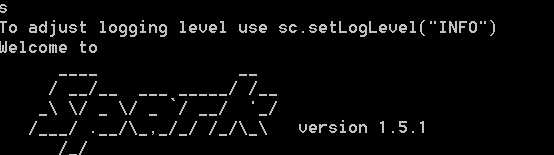

直接解压缩即可,在环境变量path中配置为你解压缩的路径+\bin,我的path为D:\spark-1.5.1-bin-hadoop2.6\bin,在cmd中输入spark-shell

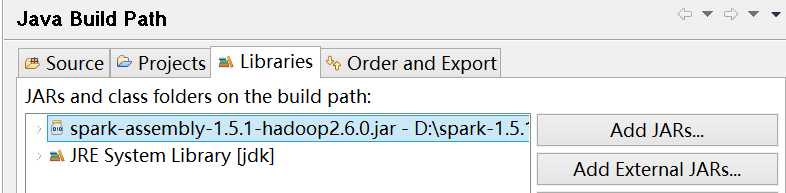

第二步、在eclipse中新建一个工程,添加依赖jar包(在解压缩spark文件夹的lib目录下,我的为D:\spark-1.5.1-bin-hadoop2.6\lib)。

注意:从spark 2.0开始没有这个jar包,需要将lib文件夹下的所有jar包添加。

第三步、使用java 8的lambda表达式编写经典的wordcount。

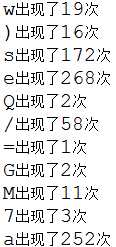

import java.util.Arrays; import org.apache.spark.SparkConf; import org.apache.spark.api.java.JavaSparkContext; import scala.Tuple2; public class test { public static void main(String[] args) { SparkConf conf = new SparkConf().setMaster("local[4]").setAppName("word count"); JavaSparkContext sc = new JavaSparkContext(conf); sc .textFile(test.class.getResource("").toString()+"README.md") .flatMap(x -> { return Arrays.asList(x.split("")); }) .mapToPair(x -> { return new Tuple2<>(x,1);}) .reduceByKey((x,y) ->{ return x+y;}) .foreach(x -> { System.out.println(x._1+"出现了"+x._2); }); sc.close(); } }运行会报错failed to locate the winutils binary in the hadoop binary path,并不影响结果,解决方法去下载对应版本的hadoop binary,我们这里去下载hadoop-2.6.0,添加环境变量path:D:\hadoop-2.6.0\bin,再次运行成功,结果截图一部分为:

今天的文章使用Eclipse构建Spark Java集成开发环境分享到此就结束了,感谢您的阅读,如果确实帮到您,您可以动动手指转发给其他人。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌侵权/违法违规的内容, 请发送邮件至 举报,一经查实,本站将立刻删除。

如需转载请保留出处:https://bianchenghao.cn/31375.html