如今还没等到 AI 具体应用带来的种种威胁,一盆凉水再次扑向如今正平稳发展的 AI 领域,让诸多想要入门 AI 的新手顿时迷失了方向,也让全力投身于 AI 领域的创业者开始了恐慌。近日,计算机视觉及 AI 领域专家 FILIP PIEKNIEWSKI 发布了一篇《AI Winter Is Well On Its Way》(AI 寒冬将至)的文章,他指出深度学习已尘埃落定、不具有扩展性、自动驾驶已奔溃,并最终预测 AI 寒冬就像预测股市的崩盘一样,虽然不可能预测它何时会发生,但几乎可以肯定它一定会发生,而且很快降临。

接下来,我们将共同解读《AI Winter Is Well On Its Way》的具体内容,并分享国内外大牛对于此事的看法,一窥 AI 寒冬是否真的到来?

以下为译文:

很多年以来,深度学习一直处于所谓的人工智能革命的前沿,很多人认为深度学习是带我们走进科技奇点(通用人工智能)的必胜法宝。2014、2015 和 2016 年间,很多公司都对深度学习深信不疑,他们积极地开拓新的疆域,例如 Alpha Go 等。特斯拉等公司的 CEO 宣布全自动驾驶汽车很快就能实现,特斯拉甚至开始向客户预售全自动驾驶功能(将来可以通过软件激活该功能)。

而现在 2018 年已经过去了一半,情况发生了变化。虽然表面上还看不出来,神经信息处理系统大会(Neural Information Processing Systems,简称 NIPS)仍然一票难求,特斯拉在新闻发布会上还频频提及人工智能,CEO 埃隆·马斯克仍然信守关于自动驾驶汽车的诺言,Google 的 CEO 仍坚守吴恩达的口号:人工智能将带来比电力革命更伟大的变革。但是这种说法已开始动摇。我曾经表示过,这种动摇最明显的地方应该是无人驾驶,这正是人工智能科技在现实世界中的一项真实应用。

深度学习的尘埃已定

当 ImageNet 得到有效解决后(请注意这并不意味着视觉问题得到了解决),该领域许多出色的研究人员(甚至包括向来低调的 Geoffrey Hinton)都活跃在媒体的采访中,在社交媒体上做宣传(例如 Yann Lecun、吴恩达、李飞飞等)。总基调无非是我们面临巨大的革命,今后技术的发展只会更快。很多年过去了,这些人在 Twitter 上也没那么活跃了,以吴恩达为例来说:

2013年:日均推文0.413条

2014年:日均推文0.605条

2015年:日均推文0.320条

2016年:日均推文0.802条

2017年:日均推文0.668条

2018年:日均推文0.263条(截至5月24日)

也许这是因为吴恩达语出惊人的言论现在被社区更加严格地审查,如下面的推文所示:

很明显公众的情绪已经大幅减弱了,称赞深度学习为终极算法的推文少了很多,论文的基调也由“变革”向“进化”转变。继 Alpha Go Zero 以来,DeepMind 再也没有出过举世震惊的新闻,而且如果考虑下 Alpha Go Zero 所需的巨大计算量以及只能应用于游戏的局限性,似乎它也并没有那么让人激动。OpenAI 非常沉寂,上次他们在媒体上大放异彩是由于在 Dota 2 的游戏中击败了人类选手(我以为这会像 Alpha Go 引起世界的轰动,但是这则消息转瞬即逝了)。事实上,很多文章开始提出,就连 Google 都不知道该如何发展 DeepMind 了,因为 DeepMind 的结果在实践显然并没有达到预期。而对于那些出色的研究人员,他们与加拿大和法国政府官员会晤,为的是保证他们将来的拨款,而 Yann Lecun 甚至卸任了 Facebook 人工智能研究负责人一职,转而担任 Facebook 人工智能首席科学家。从有钱的大公司到政府资助的研究机构的逐步转变让我意识到,这些公司(我指的是 Google 和 Facebook)对这种研究的热潮实际上正在逐步消退。这些都是早期的征兆,虽然未表于言辞,但是大家都心领神会了。

深度学习不具有扩展性

关于深度学习的一个关键的口号是它可以轻而易举的扩展规模。2012 年 AlexNet 问世,它拥有将近 6000 万个参数,现在我们的模型的参数不是至少是 AlexNet 的 1000 倍了吧?也许没错,但问题是这些模型的功能有 1000 倍吗?或者,有 100 倍吗?我们用 OpenAI 的一项研究来做说明:

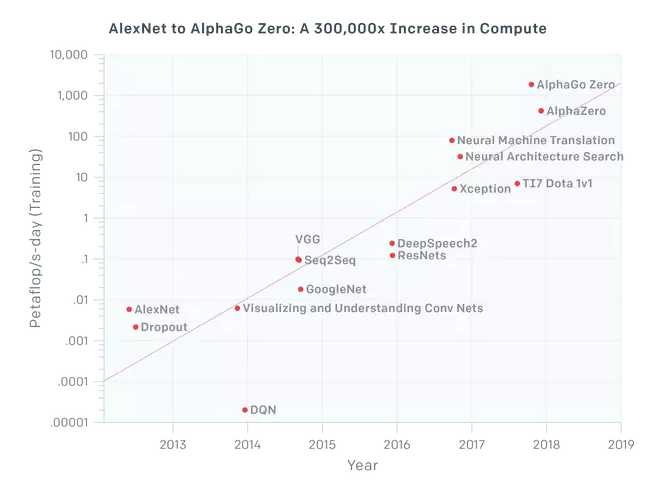

图:AlexNet 到 Alpha Go Zero:计算量提高了 30 万倍

关于视觉方面的应用,我们看到 VGG 和 Resnets 在应用的计算资源增加一个数量级时趋于饱和(它们的参数数量其实还比较少)。Xception 是 Google 的 inception 架构的一个变种,它在 ImageNet 上的表现只比 inception 好一点点,实际上可能略微胜过所有其他模型,因为从根本上来说是 AlexNet 解决了 ImageNet 的问题,所以,如果投入 AlexNet 的 100 倍的计算力,我们基本上可以说视觉(准确来说是图像分类)架构都将趋于饱和。所有大型网络搜索引擎公司都在神经网络机器翻译上付出了巨大努力,为此他们投入了所有可用的计算资源。但即使如此,Google 翻译依然做得很差(虽然很多人认为它比以前进步了很多)。上图最右边的三个点显示了与强化机器学习有关的项目,Deepmind 和 OpenAI 开发的游戏中运用了该技术。尤其是 AlphaGo Zero 和更为通用的 AlphaZero 使用了难以想象的计算力,但是大部分计算力都用来模拟和生成模型所需的海量数据,所以这种扩展在现实世界中毫无无用武之地。虽说现在我们无需花费几天的时间,只需几分钟就可以训练好 AlexNet,但是我们可以在几天内训练好 AlexNet 的 1000 倍的模型并得到相对较好的结果吗?很显然不能……

所以事实上,虽说上图旨在演示深度学习具有良好的扩展性,而结果却恰恰相反。我们无法简单地扩大 AlexNet 的规模并获得相对将好的结果,我们必须处理具体的架构,并且如果不能提升样本数据的数量级(仅在模拟游戏环境中才可行)的话,那么额外的有效计算力也毫无意义。

自动驾驶的崩溃

到目前为止,对深度学习的名声打击最大的是自动驾驶汽车(我曾从事于自动驾驶很长时间)。最初大家以为,NVIDIA 大力推广的端到端的深度学习能够解决该问题。我觉得如今这个世界上已经没人相信这个观点了(但是也有可能是我错了)。去年加利福尼亚车辆管理局的脱离报告显示,NVIDIA 车辆每次脱离人工控制连 10 英里都行驶不了。我曾在另外一篇文章中讨论过自动驾驶发展的总体情况,并与人类驾驶员的安全性进行了比较,结果都不太妙。自 2016 年以来,特斯拉的自动导航系统(AutoPilot)发生了多起事故,其中几起事故还是致命的。虽说我们不应该将特斯拉的自动导航系统与自动驾驶车辆混为一谈,但是至少它们的核心技术都是相同的。到目前为止,除了偶尔出现的严重错误以外,还常常发生在十字路口停不下来,无法识别红绿灯,甚至无法绕环岛正确行驶。到 2018 年 5 月,距离特斯拉承诺的无人驾驶车辆穿越美国行驶(这一承诺未能实施,但有传闻说他们尝试了 30 次脱离,终究未能成功,)已经过去好几个月了。几个月以前(2018年2月)当问及穿越美国行驶计划时,埃隆·马斯克反复说:

“我们本来可以实现穿越美国行驶计划,但这需要太多专门的代码来有效实现,但是代码太过具体又会让系统太脆弱,只能在某条具体的路线上很好地行驶,但不是通用的解决方案。所以我认为我们可以重复行驶某条线路,但是如果无法找到对所有路线都通用的方法的话,就不能算是真的解决方案。”

“我对我们在神经网络方面的进步感到非常激动。而且凡事都要经历从量变到质变的过程,现在我们看不到进步,但是经过日积月累,终有一天惊喜会出现。我们的自动驾驶看起来是个很蹩脚的驾驶员,但是逐步会变成还不错的驾驶员,而终有一天人们会惊喜地发现这个驾驶员好厉害。”

然而,从上图(从OpenAI)中我并没有看到突破性的发展。而且从脱离人工控制的里程数角度来看,没有任何一家大厂商做出了显著的进步。实际上上面的声明应该解读为:“我们目前没有什么技术能够安全地实现穿越美国,虽然我们其实可以作假……我们深刻希望神经网络的能力能在短期内出现指数级的增长,从而把我们从耻辱和各种官司中拯救出来。”

然而到目前为止,戳破 AI 泡沫的最大事件就是在亚利桑那州发生的 Uber 的自动驾驶导致行人死亡的事故。从 NTSB 的初步报告中我们可以看到一些令人震惊的情况:

根据从自动驾驶系统中获得的数据,系统在碰撞发生大约 6 秒前就在雷达和 LIDAR 观察系统中登记了行人,当时车辆速度为43mph。随着车辆和行人的接近,自动驾驶系统软件将行人分类为不明物体,然后分类为车辆,再分类为可能会有不同路线的自行车。直到碰撞前 1.3秒,自动驾驶系统才确定必须通过紧急刹车才能避免碰撞。据 Uber说,当车辆处于电脑控制时,紧急刹车操作并不会被启用,以减少不稳定的车辆行为的可能性。汽车依赖于驾驶员来干预并采取措施。而该系统中并没有警告驾驶员的设计。

抛开报告中提到的一般系统设计上的失败不说,在这种情形下该系统不是只做逻辑判断确保不会发生碰撞,而是需要长达数秒的时间来判断前方物体究竟是什么,是行人、自行车、车辆或其他。这其中有几个原因:首先,人们总喜欢事后诸葛亮。所以大家经常说:“我看到一辆自行车,所以我向左打轮避开了他。”大量心理物理学文献却有完全不同的解释:“人类在看到某样东西时,神经系统的快速感知回路将迅速将其解释为障碍物,然后人就会采取迅速的行动来避免障碍物,几秒钟后才意识到发生的情形,并作出语言上的解释。”日常生活中我们每天要做出大量的决定而没有表述出来,而驾驶包含很多的这些决定。用语言表达的代价很大,而且耗时,现实无法提供足够的时间。这些人类的身体机能通过十亿年的进化,保障我们的安全,而现代才出现的驾驶利用了许多这样的反射。既然这些反射并没有为驾驶技术经历专门的进化,所以可能会引发错误。车里的一只黄蜂可能引起驾驶员的膝跳反射,这可能会引起许多撞车和死亡事件。但是我们通常对三维空间、速度、预测能力、横穿马路的物体的理解是身体原始的技能,从一亿年前至今这些原始技能对人类一直非常有帮助,并且在经历了进化后更加灵敏。

但是由于大部分这些技能都无法用言辞表达,很难衡量,所以我们根本无法在这些方面上优化机器学习系统。现在用 NVIDIA 所倡导的端到端的方法,即从学习图形到映射行动,跳过言辞表达,从某些方面来说这固然没错,但是问题在于输入空间的维度异常高,但行动空间的维度却非常低。因此相对于巨大的输入信息量,“标签”的“数量”非常小。在这种情况下,模型很容易学习到虚假的关系,例如深度学习中的对抗样本就证明了这一点。因此,我们需要一个不同的范式,且前提条件是可以预测整个感知的输入,而模型采取第一步是让系统能够从现实世界抽取语义,而不是虚假的相互关系。

事实上,如果非要说我们从如火如荼的深度学习中学到了什么的话,那就是一万维的图像中包含了许多虚假的模式,而这些模式在许多图像中都会出现,因此会给我们造成一种假象,那就是分类器似乎理解了它看到的图像。而实际上真实情况远非如此,该领域的许多顶尖的研究者在经过深入研究后承认了这一点。实际上,许多顶尖研究者应该不会对我的观点感到惊讶。Yann Lecun 曾经警告,不要对 AI 感到过度兴奋,而且 AI 的冬天即将来临;甚至连当前流行的反向传播算法之父 Geoffrey Hinton 都在一次谈话中说过,有可能这一切都通向一条死路,而我们不得不重新开始。但在目前来看,媒体的大肆宣传使得没人愿意听这些言论,就算是 AI 之父的言论也没人听。

Gary Marcus 和他对宣传的反抗

其实越是处于高层次的人,越能看出这种傲慢,并且有勇气公开说出来。该领域最活跃的专家之一就是 Gary Marcus。尽管我并不同意他对 AI 的全部看法,但我们必须要承认,AI 还没有媒体对于深度学习宣传的那样强大。实际上还差得很远。Gary Marcus 有一篇精彩的博文和论文《深度学习:深刻的估计》(https://arxiv.org/abs/1801.00631)和《针对深度学习的怀疑论的回答》(https://medium.com/@GaryMarcus/in-defense-of-skepticism-about-deep-learning-6e8bfd5ae0f1)向人们说明这一点,在这两篇文章中,他细心地解释了深度学习的热潮。我很尊敬 Gary,他的行为才是真正的科学家应有的行为,而许多所谓的“深度学习明星”的行为就像是个廉价的名人而已。

结论

预测 AI 的寒冬就像预测股市的崩盘一样,虽然不可能预测它何时会发生,但几乎可以肯定它一定会发生。就像在股市崩盘之前总会有各种各样的信号,但媒体宣传过于强大,以致很多人都会忽视这些信号,即使这些信号很明显。在我看来,深度学习被大幅度冷落的信号已经相当明显(或许也包括 AI,由于这个词已经被各大企业的宣传滥用了),只不过仍在不断炒作的媒体们看不到而已。这个冬天将有多久?我不知道。之后会是什么?我也不知道。但我很肯定,冬天一定会来临,而且很可能会很快降临。

AI 寒冬是否真的来临?

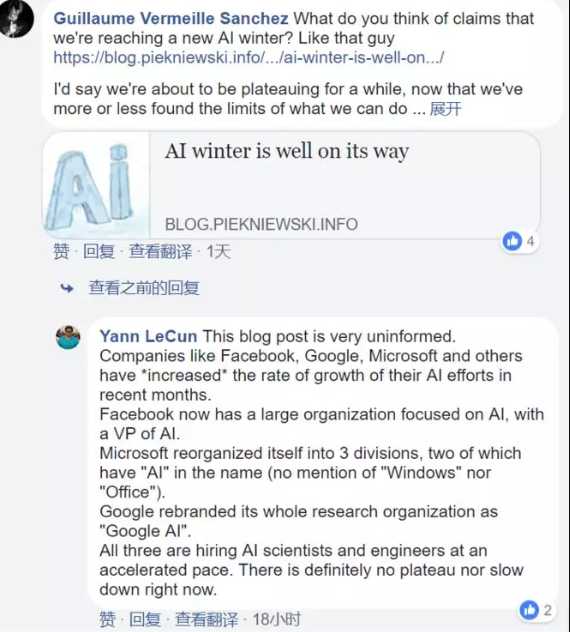

针对此番看似过激的言论,很多人一时之间也摸不清头脑,AI 领域的专家们也看法不一。身为文章中提及关键人物之一的 Facebook 首席科学家 Yann LeCun 看到这篇文章后,进行了否定,他表示:

这篇文章纯属无稽之谈,Facebook、Google、Microsoft 以及其他公司正紧密地加强 AI 布局。

Facebook 现在拥有一个专注于 AI 研究的团队。

Microsoft 事业部有三个部门,其中两个包含了“AI”名称(并没有提及“Windows”或“Office”)。

Google 将其整个研究院重命名为“Google AI”。

三家巨头在大力地招聘 AI 科学家及工程师,并没有看出减速现象。

国内,中科院院士谭铁牛实力反击 AI 寒冬言论,表示:人工智能的春天刚刚开始,未来十年,人工智能将是最具变革性的技术。今天,人工智能如日中天,火遍全球的当下,实事求是地设定科学目标显得尤为重要。

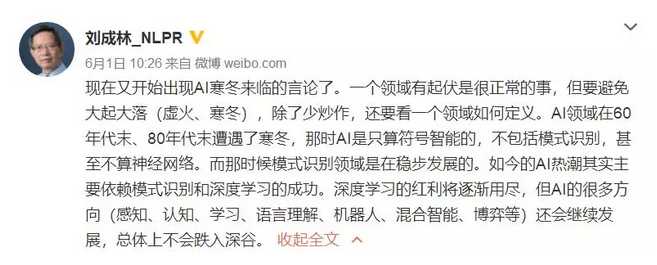

此外,中国科学院自动化研究所工学博士、研究员刘成林表示,一个领域的起伏是很正常的事情,如今只是深度学习的红利将逐渐用尽,但 AI 领域还有很多其他的方向,譬如感知、认知、学习、语言理解、机器人、混合智能、博弈等等。

AI 寒冬是否真的来临?在此笔者想到丘吉尔曾说过,「你能看到多远的过去,就能看到多远的未来」,AI 在过去六十多年的发展历程中,已经遭遇了两次寒冬期,而近几年随着深度学习的成功运用才再次火热,如今深度学习或许正在面临瓶颈期,最终也只是将人工智能带回平稳的道路上。所谓的寒冬论,也仅仅是一门技术的过渡期而已。对于此问题, Hacker News (https://news.ycombinator.com/item?id=17184054)上的网友们也表示:

-

人工智能的冬天是普通大众的期望与技术现状之间产生的落差。在过去几年间,普通公众通过媒体的大肆报道并逐渐了解了人工智能技术,且知晓自动驾驶可以在路上正常运行、机器人可以各种演示……以上的种种进展,让大众产生一种人工智能可以做任何事情、甚至可以取代人工劳动的错觉。而如今,深度学习有了瓶颈,大众也知晓人工智能并不能达到预期的所有目标,所以由此产生了 AI 寒冬论。

-

并不太确定 AI 寒冬是否真的已来临。以前要是听到“AI 寒冬”或许指的是人工智能已经到了低谷期,但如今人工智能已经获得了很好的商业应用,或许此次正在经历的是 Gartner 炒作循环周期。

-

很高兴看到这篇文章对深度学习持怀疑态度。但是我不认为 AI 寒冬来临,现在看起来我们正处于炒作周期的高峰期。它会像 SVM 之前一样扁平化。深度学习现在存在着足够的计算能力来制作非常大的模型,但不幸的是,大型模型所需的训练数据和计算能力的数量似乎超出了实际任务的实用性。

今天的文章霍金:远离 AI, 发明 AI 可能会成为人类历史上最大的灾难!分享到此就结束了,感谢您的阅读,如果确实帮到您,您可以动动手指转发给其他人。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌侵权/违法违规的内容, 请发送邮件至 举报,一经查实,本站将立刻删除。

如需转载请保留出处:https://bianchenghao.cn/33921.html