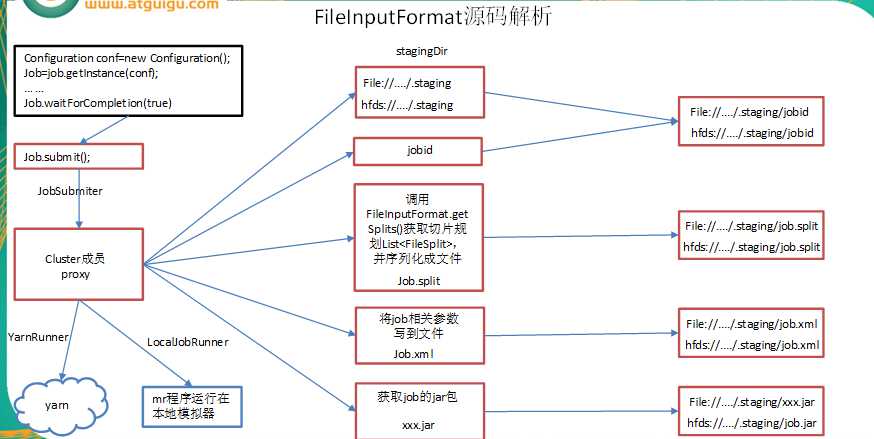

FileInputFormat源码解析(input.getSplits(job))

-

找到你数据存储目录

-

开始遍历处理(规划切片)目录下的每一个文件

-

遍历第一个文件 aa.txt

(1) 获取文件大小fs.sizeOf(aa.txt)

(2)计算切片的大小

computeSliteSize(Math.max(minSize,Math.max(maxSize,blocksize)))=blocksize=128M

(3)默认情况下,切片大小=blockSize

(4)开始切,形成第1个切片0 – 128M 第2个切片 128->256M 第3个切片256 – 300M(每次切片时,都要判断切完剩下的部分是否大于块的1.1倍),不大于就划分为一个切片

(5)将切片信息写到一个切片规划文件中

(6)整个切片的核心过程在getSplit()方法中完成

(7)数据切片只是逻辑上对数据进行切片,并不会在磁盘上将其切分成片存储,InputSplit只记录了分片的元数据信息,比如起始位置,长度,以及所在节点列表等

(8)注意:block是HDFS上物理上存储的数据,切片时对数据逻辑上的划分 -

提交切片规划文件到yarn上,yarn上的MrAppMaster就可以根据切片规划文件计算开启maptask个数

FileInputFormat中默认的切片机制:

(1) 简单按照文件内容的长度进行切片

(2)切片大小,默认等于block大小

(3)切片不考虑数据集整体,而是逐个对每一个文件的单独切片

比如待处理数据有两个文件:

file1.txt 320M

file2.txt 10M

经过FileInputFormat的切片机制运算后,形成的切片信息如下:

file1.txt.split1-- 0~128

file1.txt.split2-- 128~256

file1.txt.split3-- 256~320

file2.txt.split1-- 0~10M

FileInputFormat切片大小的参数配置

(1)通过分析源码,在FileInputFormat中,计算切片大小的逻辑

Math.max(minSize, Math.min(maxSize, blockSize));

切片主要由

mapreduce.input.fileinputformat.split.minsize=1 默认值为1

mapreduce.input.fileinputformat.split.maxsize= Long.MAXValue 默认值Long.MAXValue

因此,默认情况下,切片大小=blocksize。

maxsize(切片最大值):参数如果调得比blocksize小,则会让切片变小,而且就等于配置的这个参数的值。

minsize (切片最小值):参数调的比blockSize大,则可以让切片变得比blocksize还大

获取切片信息API

// 根据文件类型获取切片信息

FileSplit inputSplit = (FileSplit) context.getInputSplit();

// 获取切片的文件名称

String name = inputSplit.getPath().getName();

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌侵权/违法违规的内容, 请发送邮件至 举报,一经查实,本站将立刻删除。

如需转载请保留出处:https://bianchenghao.cn/38550.html