原文:Bottom-Up and Top-Down Attention for Image Captioning and Visual Question Answering

摘要:自上而下注意力机制已经被广泛应用于图片描述(image caption)和视觉问答(visual question answering),提升了模型在更深层次的图像理解和多步推理中的表现。本文提出了一个将自下而上和自上而下注意力机制结合起来实现在object层面的注意力计算,其中自下而上注意力(基于faster r-cnn)实现图像候选框提取,每一个候选框都有相应的特征向量,而自上而下的注意力机制则用来分配不同候选框特征向量的权重。通过在MSCOCO数据集上的图片描述任务进行实验,相关指标达到了当前的SOTA;在2017年VQA challenge比赛上也取得了第一的成绩。

- Apporach

给定一张图片I,图片描述模型和VQA模型都将图片的k个图像特征向量(

)作为输入,每一个图像特征向量都是图片中某一个区域的特征表示。图像特征V为模型bottom-up attention模型的输出,后面会介绍bottom-up attention模型的具体结构。

)作为输入,每一个图像特征向量都是图片中某一个区域的特征表示。图像特征V为模型bottom-up attention模型的输出,后面会介绍bottom-up attention模型的具体结构。

1.1 bottom-up attention模型

本文中我们采用Faster R-CNN模型来定义图像区域,基于bottom-up attention来获取图像特征。

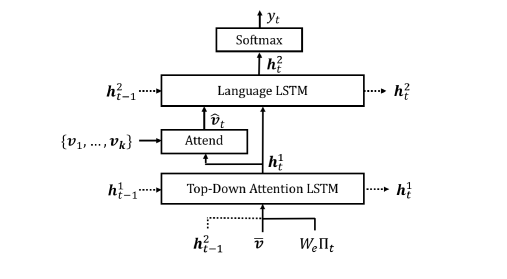

1.2 Captioning model

给定一组图片特征V,本文提出的captioning模型采用soft的自上而下注意力机制来计算每个图像特征在描述生成过程中的权重,其中已经生成的文本序列作为上下文。

具体而言,captioning模型由两个LSTM层组成,每个LSTM的实现方式可以概括为:

其中

是LSTM的输入,

是LSTM的输入,

是LSTM的输出。

是LSTM的输出。

1.2.1 自上而下注意力的LSTM

在captioning模型中,我们把第一个LSTM层称为自上而下的视觉注意力模型(attensionLSTM),第二个LSTM层成为语言模型(languageLSTM)。attentionLSTM每一时步的输入向量包括上一时步languageLSTM输出向量、平均池化后的图像特征向量和已经生成文字的encoding向量进行concatenate拼接的结果:

其中

是关于词表Σ的词向量矩阵,

是关于词表Σ的词向量矩阵,

为t时刻输入词的one-hot向量表示。本文的词向量矩阵是通过随机初始化学习获得,并没有利用预训练词向量。在给定attentionLSTM的输出

为t时刻输入词的one-hot向量表示。本文的词向量矩阵是通过随机初始化学习获得,并没有利用预训练词向量。在给定attentionLSTM的输出

条件下,我们会为k个图像特征

条件下,我们会为k个图像特征

计算一个attention权重

计算一个attention权重

,

,

其中

都是需要学习的网络参数。经过attention后的图像特征将作为languageLSTM的输入来融合所有的输入图像特征:

都是需要学习的网络参数。经过attention后的图像特征将作为languageLSTM的输入来融合所有的输入图像特征:

1.2.2 languageLSTM

languageLSTM的输入包括attention后的图像特征,以及attentionLSTM的输出,即:

用

表示词序列

表示词序列

…

…

,在t时刻,要输出的词的概率分布为:

,在t时刻,要输出的词的概率分布为:

最终生成序列的概率为:

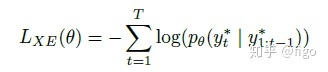

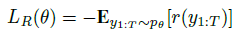

1.2.3 目标函数

image caption模型的优化函数为最小化如下的交叉熵损失:

为了和其他模型对比,我们也给出了相应的CIDEr指标结果。以上述训练好的交叉熵损失为目标函数的模型为初始模型,我们来最小化如下的期望函数:

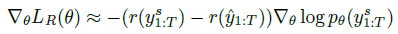

其中r表示CIDEr,根据SCST的优化思路,上述损失函数的梯度可以估计为:

1.3 VQA模型

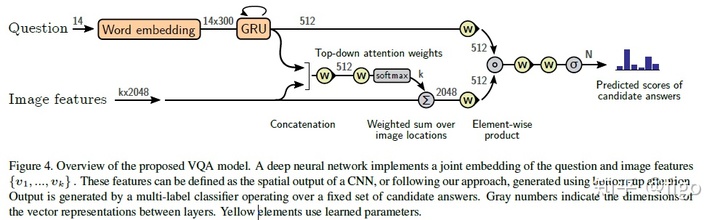

本文提出了一个基于soft自上而下注意力机制的VQA模型,采用question的特征表示作为上下文向量来计算图像特征权重,如下图所示。首先将question进行GRU编码,得到隐含还在那状态q,通过将图像和question多模态特征融合,最后获得在候选答案集上的概率分布,概率最高的候选答案即为最终答案。

2. 实验结果

采用VG数据集来预训练bottom-up attention模型,然后在训练VQA模型的时候仍采用VG数据集进行数据增强。数据集包括108k张图像以及相关的目标、属性和关系标注,以及1.7M的答案。

在训练bottom-up attention模型的时候,只采用了目标和属性数据,其中训练集图片98K,测试集和验证集各5K。

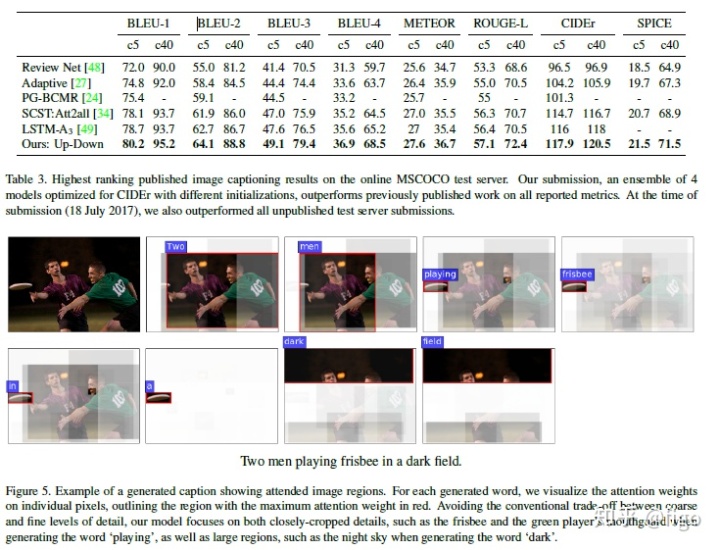

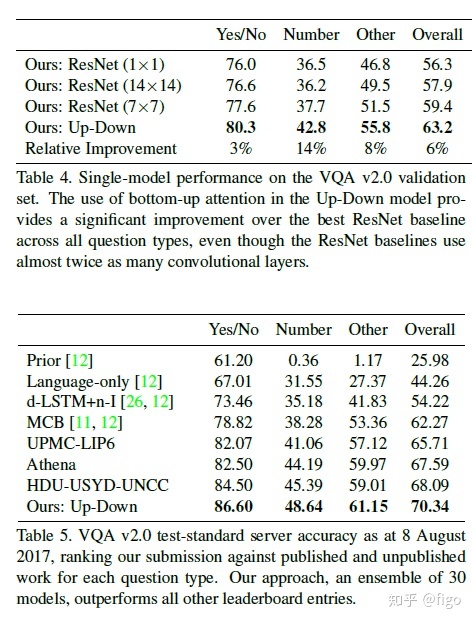

实验结果如下。

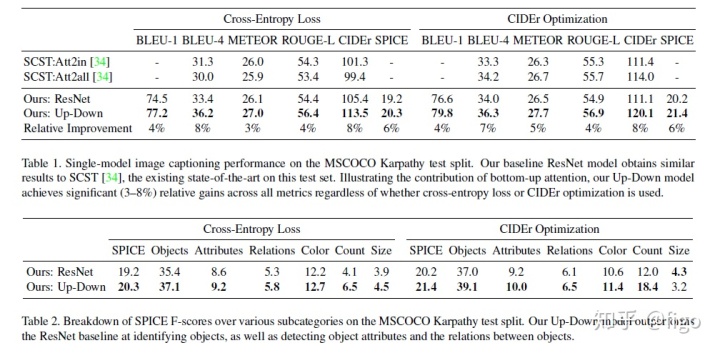

表1为本文提出的模型(Resnet baseline)和已有的SOTA模型SCST在image caption上的表现对比,两个模型都采用标准的交叉熵损失,并基于CIDEr进行优化。从结果看,本文提出的模型要稍微优于SCST

VQA的结果如下图所示。

今天的文章基于注意力机制的lstm实现_基于自下而上和自上而下注意力机制的图片描述和视觉问答…分享到此就结束了,感谢您的阅读,如果确实帮到您,您可以动动手指转发给其他人。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌侵权/违法违规的内容, 请发送邮件至 举报,一经查实,本站将立刻删除。

如需转载请保留出处:https://bianchenghao.cn/40082.html