原文链接: http://places2.csail.mit.edu/PAMI_places.pdf

摘要

数百万项的数据集的兴起,让机器学习算法在物体和场景的识别等任务上可以接近人类语义分类的表现。

Places数据集,有1000万张场景分类图片,用场景语义类别作标签,包括世界上大量类型的环境类型。

利用最先进的CNN,作者提供了(Places-CNNs)作为baseline,明显优于以前的方法。

在Places上CNN训练的可视化(visilization of the CNNs trains Places)说明物体识别作为场景分类的中间表示而出现。

Places数据集和Places-CNNs有着高覆盖率和高多样性样例,提供了一种新型的资源引导未来场景识别问题的进展。

1 INTRODUCTION

如果一个最新的视觉识别系统告诉你一段文本,上面写着它看到了什么,这段文本可能读起来像这样”有一张沙发面朝着电视机,一个人拿着遥控器坐在沙发上,电视开着在播放着脱口秀。”读到这里,你可能会想象一个卧室,但是,这个场景也很有可能发生在一个海滩度假胜地。

毫无疑问物体(object)和事件(event)的识别是这个视觉系统的基本目标。但是知道地点(place)或文本(context)是由哪个object表现出来的对一个智能系统理解过去发生了什么、未来发生什么也很重要。举个例子,一张桌子在厨房里能用来吃饭或者准备烧饭,而一张桌子在教室里可以用来放笔记本或者笔记本电脑来记笔记。

场景分类的一个关键是去识别物体所在的位置,像沙滩、森林、走廊、办公室、街道…我们可以通过提供图片中的物体的详尽列表和这些物体的空间关系来描述场景,而不是使用场景类别来描述,但是使用场景类别提供了一种合适的抽象层面来避免又长又复杂的描述。注意,我们可以在描述中只列出部分物体类别,像两个眼睛在嘴巴上面就是一张脸。和物体一样,地点也有着相同的相同和属性。他们是由一部分一部分组成,这些part可以被命名并和相应的物体相关联,就像有些是由其他部分组成的物体的命名,比如说腿、眼睛。

然而大部分数据集都聚焦到物体的类别(提供的标签、bounding boxes和分割),作者提出了Places数据集,一个既数量多又很详尽的有着1000万张场景图片的数据集,有着434个场景语义类别,包括了人类可以在地球上经历的98%的场景。

图1是这些图片的例子,图2是每个类别的图片数量(降序排)

和下面这篇区分,作者描述places数据集的深度建设,并评估它在几个最新卷积神经网络上面的地点识别性能。

B. Zhou, A. Lapedriza, J. Xiao, A. Torralba, and A. Oliva, “Learning

deep features for scene recognition using places database,” in In

Advances in Neural Information Processing Systems, 2014.

作者评估最新的几个cnn在场景分类中的性能。作者比较在其他可视的识别任务中被认作通用特征的特征怎样在场景分类的cnn中学习的表现。最后,作者可视化了cnn的内部表现并讨论了用训练深度学习模型来表现场景分类的一个重要结论:物体的检测是网络的一个内部中间表现。因此,places数据库没有包含任何物体标签或分割,它能成为去训练新物体的分类器。

1.1 数百万数据集的出现

机器学习算法是怎样达到人类水平的表现的?在监督学习中,这个问题是两面的。首先,这个算法一定要适合这个任务,像CNN用在大规模的视觉识别中,RNN用在自然语言处理中;其次,要获得适当覆盖率和多样性的训练数据集,这些数据集的最优空间往往取决于任务,但是百万级数据集的兴起在很多人工智能领域激起了空前的表现。

1.2 以场景为中心的数据集

场景分类的第一基准是Scene15数据集,从下文中最初的8个数据集而来

A. Oliva and A. Torralba, “Modeling the shape of the scene: A holistic

representation of the spatial envelope,” Int’l Journal of Computer

Vision, 2001.

这个数据集只包括15个场景类别和每个类百来张图片,现在的分类器已经饱和,达到人类95%的表现。MIT indoor67数据库有67个室内的类别,SUN数据集(Scene Understanding有397个类别和130519张图片)提供了场景类别的更大覆盖,但缺点需要被喂到深度学习算法里的数据数量太少。为了像imagenet那样补足大量以物体为中心的数据集,作者构建了Places数据集。

同时,Pascal VOC数据集是最早用场景语义描述的有着多种物体标注的图像数据集之一,Pascal VOC竞赛大大加速了物体识别和分割任务模型的进程。现在,COCO数据集收集描绘日常生活中常见的图像的物体的实例在多边形和边界盒子上的注释。

2 places数据集

2.1 类别空间的覆盖

2.2 数据集怎么构造的

1, Downloading images using scene category and attributes

2,Labeling images with ground truth category

3 places benchmark

- Places365-Standard拥有1,803,460张训练图像,每个类的图像数量从3,068到5,000张不等。验证集每个类有50个图像,测试集每个类有900个图像。注意,本文的实验是在Places365Standard上报道的。

- Places365-Challenge包含与Places365-Standard相同的类别,但训练集要大得多,总共有800万张训练图像。验证集和测试集与Places365-Standard相同。

- Places205,拥有来自205个场景类别的250万张图片。每个类的图像数量从5000到15000不等。训练集共有2,448,873张图像,验证集每个类别100张图像,测试集每个类别200张图像。

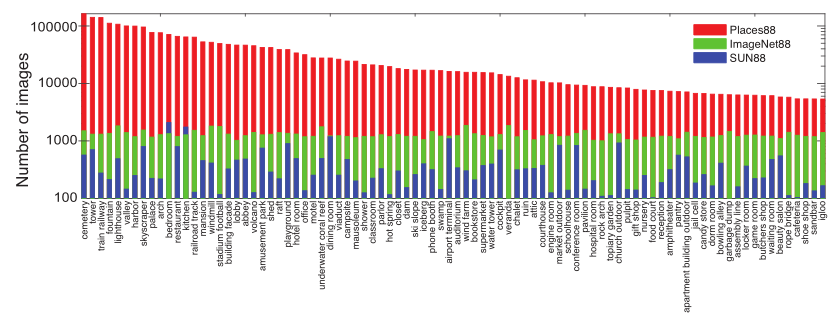

- Places88包含了ImageNet[12]、SUN[16]和Places205数据库中的88个常见场景类别。

4 以场景为中心的数据集比较

同样的88个类别,places88和imagenet88和sun88的比较:

相似性度量,提出了Simpson index of diversity 。

如果集合A比集合B更多样化,那么集合B中两张随机的图像比来自集合A的两张随机样本在视觉上更有可能相似。

A相对于B的多样性可以定义为:

根据相对多样性的定义,当且仅当DivB(A) > DivA(B)时,A比B更多样化。

在三个数据集上每个类别取4对数据,共12对数据。共88个类,对每个类别做40次试验,每次试验用两个观察者。

结果表明,三个数据集之间的多样性存在较大差异,表明三个数据集中地方的多样性最大。对于Places,每个数据集的平均相对多样性为0.83,ImageNet88为0.67,SUN为0.50。在三个数据集中差异最大的类别是操场、阳台和候车室。

4.2 交叉数据泛化

在这三种情况下,对于固定数量的训练示例,在同一个数据集上进行训练和测试可以提供最佳的性能。由于Places数据库非常大,当所有的训练数据都被使用时,它在两个测试集上取得了最好的性能。

5 用于场景分类的卷积神经网络

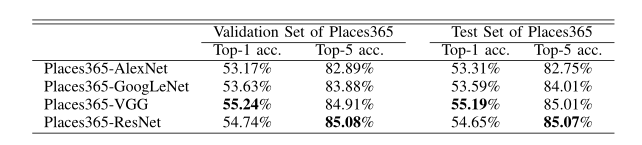

主要选了三个CNN结构:AlexNet、GoogleNet、VGG16,然后分别在places205和places365上训练baselineCNN模型。训练好的模型的命名是:Place类别的数量-模型的名称。(eg.Places205-AlexNet,Places365-VGG)

此外,还对places365-ResNet上的ResNet152进行微调,并将其和其他placesCNNs模型在场景分类上进行比较。

5.1 Places205和Places365上的结果

top1预测结果最高的那个为正确结果,top5预测结果可能性最高的5个中存在正确结果。由于场景分类具有一定模糊性,因此用top5更合适些。

由于Places205-GoogLeNet和Places205-VGG的结构更深,它们的表现远远好于Places205-AlexNet。

这张表和上一张表比较可以看到虽然365比205多了160个类别,但是top5却并没有差很多。

为了评估额外的类别如何带来改进,作者计算了Places205和Places365之间182个常见类别的准确性。在Places365的验证集上,选择182个常见类别的图像,然后分别使用Places205-AlexNet和Places365- AlexNet来预测标签。Places205-AlexNet的top1准确率为0.572,Places365-AlexNet是0.577。因此,Places365-AlexNet不仅可以预测更多的类别,而且对以前已有的类别也有更好的准确性。

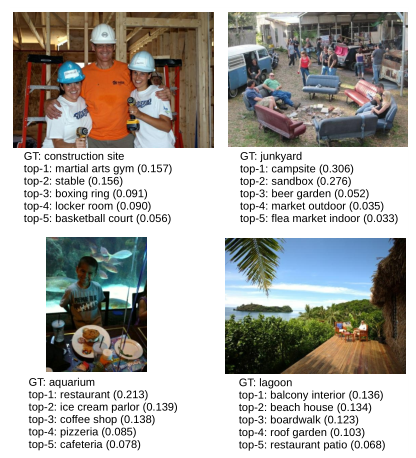

上图是一些正确的预测。

上图是一些错误的预测,从广义上讲,根据目前对地点的标签归属,我们可以识别出两种错误分类:1)发生在某个场景中的不太典型的活动,比如在建筑工地拍照和在垃圾场露营;2)图像由多个场景部分组成,一个真实场景标签不足以描述整个环境。这些结果表明需要使用多个真实值标签来描述环境。

对于许多场景类别,top1可能是一个不明确的衡量标准,环境在其语义描述方面本质上是多标签的。不同的观察者会使用不同的术语来指代同一个地方,或者同一个环境的不同部分,所有的标签可能都很适合场景的描述。

5.2 场景识别网页demo

作者提供了一个网页,上传照片会判断场景,网址是. http://places.csail.mit.edu/demo.html

试了一张教室的图。

5.4 Places-CNNs和ImageNet-CNNs上的通用视觉特征

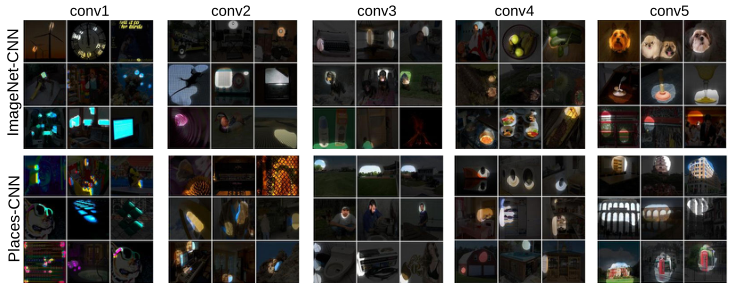

5.5内部单元的可视化

通过可视化,我们可以更好的理解在ImageNet上训练的以物体为中心的CNN和在Places上训练的以场景为中心的CNN有什么不同,因为它们共享相同的架构AlexNet。

B. Zhou, A. Khosla, A. Lapedriza, A. Oliva, and A. Torralba, “Object

detectors emerge in deep scene cnns,” International Conference on

Learning Representations, 2015.

用上面文章中提到的方法,将100,000张已加载的测试图像输入到两个网络中,分别记录每幅图像在整个空间特征图中汇集的每个单元的最大激活量。对于每个单元,通过最大激活度排序得到前三名的图像,然后通过双线性上采样二值化空间特征图掩模对图像进行分割。

不同层单元的图像分割结果如上图。我们可以看到,从conv1到conv5,每个单元的视觉概念从低级的边缘/纹理到高级的物体/场景部分。

此外,在以物体为中心的image – cnn的conv5层中有更多的检测物体部分的单元,如狗和人的头部;而在以场景为中心的Places cnnde conv5层中有更多的检测场景部分的单元,如床、椅子、建筑物等。

不同层单元的图像分割结果如上图所示。可以看到:

从conv1到conv5,单元检测的视觉概念从低级的边缘/纹理到高级的物体/场景部分。此外,在以物体为中心的image – cnn中,在conv5层中有更多的检测物体部分的单元,如狗和人的头部,而在场景为中心的image – cnn中,在conv5层中有更多的场景部分的单元,如床、椅子、建筑物等。

上表中以物体为中心的CNN和以场景为中心的CNN中,单元的特殊性在各种识别基准上产生了非常不同的一般视觉特征性能。我们进一步利用下面这里

[41]A. Nguyen, A. Dosovitskiy, T. Yosinski, Jason band Brox, and J. Clune, “Synthesizing the preferred inputs for neurons in neural networks via deep generator

networks,” In Advances in Neural Information Processing Systems, 2016.

中提出的图像合成技术合成了place – cnn的首选输入图像。该方法使用一个学习过的先验深度生成器网络来生成图像,使place cnn的最终类激活或中间单元激活最大化。

50个场景类别的合成图像如下图所示。

这些抽象的图像内容揭示了由place-cnn学习和记忆的特定场景的知识,如,在公交车站的道路环境中的公共汽车,在营地中被森林类型特征包围的帐篷。这里我们使用了Places365-AlexNet(其他Places365-CNNs也产生了类似的结果)。

我们进一步利用合成技术在Places365-AlexNet的conv5层生成单元所喜欢的图像。如下图所示,根据单元估计的接受域,合成的图像与分割的图像区域非常相似。

在Places365-AlexNet中,conv5单元所选择的合成图像与这些单元的接收域所分割出的图像相对应。合成的图像与单元分割后的图像区域非常相似。每一行分割的图像对应一个单元。

coco:Common Objects in Context

今天的文章Places: A 10 million Image Database for Scene Recognition分享到此就结束了,感谢您的阅读。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌侵权/违法违规的内容, 请发送邮件至 举报,一经查实,本站将立刻删除。

如需转载请保留出处:https://bianchenghao.cn/60836.html