关于学习率

学习率主要用在神经网络的反向传播中,用来调节参数,但学习率的选取很重要,当学习率选取过大时,如下图黄线所示,参数会跳过使损失函数最低的参数,这样有可能使损失变得更大,而选取较小时,网络的训练时间会比较长,迟迟到达不了最低点。所以对于学习率的选取要十分小心。

为什么要自适应选取学习率

原因主要是:因为我们在训练过程中,我们希望在刚开始的时候,学习率可以大一些,这样可以加速收敛,而越往后,我们希望学习率可以更小一些,因为快接近最低损失点了, 如何学习率还是很大,很容易跳过最低点,所以我们选择自适应选取学习率。在介绍如何自适应选取学习率前,先看一个例子。

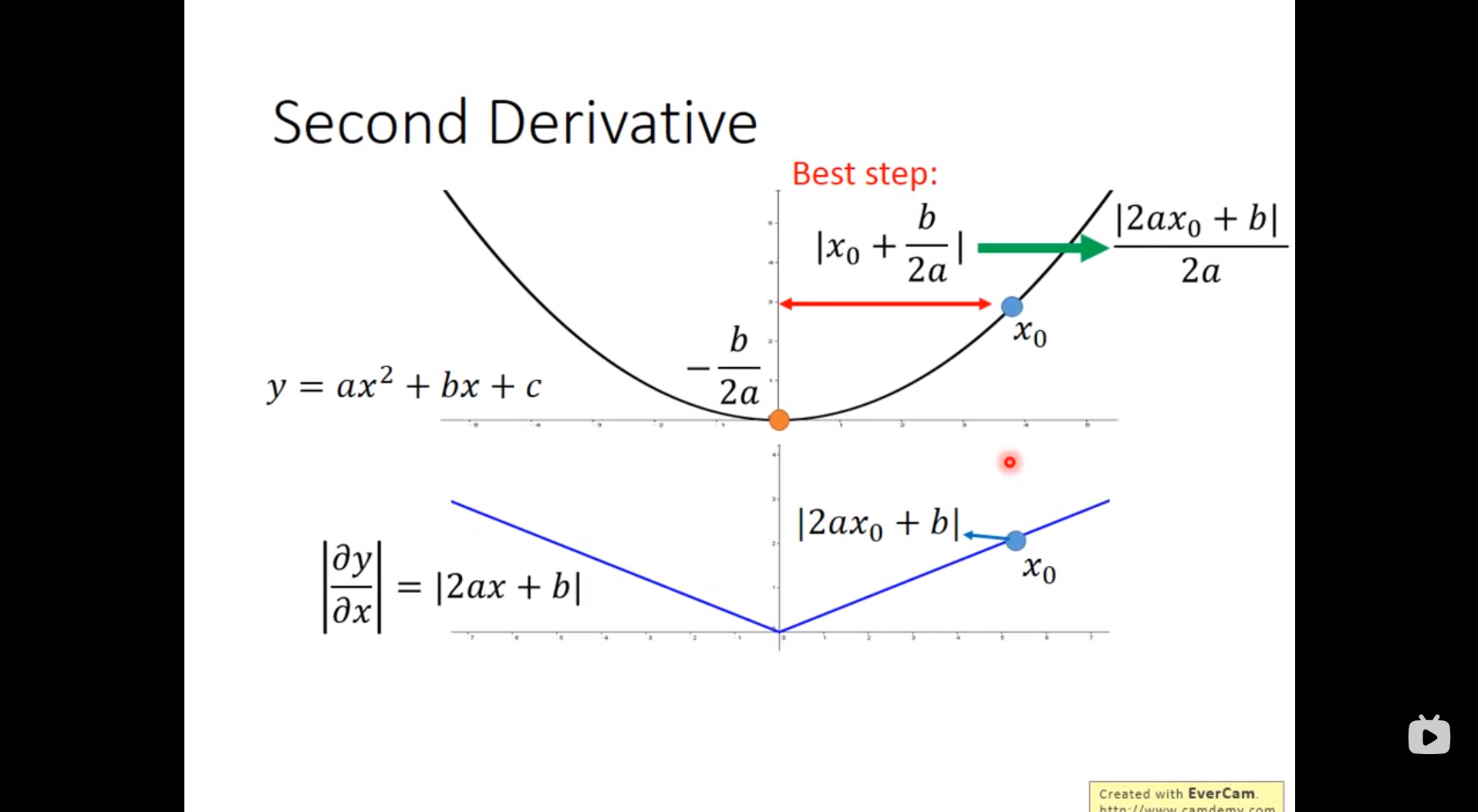

假如我们的model使一个二次函数,如下图,我们现在所处的位子是X0点,我们像到达最低点,那么我们的步伐多大最合适呢,可以看到,当我们的步伐等于一次微分/二次微分的时候我们正好可以到达最低点!

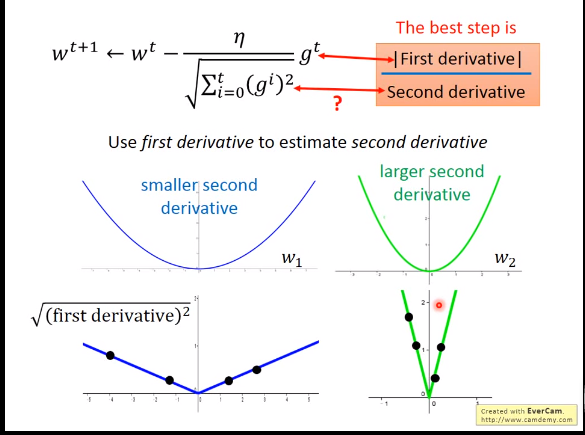

所以,为了自适应选择学习率,我们同样可以借鉴上述的方法。因为当model比较复杂时,我们求取二次微分会比较复杂,所以选取函数来代替二次微分,如下图所示:

这就是自适应选取学习率所采取的概念!

今天的文章关于Learing Rate(学习率)、Adagrad(自适应选取学习率)分享到此就结束了,感谢您的阅读。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌侵权/违法违规的内容, 请发送邮件至 举报,一经查实,本站将立刻删除。

如需转载请保留出处:https://bianchenghao.cn/81633.html