CVPR官方下载:

主会论文:https://openaccess.thecvf.com/CVPR2022

Workshop论文:https://openaccess.thecvf.com/CVPR2022_workshops/menu

目录

- 一、2D目标检测

-

- [1] SIGMA: Semantic-complete Graph Matching for Domain Adaptive Object Detection(SIGMA:域自适应目标检测的语义完全图匹配)

- [2] A Dual Weighting Label Assignment Scheme for Object Detection(一种用于目标检测的双重加权标签分配方案)

- [3] MUM : Mix Image Tiles and UnMix Feature Tiles for Semi-Supervised Object Detection(MUM:混合图像块和 UnMix 特征块用于半监督目标检测)

- [4] Unknown-Aware Object Detection: Learning What You Don’t Know from Videos in the Wild(未知感知对象检测:从野外视频中学习你不知道的东西)

- [5] Accelerating DETR Convergence via Semantic-Aligned Matching(通过语义对齐匹配加速DETR收敛)

- [6] Localization Distillation for Dense Object Detection(密集对象检测的定位蒸馏)

- [7] OW-DETR: Open-world Detection Transformer(开放世界检测transformer)

- [8] Overcoming Catastrophic Forgetting in Incremental Object Detection via Elastic Response Distillation(通过弹性响应蒸馏克服增量目标检测中的灾难性遗忘)

- [9] AdaMixer: A Fast-Converging Query-Based Object Detector(一种快速收敛的基于查询的对象检测器)(Oral)

- [10] Multi-Granularity Alignment Domain Adaptation for Object Detection(用于目标检测的多粒度对齐域自适应)

- [11] Interactron: Embodied Adaptive Object Detection(体现自适应目标检测)

- [12] Label, Verify, Correct: A Simple Few Shot Object Detection Method(标签、验证、正确:一种简单的小样本物体检测方法)

- [13] Sylph: A Hypernetwork Framework for Incremental Few-shot Object Detection(用于增量少样本目标检测的超网络框架)

- [14] QueryDet: Cascaded Sparse Query for Accelerating High-Resolution Small Object Detection(QueryDet:用于加速高分辨率小目标检测的级联稀疏查询)

- [15] End-to-End Human-Gaze-Target Detection with Transformers(使用 Transformer 进行端到端的人眼目标检测)

- [16] Progressive End-to-End Object Detection in Crowded Scenes(拥挤场景中的渐进式端到端对象检测)

- [17] Real-time Object Detection for Streaming Perception(用于流感知的实时对象检测)

- [18]【小目标检测】Oriented RepPoints for Aerial Object Detection(面向空中目标检测的 RepPoints)

- [19] Confidence Propagation Cluster: Unleash Full Potential of Object Detectors(信心传播集群:释放物体检测器的全部潜力)

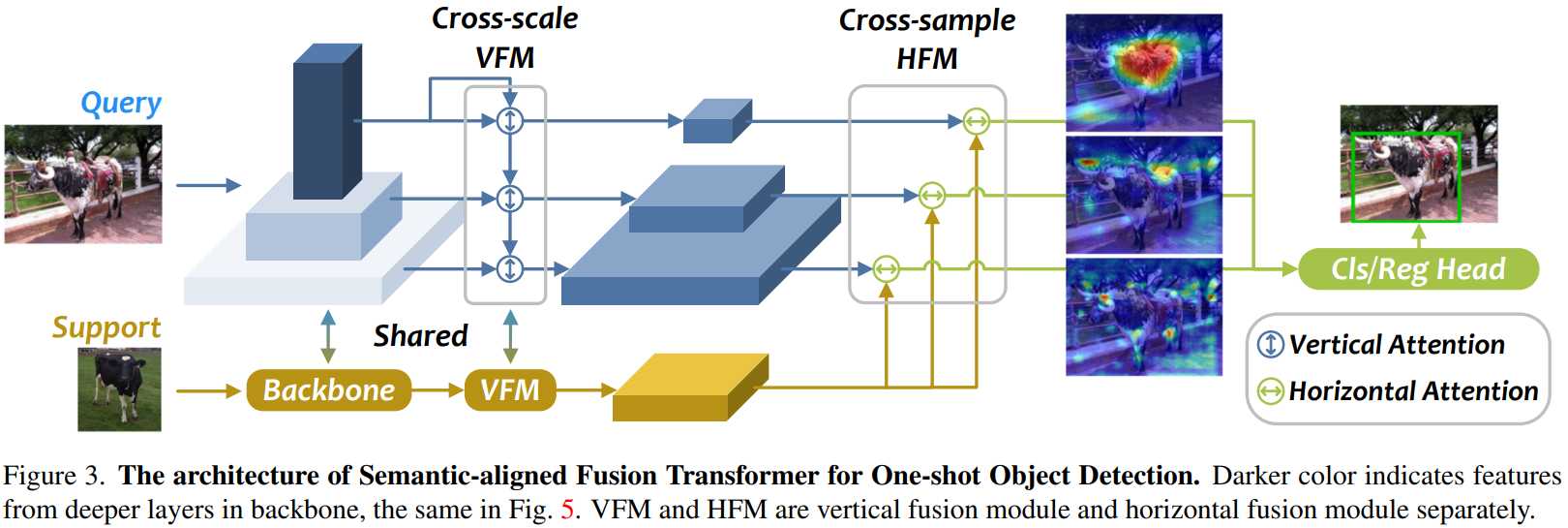

- [20] Semantic-aligned Fusion Transformer for One-shot Object Detection(用于一次性目标检测的语义对齐融合转换器)

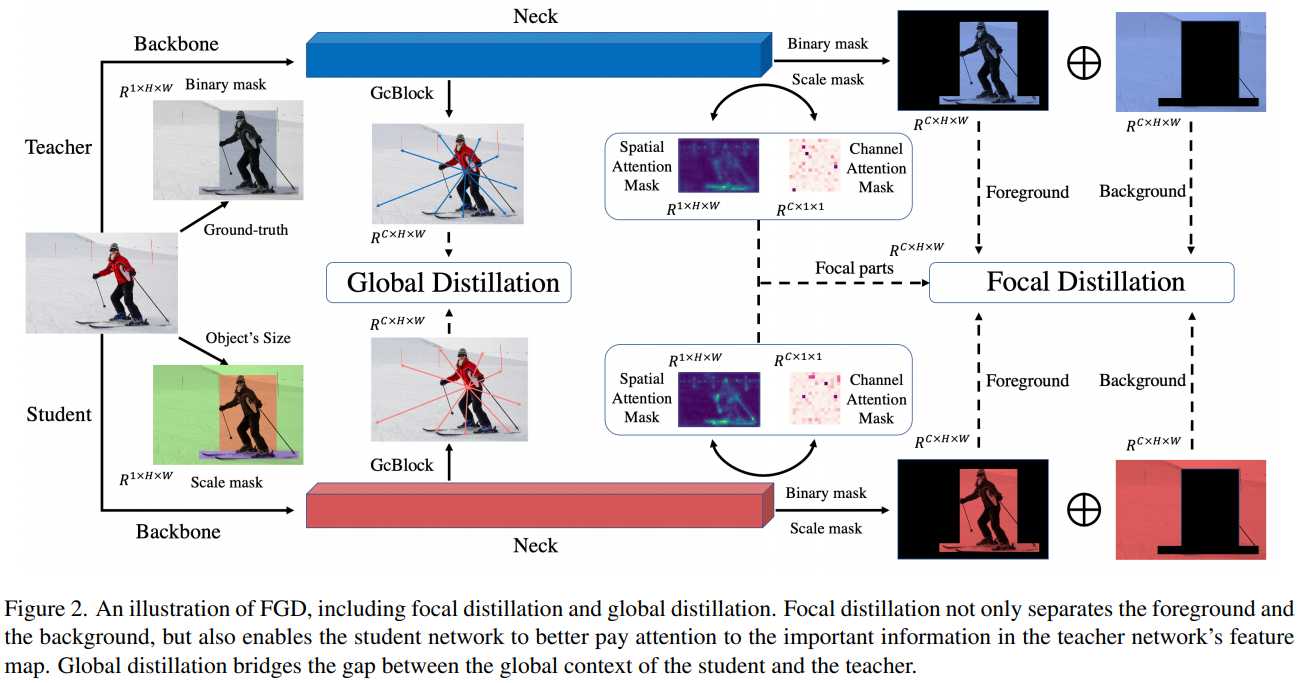

- [21]【知识蒸馏】Focal and Global Knowledge Distillation for Detectors(探测器的焦点和全局知识蒸馏)

- 二、其他

-

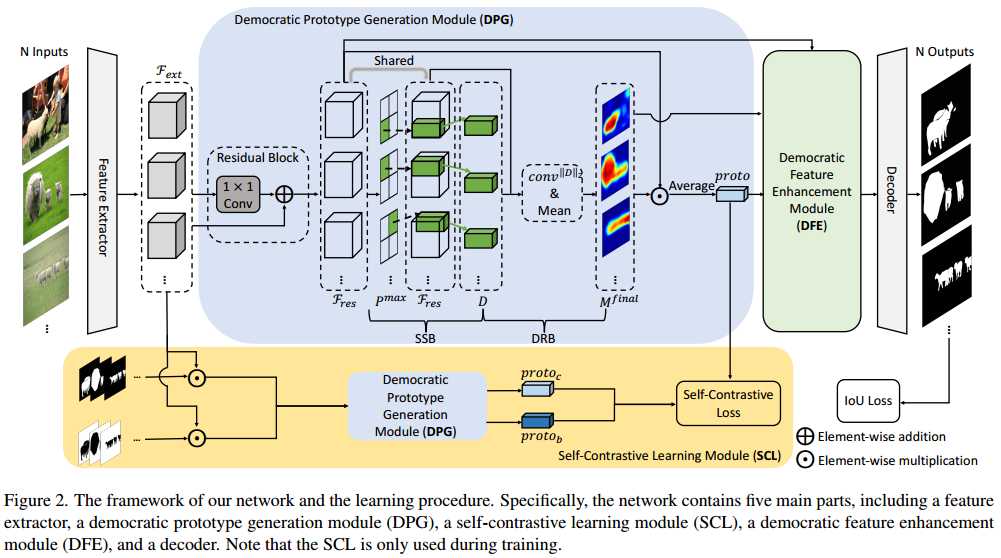

- [1]【显著性目标检测】Democracy Does Matter: Comprehensive Feature Mining for Co-Salient Object Detection(共同显著性目标检测的综合特征挖掘)

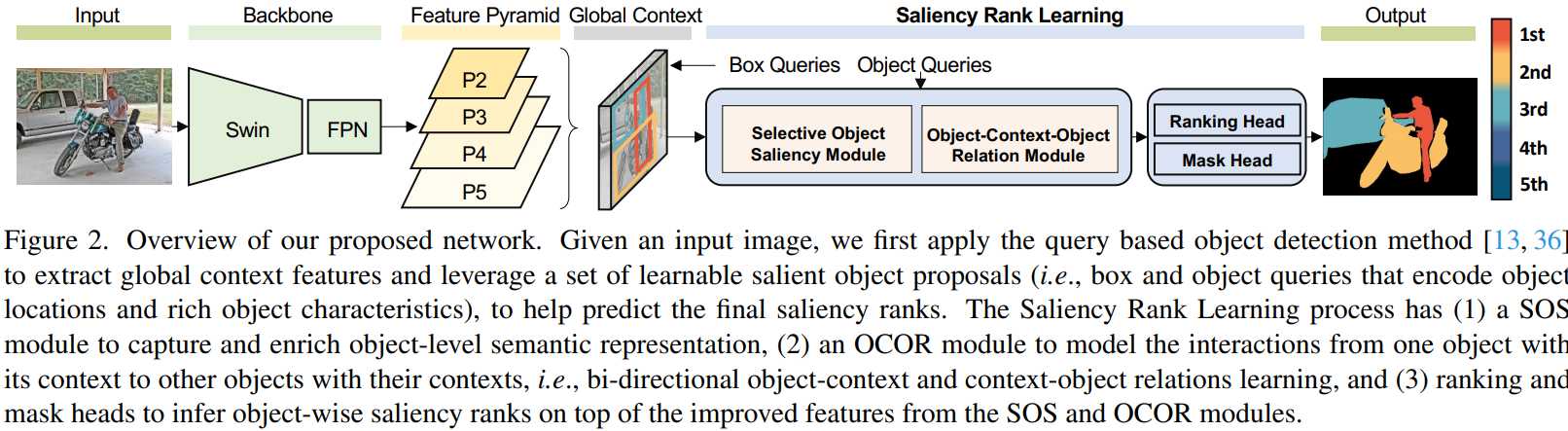

- [2]【显著性目标检测】Bi-directional Object-context Prioritization Learning for Saliency Ranking(显着性排名的双向对象上下文优先级学习)

- [3]【3D目标检测】Canonical Voting: Towards Robust Oriented Bounding Box Detection in 3D Scenes(规范投票:面向三维场景的鲁棒包围盒检测)

- [4]【3D目标检测】Back to Reality: Weakly-supervised 3D Object Detection with Shape-guided Label Enhancement(回到现实:带有形状引导标签增强的弱监督 3D 对象检测)

- [5]【3D目标检测】Point Density-Aware Voxels for LiDAR 3D Object Detection(用于 LiDAR 3D 对象检测的点密度感知体素)

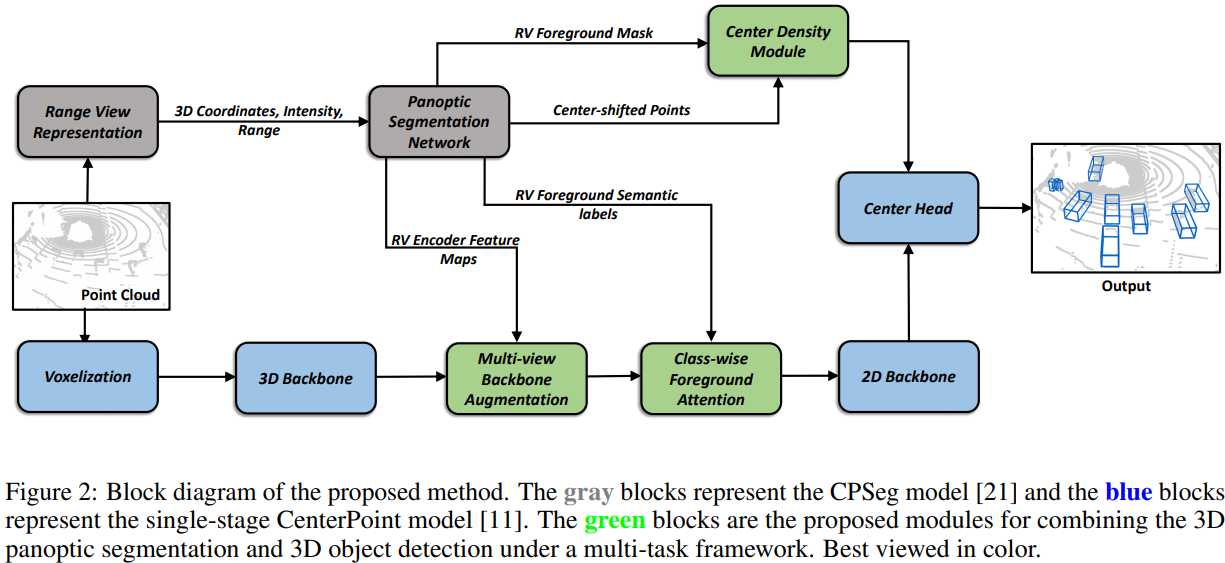

- [6]【3D目标检测】A Versatile Multi-View Framework for LiDAR-based 3D Object Detection with Guidance from Panoptic Segmentation(在全景分割的指导下,用于基于 LiDAR 的 3D 对象检测的多功能多视图框架)

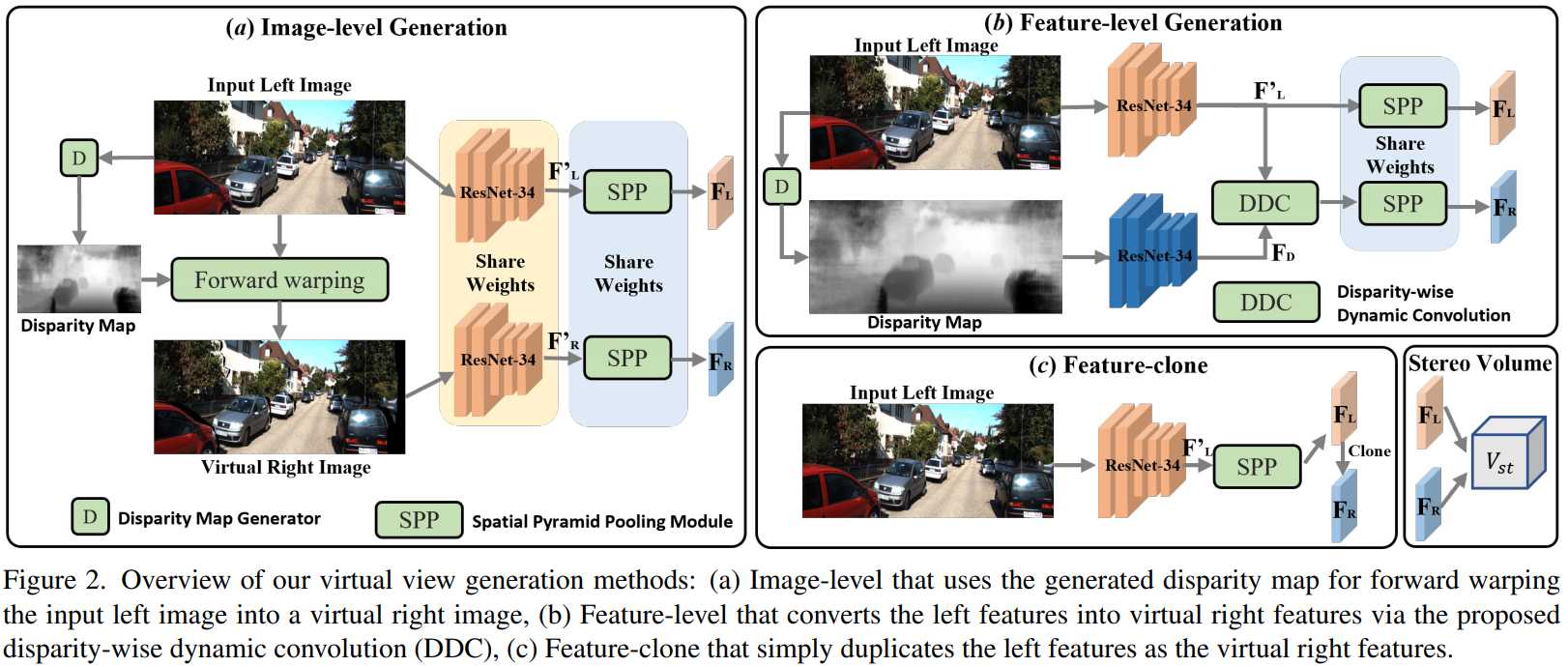

- [7]【3D目标检测】Pseudo-Stereo for Monocular 3D Object Detection in Autonomous Driving(自动驾驶中用于单目 3D 目标检测的伪立体)

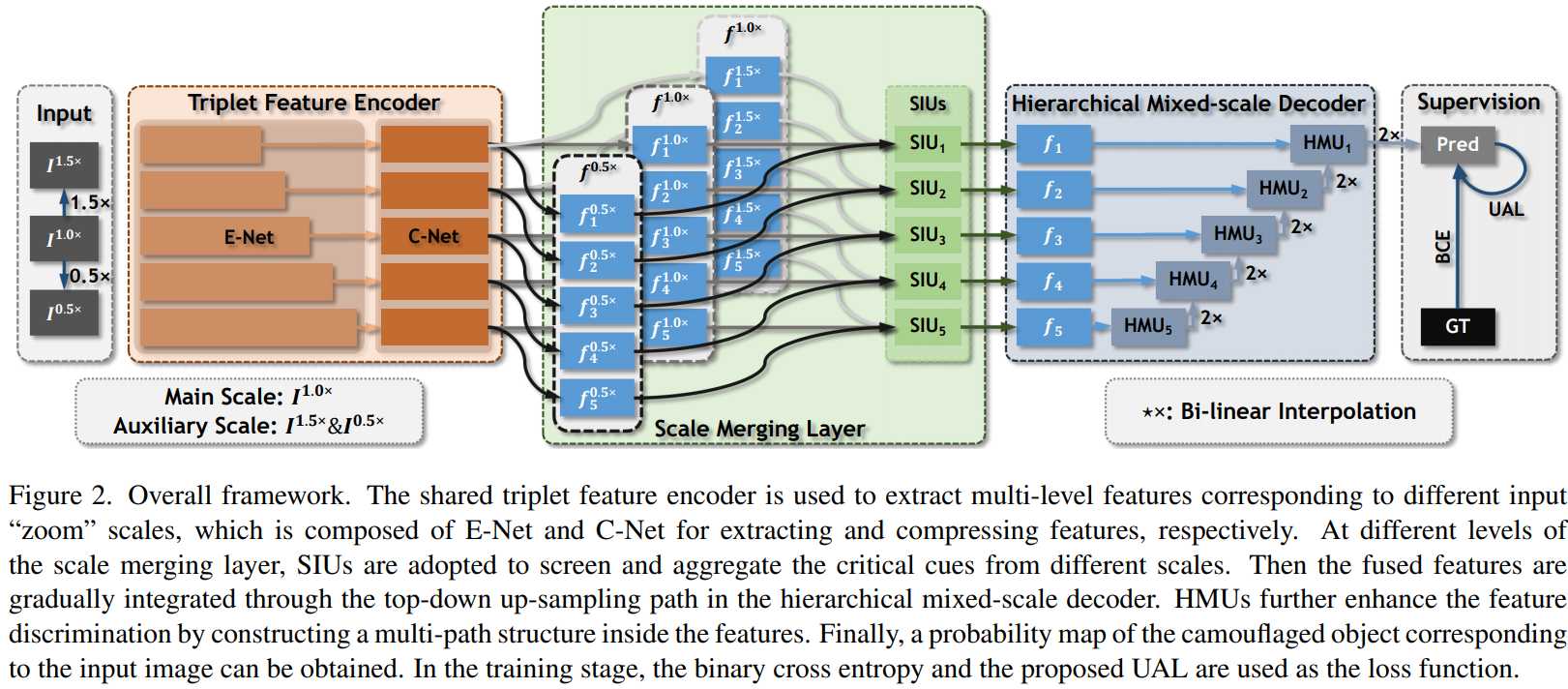

- [8] 【伪装目标检测】Zoom In and Out: A Mixed-scale Triplet Network for Camouflaged Object Detection(放大和缩小:用于伪装目标检测的混合尺度三元组网络)

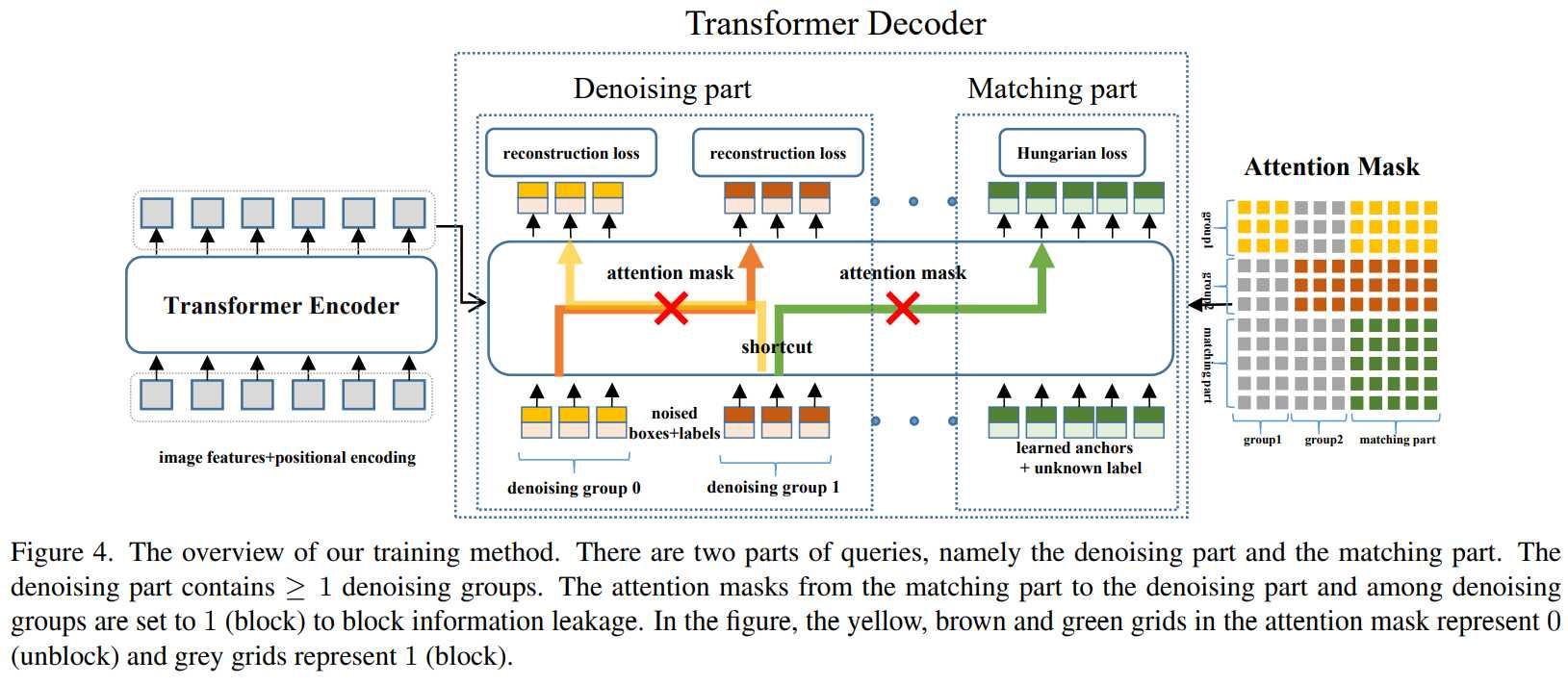

- [9] 【模型训练】DN-DETR: Accelerate DETR Training by Introducing Query DeNoising(DN-DETR:通过引入查询去噪加速DETR训练)

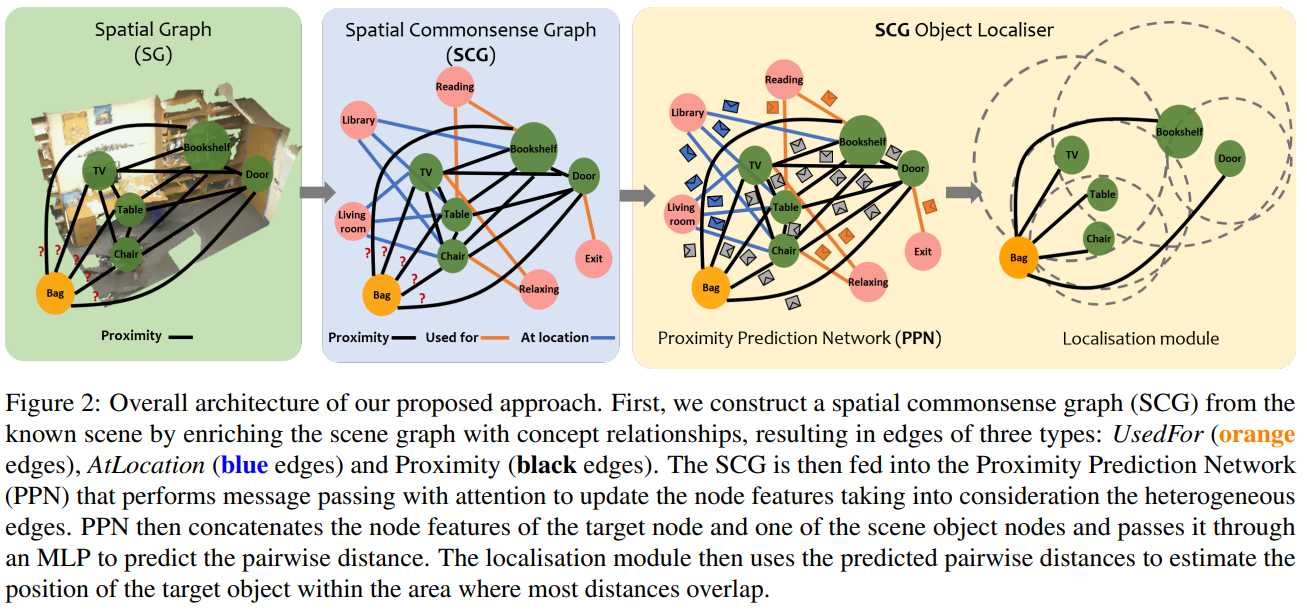

- [10]【视觉定位/位姿估计】Spatial Commonsense Graph for Object Localisation in Partial Scenes(局部场景中对象定位的空间常识图)

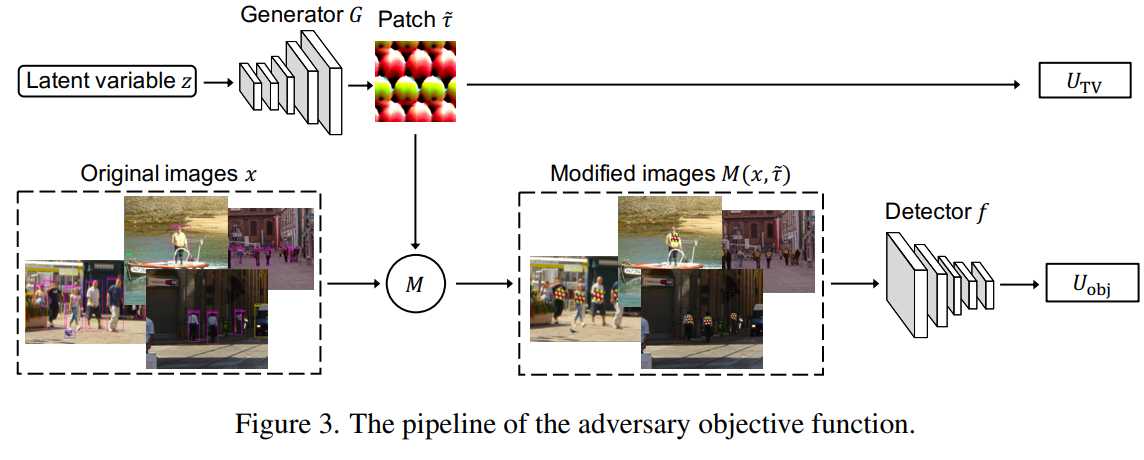

- [11]【遥感图像–GAN】Adversarial Texture for Fooling Person Detectors in the Physical World(物理世界中愚弄人探测器的对抗性纹理)

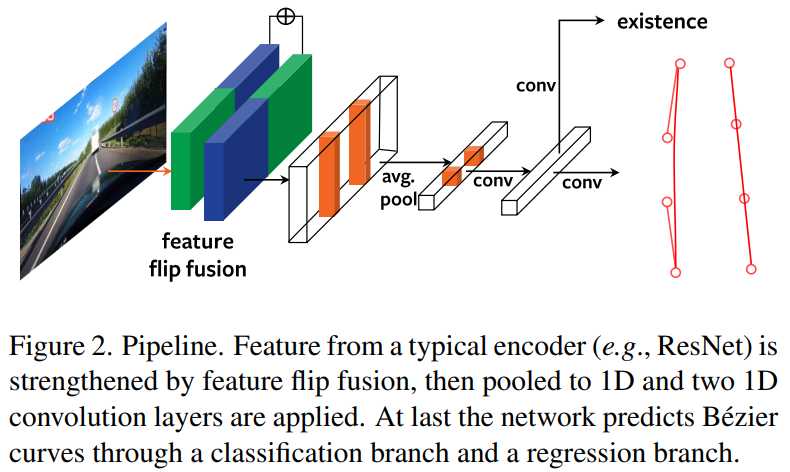

- [12]【车道线检测】Rethinking Efficient Lane Detection via Curve Modeling(通过曲线建模重新思考高效车道检测)

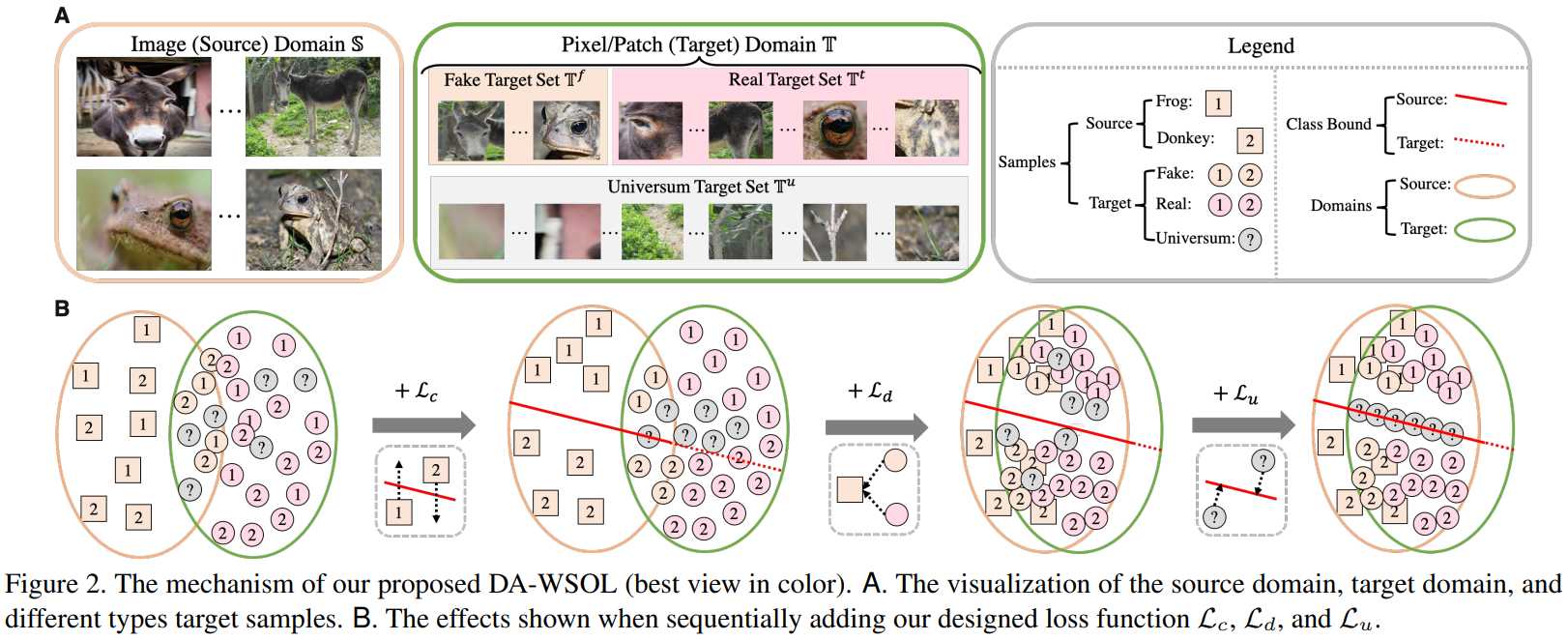

- [13]【迁移学习/domain/自适应】Weakly Supervised Object Localization as Domain Adaption(作为域适应的弱监督对象定位)

- [14]【消失点检测】Deep vanishing point detection: Geometric priors make dataset variations vanish(深度消失点检测:几何先验使数据集变化消失)

- [15]【神经网络可解释性】Interpretable part-whole hierarchies and conceptual-semantic relationships in neural networks(神经网络中可解释的部分-整体层次结构和概念语义关系)

一、2D目标检测

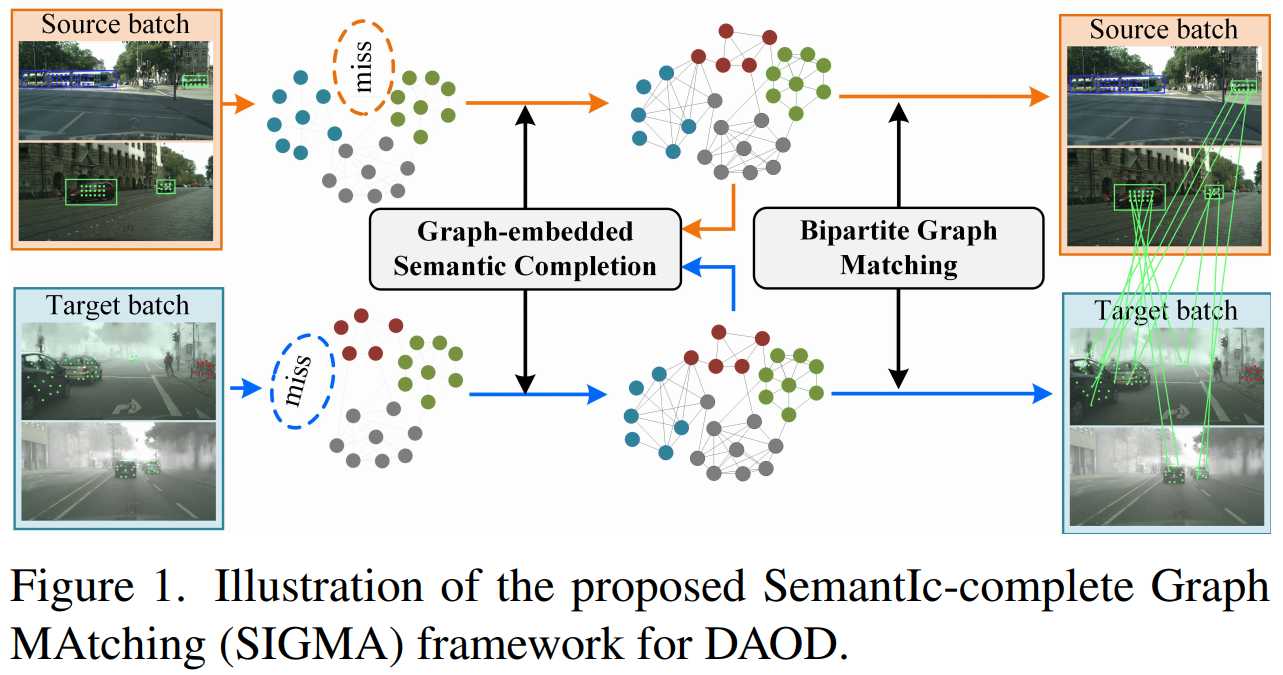

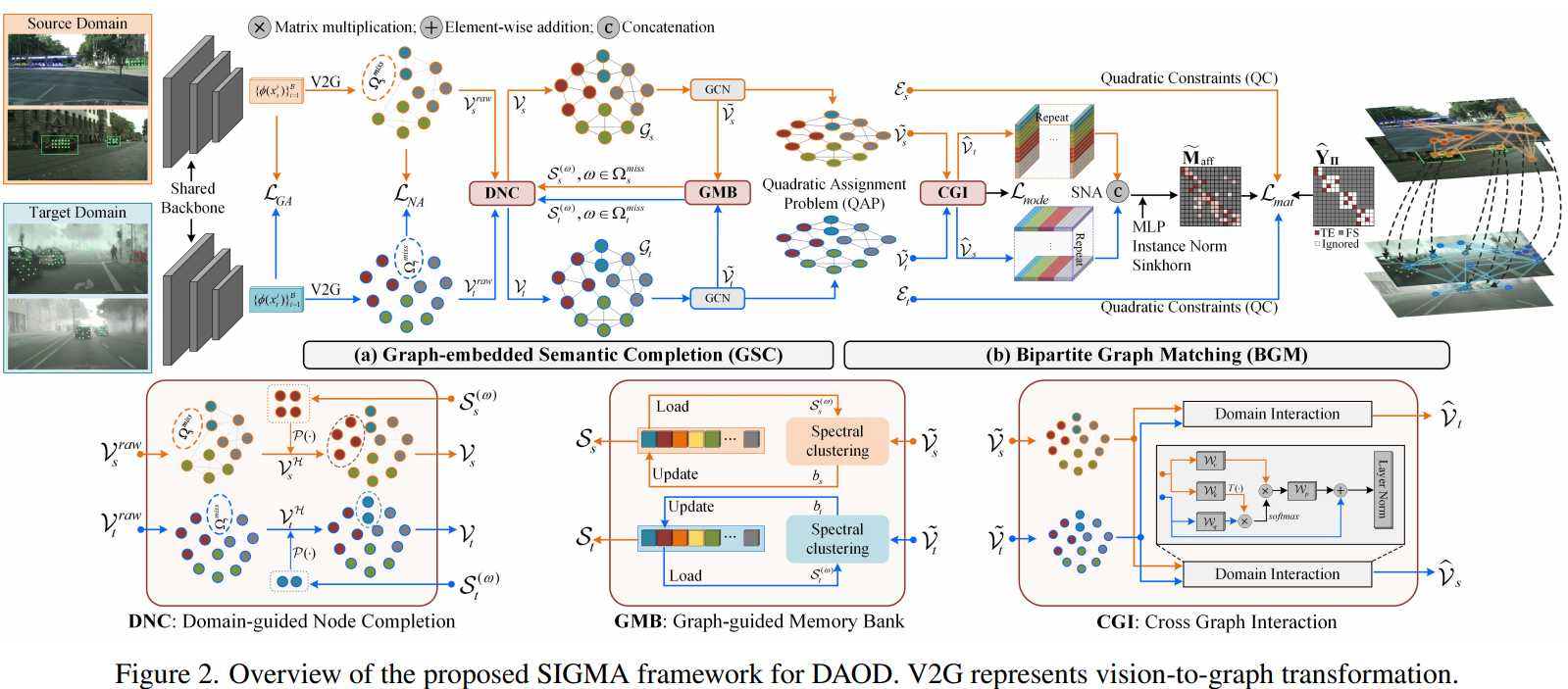

[1] SIGMA: Semantic-complete Graph Matching for Domain Adaptive Object Detection(SIGMA:域自适应目标检测的语义完全图匹配)

paper: https://arxiv.org/abs/2203.06398

code: https://github.com/CityU-AIM-Group/SIGMA

摘要:域自适应对象检测(DAOD)利用标记域学习对象检测器,将其推广到一个没有注释的新域。最近的进展通过缩小跨域原型(类中心)来调整类条件分布。尽管取得了巨大的成功,但他们忽略了显著的类内差异和训练批中的领域不匹配语义,导致了次优适应。为了克服这些挑战,我们提出了一种新的DAOD语义完全图匹配(SIGMA)框架,该框架完成了不匹配的语义,并用图匹配重新调整了适应性。具体来说,我们设计了一个嵌入图的语义完成模块(GSC),通过生成缺失类别中的幻觉图节点来完成不匹配的语义。然后,我们建立交叉图像图来模拟类的条件分布,并学习一个图引导的内存库,从而更好地完成语义。在将源数据和目标数据表示为图之后,我们将自适应问题转化为一个图匹配问题,即在图之间找到匹配良好的节点对以减少域间隙,这一问题通过一种新型的二部图匹配适配器(BGM)解决。简而言之,我们利用图节点建立语义感知的节点亲和力,并利用图边作为结构感知匹配损失中的二次约束,通过节点到节点的图匹配实现细粒度自适应。大量实验验证了SIGMA显著优于现有的工作。

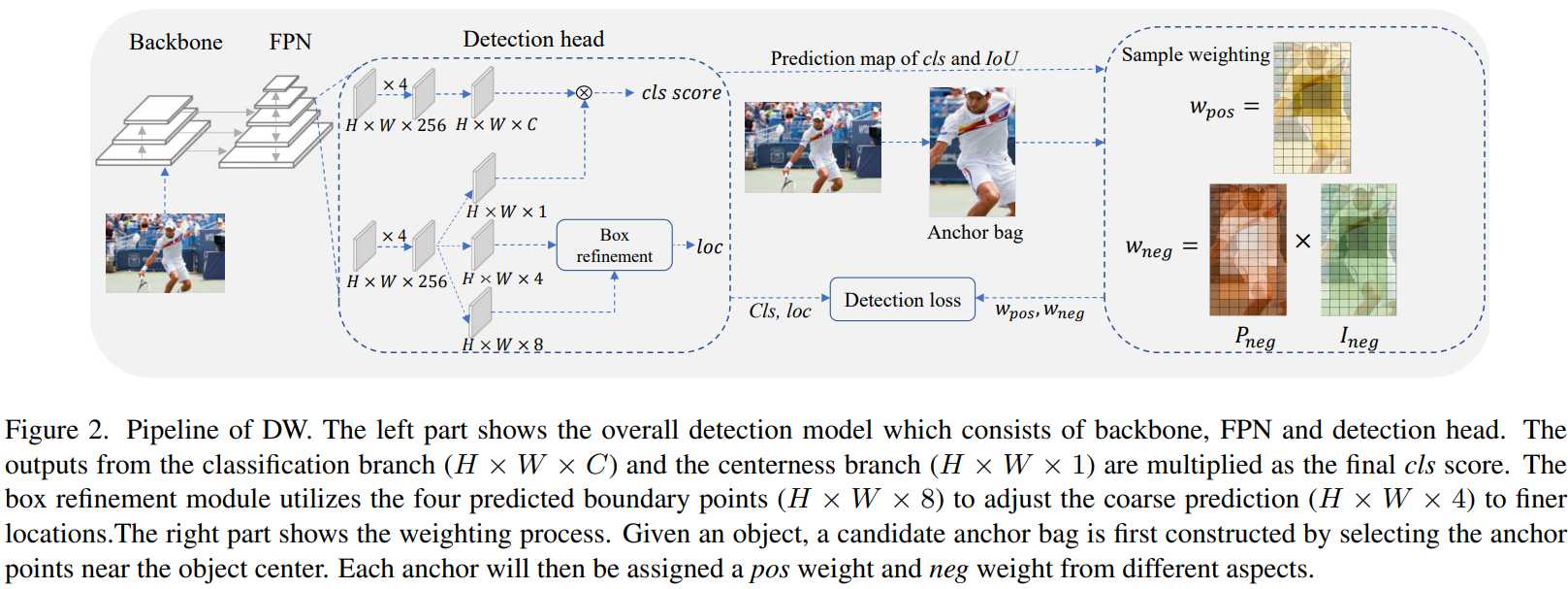

[2] A Dual Weighting Label Assignment Scheme for Object Detection(一种用于目标检测的双重加权标签分配方案)

paper:https://arxiv.org/abs/2203.09730

code:https://github.com/strongwolf/DW

摘要:标签分配(LA)旨在为每个训练样本分配一个正(pos)和一个负(neg)损失权重,在目标检测中起着重要作用。现有的 LA 方法大多侧重于 pos 权重函数的设计,而 neg weight 是直接从 pos 权重推导出来的。这种机制限制了检测器的学习能力。在本文中,我们探索了一种新的加权范式,称为双重加权(DW),以分别指定 pos 和 neg 权重。我们首先通过分析目标检测中的评估指标来确定 pos/neg 权重的关键影响因素,然后基于它们设计 pos 和 neg 权重函数。具体来说,一个样本的 pos 权重由其分类和定位分数的一致性程度决定,而 neg 权重则分解为两项:它是否定样本的概率及其重要性取决于是否为否定样本。这种加权策略提供了更大的灵活性来区分重要和不太重要的样本,从而产生更有效的目标检测器。配备所提出的 DW 方法,单个 FCOS-ResNet-50 检测器可以在 1x 调度下在 COCO 上达到 41.5% 的 mAP,优于其他现有的 LA 方法。它在各种没有花里胡哨的主干下,不断地大幅提高 COCO 的基线。代码可在 单个 FCOS-ResNet-50 检测器可以在 1x 进度下在 COCO 上达到 41.5% 的 mAP,优于其他现有的 LA 方法。它在各种没有花里胡哨的主干下,不断地大幅提高 COCO 的基线。代码可在 单个 FCOS-ResNet-50 检测器可以在 1x 进度下在 COCO 上达到 41.5% 的 mAP,优于其他现有的 LA 方法。它在各种没有花里胡哨的主干下,不断地大幅提高 COCO 的基线。

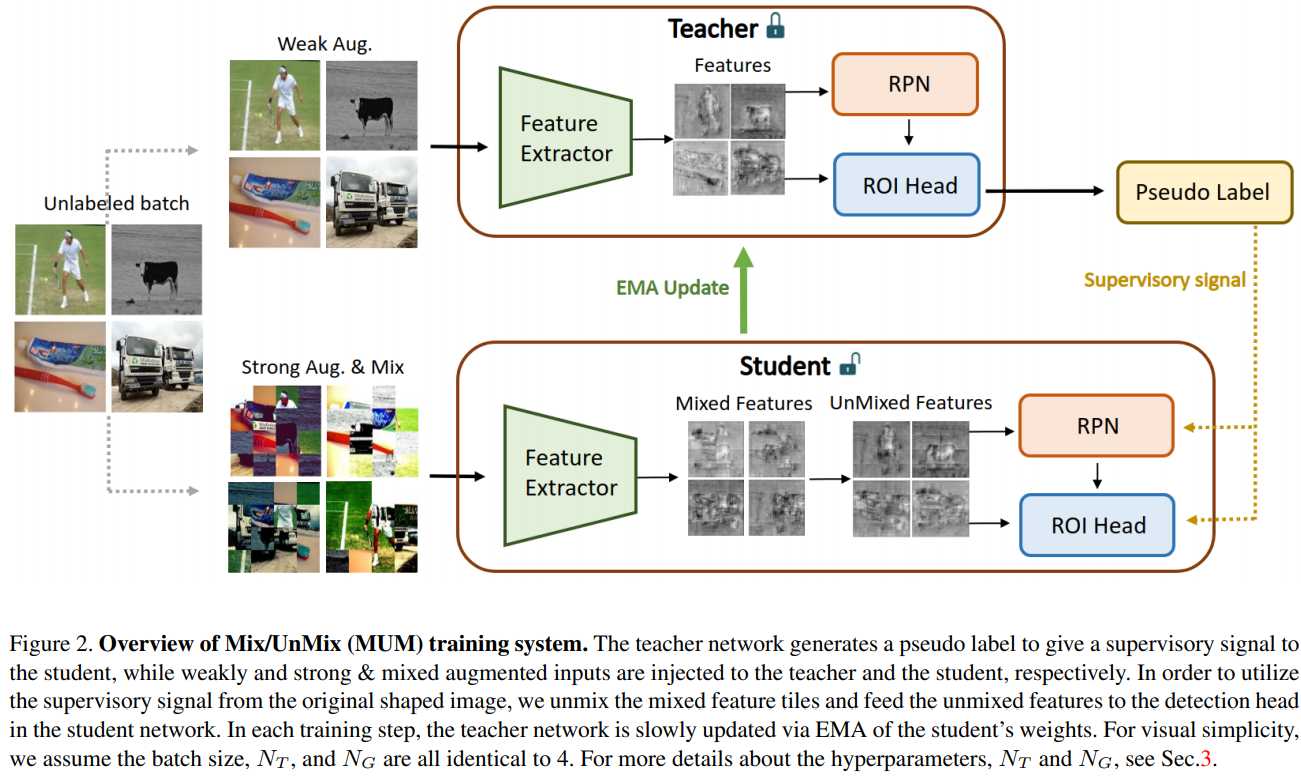

[3] MUM : Mix Image Tiles and UnMix Feature Tiles for Semi-Supervised Object Detection(MUM:混合图像块和 UnMix 特征块用于半监督目标检测)

paper:https://arxiv.org/abs/2111.10958

code:https://github.com/JongMokKim/mix-unmix

摘要:许多最近的半监督学习(SSL)研究建立了师生架构,并通过教师生成的监督信号来训练学生网络。数据增强策略在 SSL 框架中起着重要作用,因为很难在不丢失标签信息的情况下创建弱强增强输入对。特别是在将 SSL 扩展到半监督目标检测 (SSOD) 时,许多与图像几何和插值正则化相关的强增强方法很难使用,因为它们可能会损害目标检测任务中边界框的位置信息。为了解决这个问题,我们引入了一种简单而有效的数据增强方法 Mix/UnMix (MUM),它为 SSOD 框架的混合图像块解混合特征块。我们提出的方法制作混合输入图像块并在特征空间中重建它们。因此,MUM 可以享受非插值伪标签的插值正则化效果,并成功生成有意义的弱-强对。此外,MUM 可以轻松地安装在各种 SSOD 方法之上。在 MS-COCO 和 PASCAL VOC 数据集上进行的大量实验证明了 MUM 的优越性,通过在所有测试的 SSOD 基准协议中不断提高 mAP 性能超过基线。

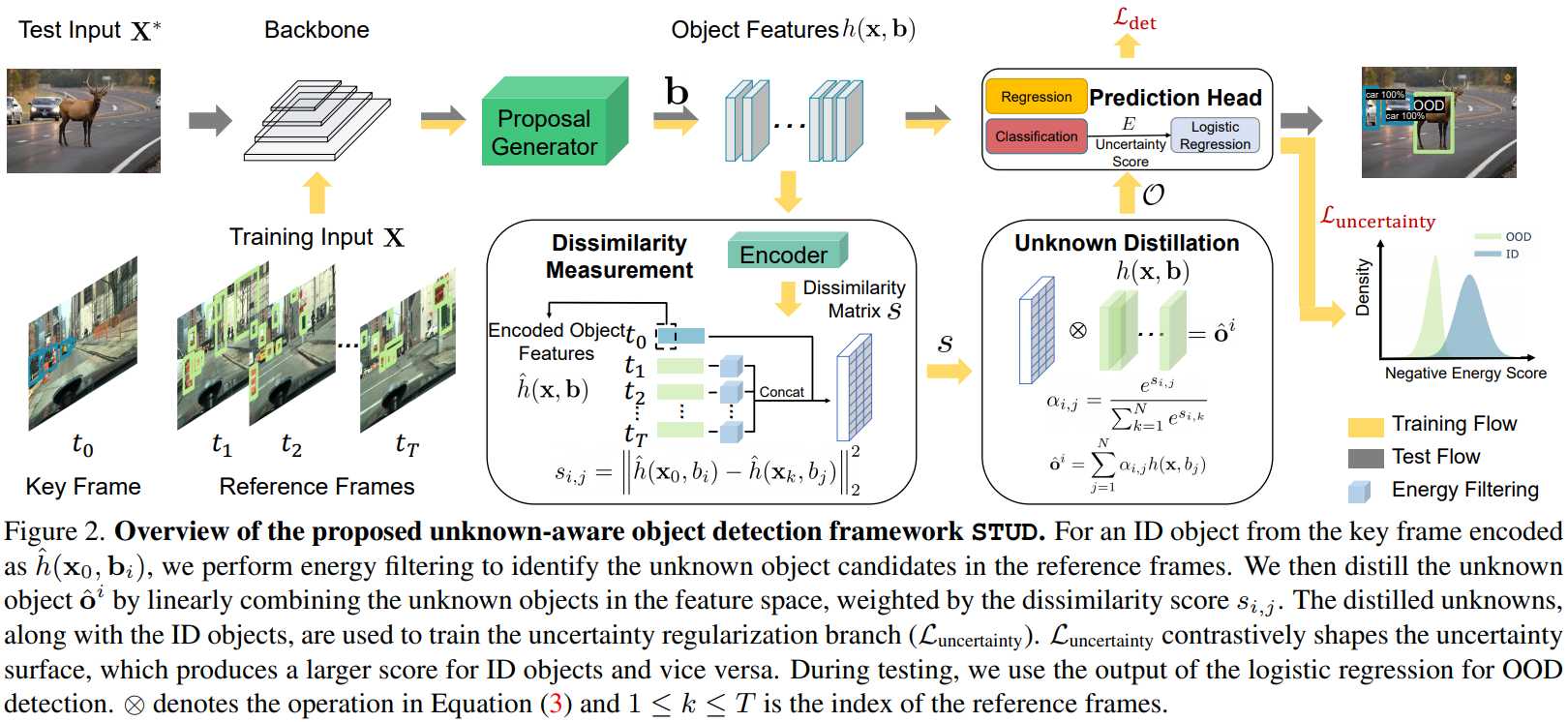

[4] Unknown-Aware Object Detection: Learning What You Don’t Know from Videos in the Wild(未知感知对象检测:从野外视频中学习你不知道的东西)

paper: https://arxiv.org/abs/2203.03800

code: https://github.com/deeplearning-wisc/stud

摘要:构建可以检测分布外 (OOD) 对象的可靠对象检测器至关重要,但尚未得到充分探索。关键挑战之一是模型缺乏来自未知数据的监督信号,从而对 OOD 对象产生过度自信的预测。我们通过时空未知蒸馏 (STUD) 提出了一种新的未知感知对象检测框架,该框架从野外视频中提取未知对象并有意义地规范模型的决策边界。STUD首先在空间维度上识别未知候选对象proposals,然后跨多个视频帧聚合候选对象,在决策边界附近形成一组多样化的未知对象。此外,我们采用基于能量的不确定性正则化损失,它对比地塑造了分布中和蒸馏的未知对象之间的不确定性空间。STUD 在用于对象检测的 OOD 检测任务上建立了最先进的性能,与之前的最佳方法相比,将 FPR95 分数降低了 10% 以上。

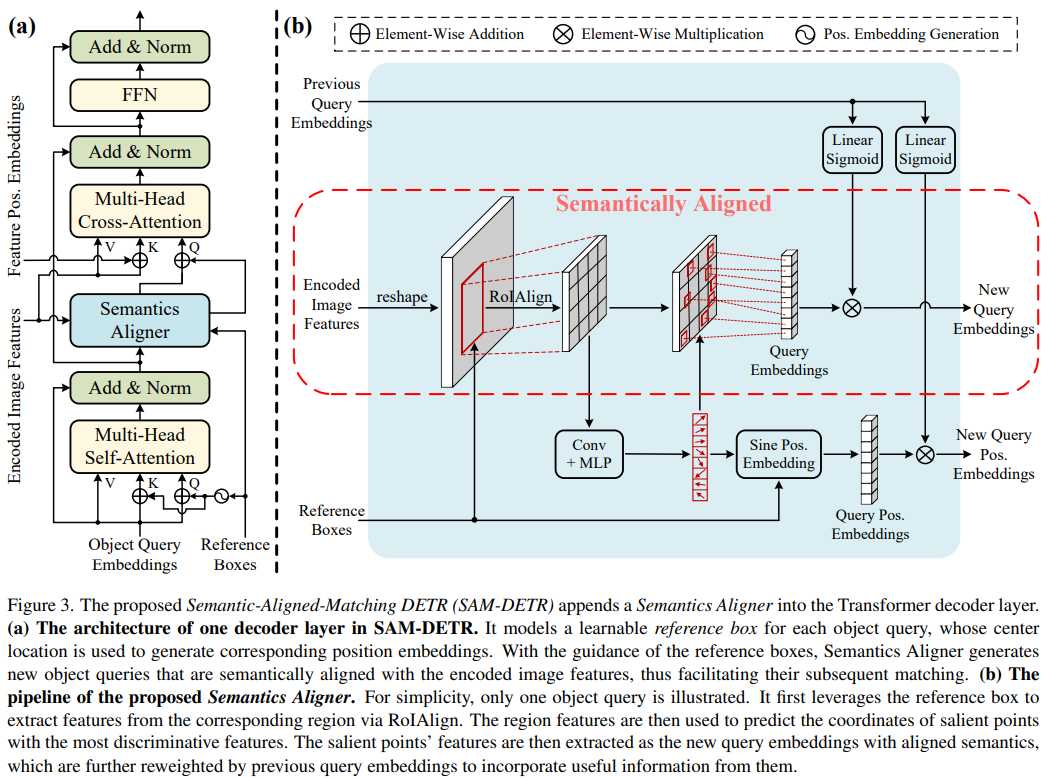

[5] Accelerating DETR Convergence via Semantic-Aligned Matching(通过语义对齐匹配加速DETR收敛)

paper: https://arxiv.org/abs/2203.06883

code: https://github.com/ZhangGongjie/SAM-DETR GitHub – ZhangGongjie/SAM-DETR: Official PyTorch Implementation of SAM-DETR (CVPR 2022)

摘要:最近开发的DEtection TRansformer(DETR)通过消除一系列手工制作的组件,建立了一种新的对象检测范式。然而,DETR的收敛速度非常慢,这大大增加了训练成本。我们观察到,在不同的特征嵌入空间中,对象查询与目标特征匹配的复杂性很大程度上是导致收敛缓慢的原因。本文介绍了SAM-DETR,这是一种语义对齐的匹配DETR,它在不牺牲精度的情况下大大加快了DETR的收敛速度。SAM-DETR从两个角度解决了趋同问题。首先,它将对象查询投影到与编码图像特征相同的嵌入空间中,通过对齐语义可以有效地完成匹配。其次,它显式地搜索具有最具辨别力特征的显著点进行语义对齐匹配,这进一步加快了收敛速度并提高了检测精度。SAM-DETR就像一个即插即用的解决方案,很好地补充了现有的收敛解决方案,但只引入了少量的计算开销。大量实验表明,所提出的SAM-DETR算法不仅具有很好的收敛性,而且具有很高的检测精度。

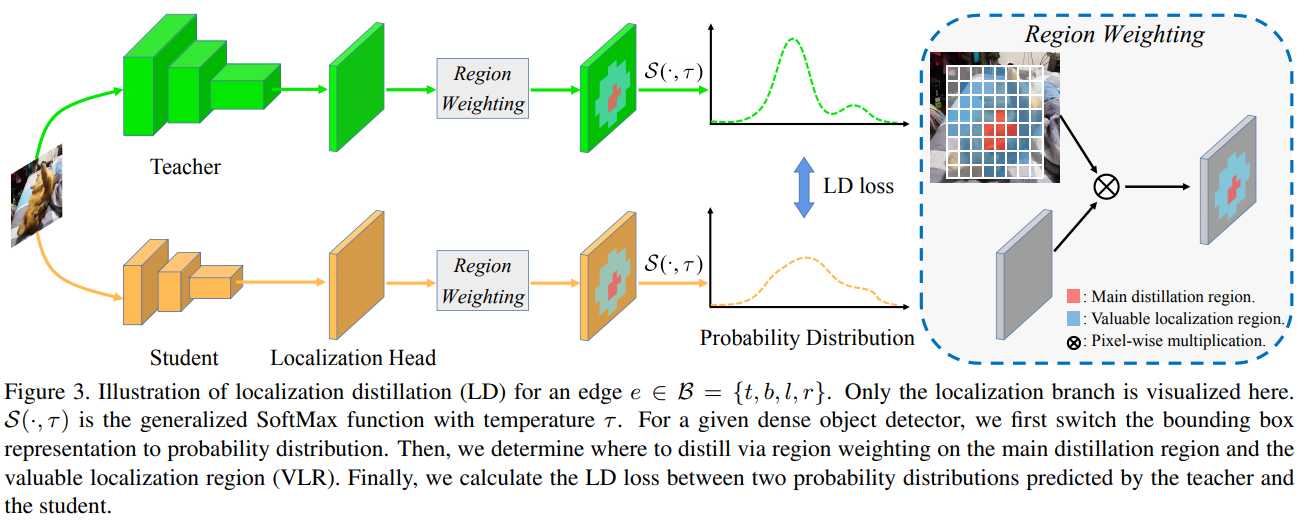

[6] Localization Distillation for Dense Object Detection(密集对象检测的定位蒸馏)

paper: https://arxiv.org/abs/2102.12252

code: https://github.com/HikariTJU/LD GitHub – HikariTJU/LD: Localization Distillation for Dense Object Detection (CVPR 2022)

解读:南开程明明团队和天大提出LD:目标检测的定位蒸馏

摘要:知识提取(KD)在目标检测中具有强大的学习紧凑模型的能力。以往的KD目标检测方法由于提取定位信息的效率较低,大多侧重于模仿模仿区域内的深层特征,而不是模仿分类逻辑。本文通过对本地化知识提取过程的重新描述,提出了一种新的本地化提取(LD)方法,可以有效地将本地化知识从教师传递给学生。此外,我们还启发性地引入了有价值定位区域的概念,有助于有选择地提取特定区域的语义和定位知识。将这两个新组件结合起来,我们首次证明了logit模拟优于特征模拟,并且在提取目标检测器时,定位知识提取比语义知识更重要、更有效。我们的蒸馏方案简单有效,可以很容易地应用于不同的稠密物体探测器。实验表明,在COCO基准上,我们的LD可以在不牺牲推理速度的情况下,通过单量表1×训练计划将GFocal-ResNet-50的AP分数从40.1提高到42.1。

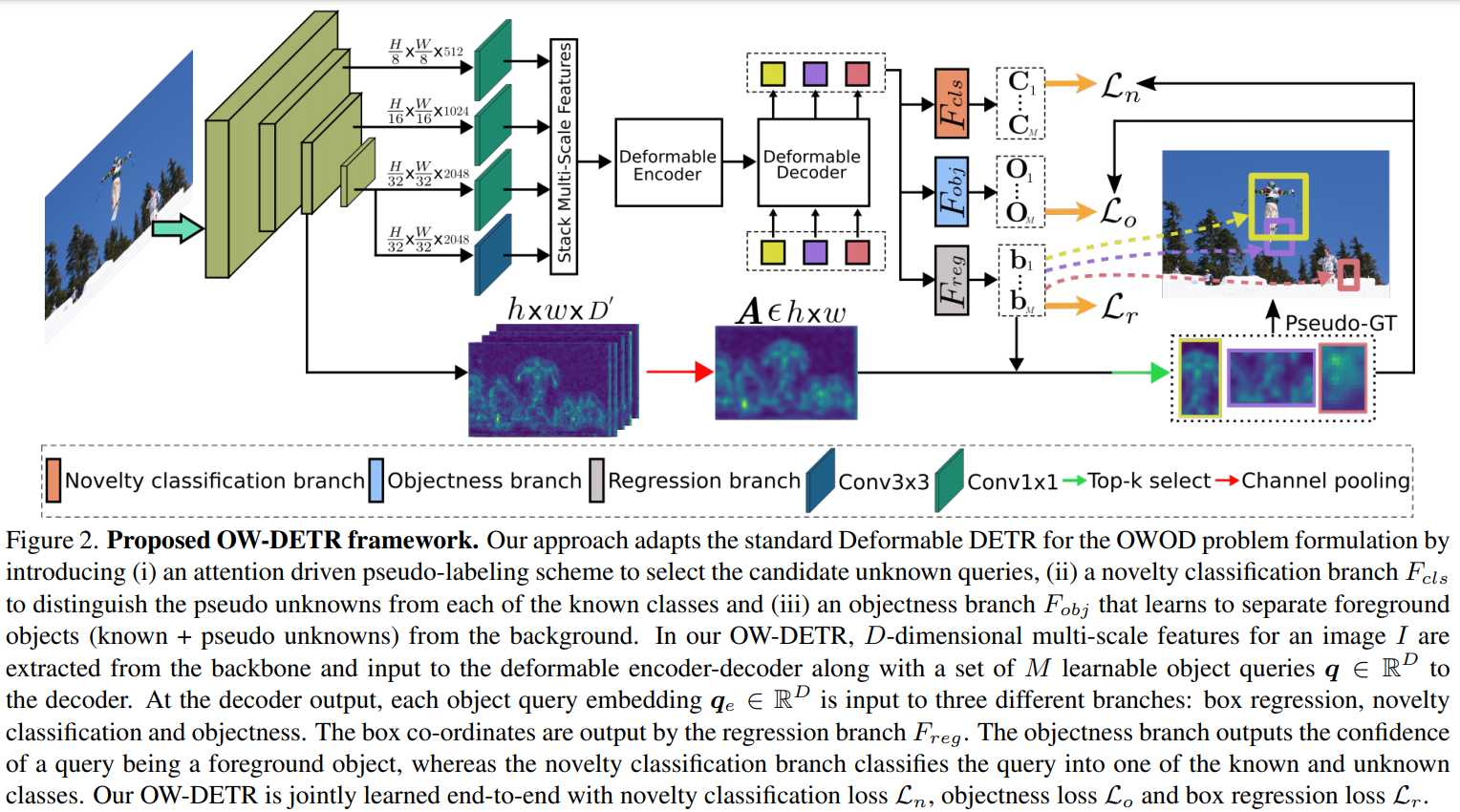

[7] OW-DETR: Open-world Detection Transformer(开放世界检测transformer)

paper:https://arxiv.org/abs/2112.01513

code:https://github.com/akshitac8/OW-DETR

摘要:开放世界对象检测 (OWOD) 是一个具有挑战性的计算机视觉问题,其任务是检测一组已知的对象类别,同时识别未知对象。此外,该模型必须逐步学习在下一个训练集中成为已知的新类。与标准对象检测不同,OWOD 设置对生成潜在未知对象的质量候选建议、将未知对象与背景分离以及检测各种未知对象提出了重大挑战。在这里,我们介绍了一种新颖的基于端到端转换器的框架 OW-DETR,用于开放世界对象检测。提出的 OW-DETR 包括三个专用组件,即注意力驱动的伪标签,新颖性分类和客观性评分,以明确解决上述 OWOD 挑战。我们的 OW-DETR 显式编码多尺度上下文信息,具有较少的归纳偏差,能够将知识从已知类转移到未知类,并且可以更好地区分未知对象和背景。在两个基准上进行了综合实验:MS-COCO 和 PASCAL VOC。广泛的消融揭示了我们提出的贡献的优点。此外,我们的模型优于最近引入的 OWOD 方法 ORE,就 MS-COCO 的未知召回而言,绝对收益从 1.8% 到 3.3% 不等。在增量目标检测的情况下,OW-DETR 在 PASCAL VOC 上的所有设置都优于最先进的方法。

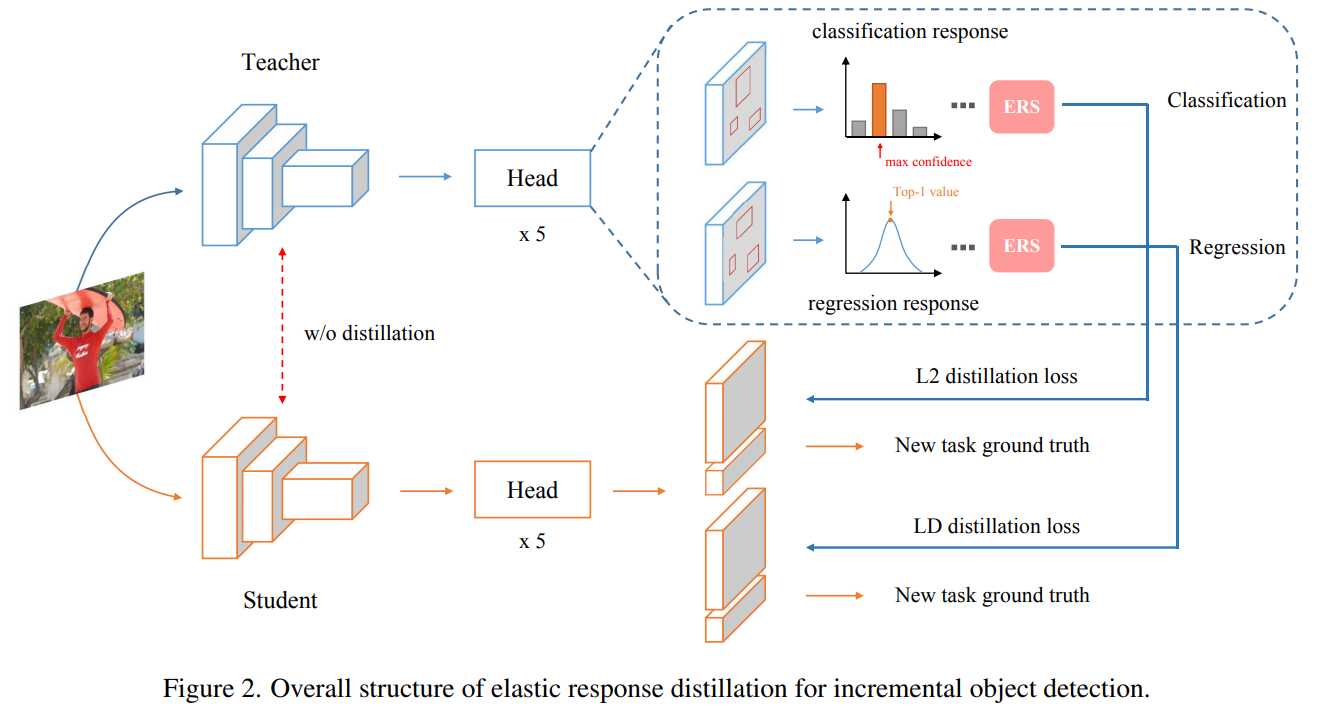

[8] Overcoming Catastrophic Forgetting in Incremental Object Detection via Elastic Response Distillation(通过弹性响应蒸馏克服增量目标检测中的灾难性遗忘)

paper:https://arxiv.org/abs/2204.02136

code:https://github.com/Hi-FT/ERD

摘要:传统的目标检测器不适合增量学习。然而,直接在训练有素的检测模型上仅使用新数据进行微调将导致灾难性的遗忘。知识蒸馏是减轻灾难性遗忘的一种灵活方法。在增量目标检测(IOD)中,之前的工作主要集中在提取特征和响应的组合。但是,他们对响应中包含的信息的探索不足。在本文中,我们提出了一种基于响应的增量蒸馏方法,称为弹性响应蒸馏 (ERD),它侧重于弹性学习来自分类头和回归头的响应。首先,我们的方法转移了类别知识,同时使学生检测器具有在增量学习期间保留定位信息的能力。此外,我们进一步评估所有位置的质量,并通过弹性响应选择 (ERS) 策略提供有价值的响应。最后,我们阐明了在增量蒸馏过程中,来自不同响应的知识应该被赋予不同的重要性。在 MS COCO 上进行的大量实验表明,我们的方法实现了最先进的结果,这大大缩小了全面训练的性能差距。

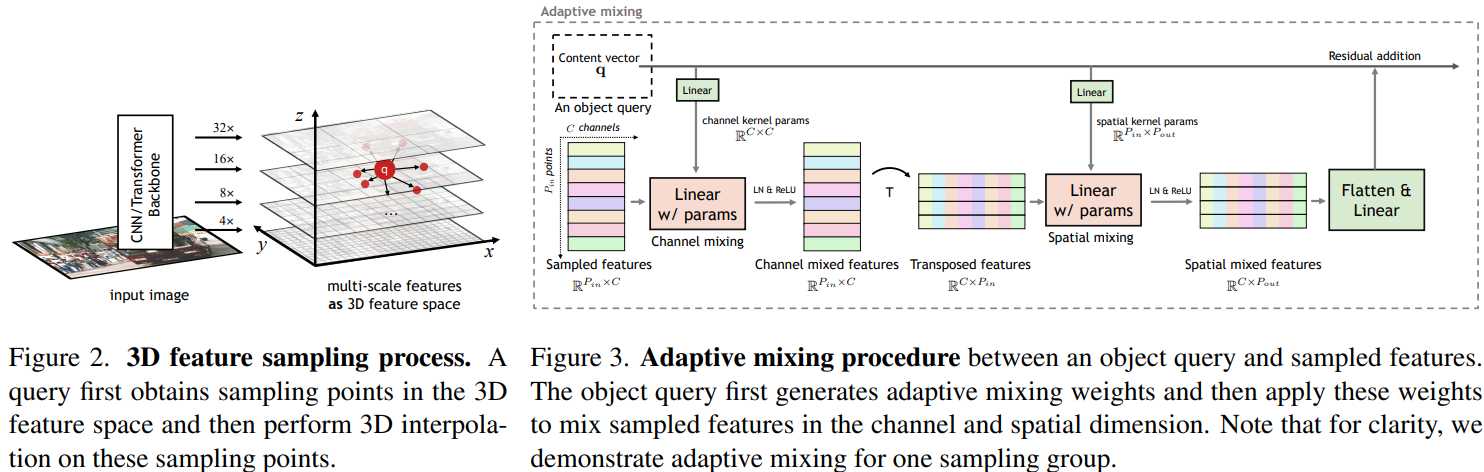

[9] AdaMixer: A Fast-Converging Query-Based Object Detector(一种快速收敛的基于查询的对象检测器)(Oral)

paper:https://arxiv.org/abs/2203.16507

code:https://github.com/MCG-NJU/AdaMixer

摘要:传统的物体检测器采用密集模式扫描图像中的位置和尺度。最近基于查询的对象检测器通过使用一组可学习的查询解码图像特征来打破这一惯例。然而,这种范式仍然存在收敛速度慢、性能有限以及骨干网和解码器之间额外网络的设计复杂性的问题。在本文中,我们发现解决这些问题的关键是解码器对将查询投射到不同对象的适应性。因此,我们提出了一种快速收敛的基于查询的检测器,名为 AdaMixer,通过在两个方面提高基于查询的解码过程的适应性。首先,每个查询根据估计的偏移量自适应地对空间和尺度的特征进行采样,这使得 AdaMixer 能够有效地处理对象的相干区域。然后,我们在每个查询的指导下使用自适应 MLP-Mixer 动态解码这些采样特征。由于这两个关键设计,AdaMixer 享有架构的简单性,而不需要密集的注意力编码器或显式金字塔网络。在具有挑战性的 MS COCO 基准测试中,以 ResNet-50 为骨干的 AdaMixer 具有 12 个训练 epoch,在验证集上达到了 45.0 AP,在检测小物体时达到了 27.9 AP。随着更长的训练方案,带有 ResNeXt-101-DCN 和 Swin-S 的 AdaMixer 达到 49.5 和 51.3 AP。我们的工作为基于查询的对象检测器提供了一种简单、准确和快速的收敛架构。

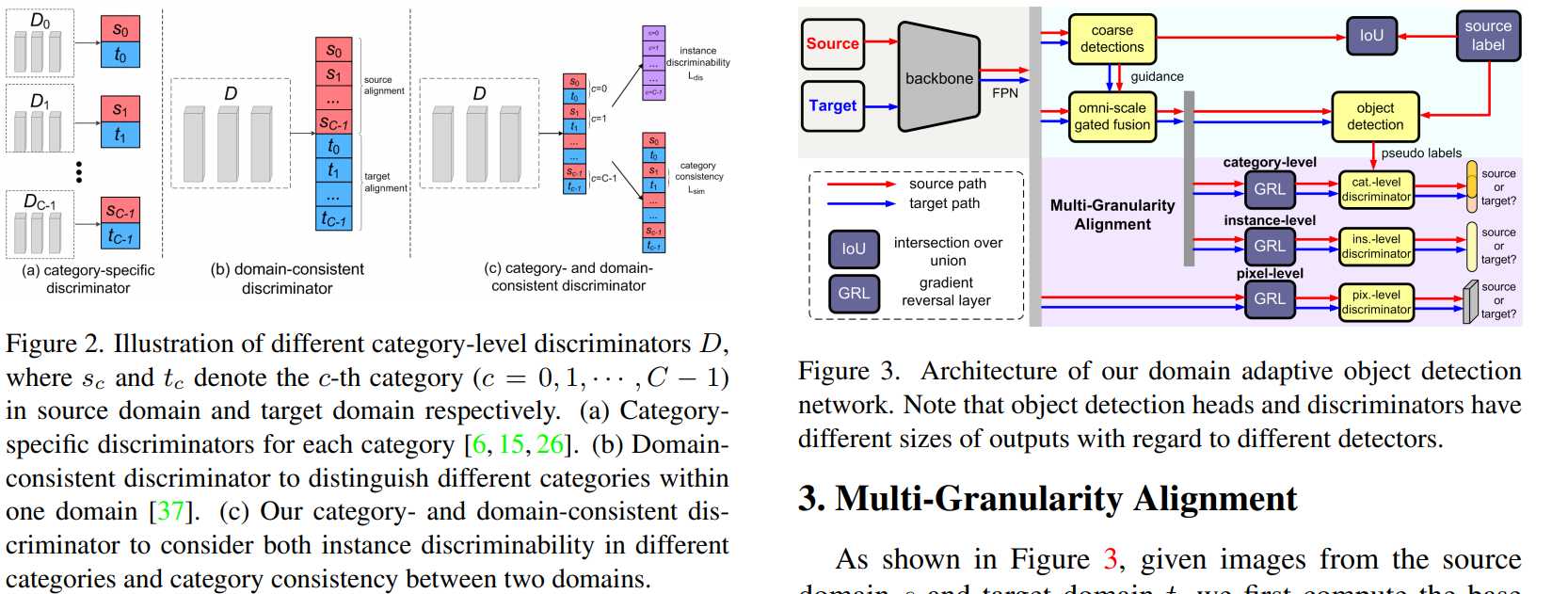

[10] Multi-Granularity Alignment Domain Adaptation for Object Detection(用于目标检测的多粒度对齐域自适应)

paper:https://arxiv.org/abs/2203.16897

code:https://github.com/tiankongzhang/MGADA

摘要:由于源域和目标域之间的独特数据分布,域自适应对象检测具有挑战性。在本文中,我们提出了一种基于统一多粒度对齐的对象检测框架,用于域不变特征学习。为此,我们同时编码跨不同粒度视角的依赖关系,包括像素、实例和类别级别,以对齐两个域。基于来自主干网络的像素级特征图,我们首先开发了全尺度门控融合模块,通过尺度感知卷积聚合实例的判别表示,从而实现鲁棒的多尺度目标检测。同时,提出了多粒度鉴别器来识别不同粒度的样本(即像素、实例和类别)来自哪个域。值得注意的是,我们不仅利用了不同类别中的实例可辨别性,还利用了两个域之间的类别一致性。在多个域适应场景上进行了广泛的实验,证明了我们的框架在无锚 FCOS 和具有不同主干的基于锚的 Faster RCNN 检测器之上的最先进算法的有效性。

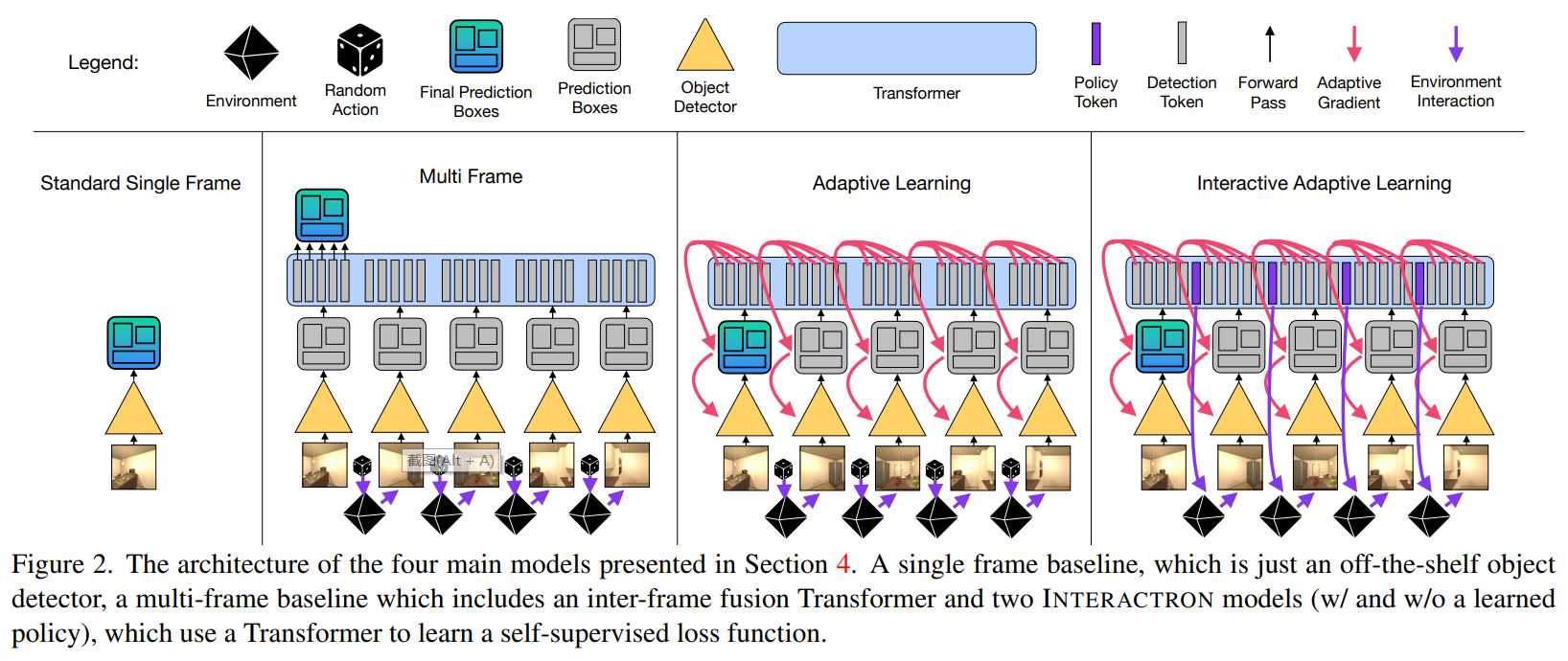

[11] Interactron: Embodied Adaptive Object Detection(体现自适应目标检测)

paper:https://arxiv.org/abs/2202.00660

code:https://github.com/allenai/interactron

摘要:多年来,针对目标检测问题提出了各种方法。最近,由于强大的深度神经网络的出现,我们见证了这一领域的巨大进步。然而,这些方法之间通常有两个共同的主要假设。首先,模型在固定的训练集上进行训练,并在预先记录的测试集上进行评估。其次,模型在训练阶段后保持冻结状态,因此在训练完成后不再执行进一步的更新。这两个假设限制了这些方法对现实世界的适用性。在本文中,我们提出了 Interactron,一种在交互式环境中进行自适应对象检测的方法,其目标是在不同环境中导航的具体代理观察到的图像中执行对象检测。我们的想法是在推理期间继续训练,并在测试时通过与环境交互来调整模型,而无需任何明确的监督。我们的自适应对象检测模型在 AP 方面提供了 11.8 点的改进(在 AP50 中提高了 19.1 点),而 DETR 是一种最近的高性能对象检测器。此外,我们证明了我们的目标检测模型能够适应具有完全不同外观特征的环境,并且其性能与在这些环境中接受全面监督训练的模型相当。该代码可在以下位置获得:我们表明,我们的目标检测模型能够适应具有完全不同外观特征的环境,并且其性能与在这些环境中受过全面监督训练的模型相当。该代码可在以下位置获得:我们表明,我们的目标检测模型能够适应具有完全不同外观特征的环境,并且其性能与在这些环境中受过全面监督训练的模型相当。

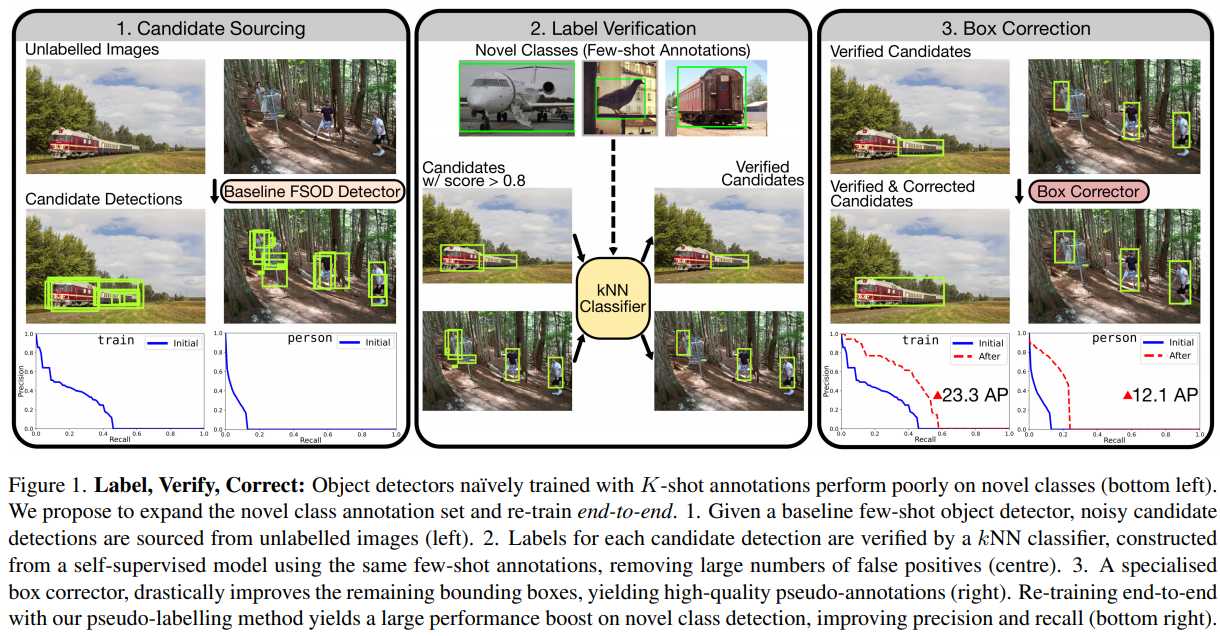

[12] Label, Verify, Correct: A Simple Few Shot Object Detection Method(标签、验证、正确:一种简单的小样本物体检测方法)

paper:https://arxiv.org/abs/2112.05749

project:https://www.robots.ox.ac.uk/~vgg/research/lvc/

摘要:本文的目标是少样本目标检测(FSOD)——仅在给定几个训练实例的情况下为新类别扩展目标检测器的任务。我们引入了一种简单的伪标记方法,从训练集中为每个新类别获取高质量的伪注释,大大增加了训练实例的数量并减少了类不平衡;我们的方法会找到以前未标记的实例。使用模型预测进行天真的训练会产生次优性能;我们提出了两种新方法来提高伪标记过程的精度:首先,我们引入了一种验证技术来删除具有不正确类标签的候选检测;其次,我们训练了一个专门的模型来纠正质量差的边界框。经过这两个新颖的步骤,我们获得了大量高质量的伪注释,使我们的最终检测器能够进行端到端的训练。此外,我们展示了我们的方法保持了基类性能,以及 FSOD 中简单增强的实用性。在对 PASCAL VOC 和 MS-COCO 进行基准测试时,与所有镜头数量的现有方法相比,我们的方法实现了最先进或次优的性能。

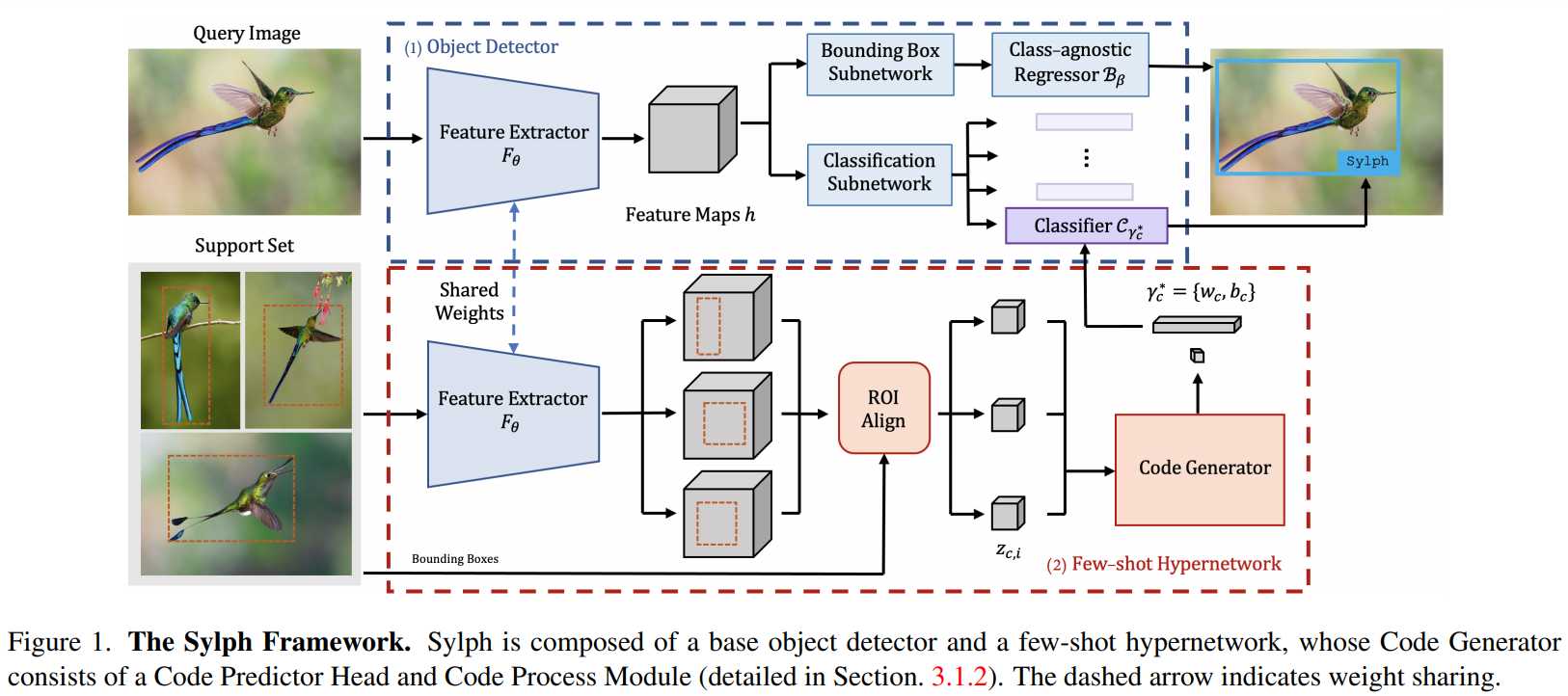

[13] Sylph: A Hypernetwork Framework for Incremental Few-shot Object Detection(用于增量少样本目标检测的超网络框架)

paper:https://arxiv.org/abs/2203.13903

摘要:我们研究了具有挑战性的增量少镜头目标检测 (iFSD) 设置。最近,已经在连续和无微调 iFSD 的背景下研究了基于超网络的方法,但成功有限。我们仔细研究了这些方法的重要设计选择,带来了几项关键改进,并产生了一个更准确、更灵活的框架,我们称之为 Sylph。特别是,我们通过利用一个为大规模数据集上的类不可知定位进行预训练的基本检测器,证明了将对象分类与定位解耦的有效性。与之前的结果相反,我们表明,通过精心设计的类条件超网络,无需微调的 iFSD 可以非常有效,特别是当大量具有丰富数据的基本类别可用于元训练时,几乎接近经过测试时间训练的替代方案。考虑到它的许多实际优势,这个结果更加显着:(1)在没有额外训练的情况下按顺序递增地学习新类,(2)一次检测新类和见过的类,以及(3)不会忘记以前见过的类。我们在 COCO 和 LVIS 上对我们的模型进行基准测试,报告高达17 %AP 关于 LVIS 上的长尾稀有类,表明基于超网络的 iFSD 的前景。

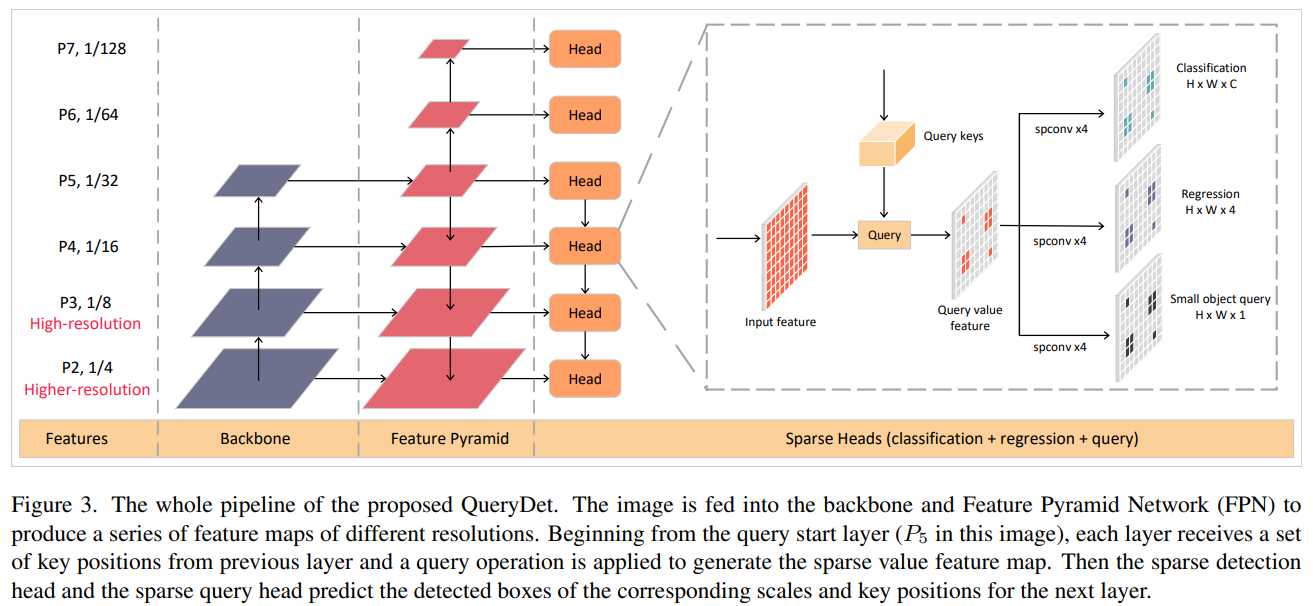

[14] QueryDet: Cascaded Sparse Query for Accelerating High-Resolution Small Object Detection(QueryDet:用于加速高分辨率小目标检测的级联稀疏查询)

paper:https://arxiv.org/abs/2103.09136

code:https://github.com/ChenhongyiYang/QueryDet-PyTorch

摘要:虽然深度学习的通用目标检测在过去几年中取得了巨大成功,但检测小目标的性能和效率却远不能令人满意。促进小物体检测的最常见和最有效的方法是使用高分辨率图像或特征图。然而,这两种方法都会导致计算成本高昂,因为计算成本会随着图像和特征大小的增加而成正比增长。为了两全其美,我们提出了 QueryDet,它使用一种新颖的查询机制来加速基于特征金字塔的对象检测器的推理速度。该管道由两个步骤组成:首先在低分辨率特征上预测小物体的粗略位置,然后使用由这些粗略位置稀疏引导的高分辨率特征计算准确的检测结果。这样,我们不仅可以收获高分辨率特征图的好处,还可以避免对背景区域进行无用计算。在流行的COCO数据集上,该方法将检测mAP提高了1.0,mAP-small提高了2.0,高分辨率推理速度平均提高到3.0倍。在包含更多小对象的 VisDrone 数据集上,我们创建了一个新的最先进技术,同时平均获得 2.3 倍的高分辨率加速。

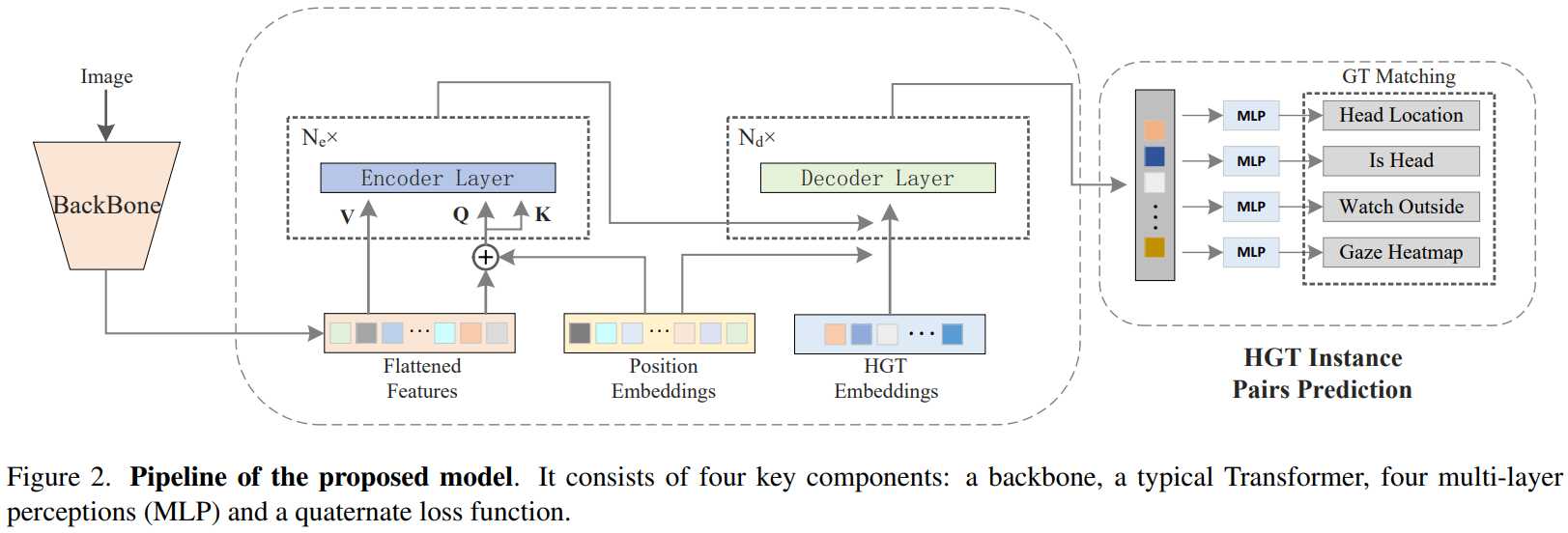

[15] End-to-End Human-Gaze-Target Detection with Transformers(使用 Transformer 进行端到端的人眼目标检测)

paper:https://arxiv.org/abs/2203.10433

摘要:在本文中,我们提出了一种有效且高效的 Human-Gaze-Target (HGT) 检测方法,即注视跟踪。当前的方法将 HGT 检测任务分离为显着对象检测和人类注视预测的单独分支,采用两阶段框架,其中必须首先检测人体头部位置,然后将其馈送到下一个注视目标预测子网络。相比之下,我们将 HGT 检测任务重新定义为同时检测人头位置及其注视目标。通过这种方式,我们的方法名为 Human-Gaze-Target detection TRansformer 或 HGTTR,通过消除所有其他附加组件来简化 HGT 检测管道。HGTTR 从全局图像上下文中推断显着对象与人类注视的关系。而且,与现有的需要人头位置作为输入且一次只能预测一个人的注视目标的两阶段方法不同,HGTTR 可以以端到端的方式一次直接预测所有人及其注视目标的位置。我们提出的方法的有效性和鲁棒性通过在两个标准基准数据集 GazeFollowing 和 VideoAttentionTarget 上的广泛实验得到验证。没有花里胡哨的东西,HGTTR 以更简单的架构大大优于现有的最先进方法(GazeFollowing 获得 6.4 mAP 增益,VideoAttentionTarget 获得 10.3 mAP 增益)。

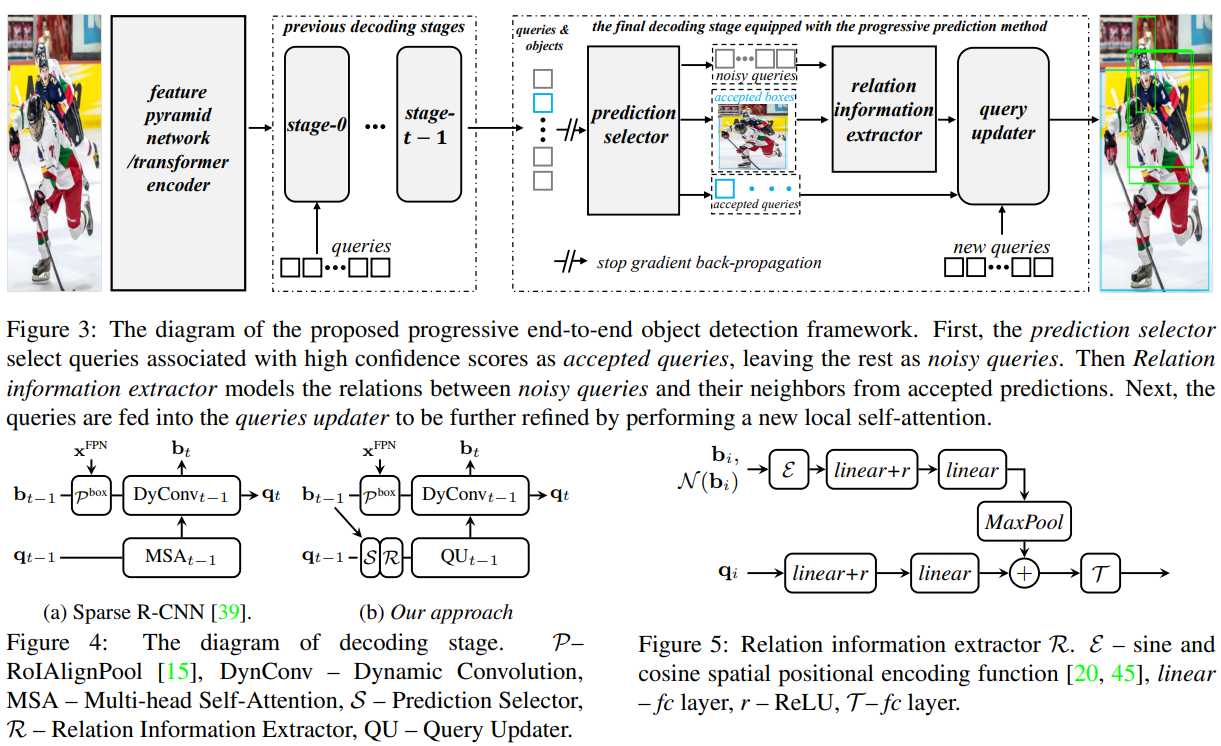

[16] Progressive End-to-End Object Detection in Crowded Scenes(拥挤场景中的渐进式端到端对象检测)

paper:https://arxiv.org/abs/2203.07669

code:https://github.com/megvii-research/Iter-E2EDET

摘要:在本文中,我们提出了一种新的基于查询的人群检测检测框架。以前的基于查询的检测器有两个缺点:首先,将针对单个对象推断多个预测,通常在拥挤的场景中;其次,性能随着解码阶段深度的增加而饱和。受益于一对一标签分配规则的性质,我们提出了一种渐进式预测方法来解决上述问题。具体来说,我们首先选择容易产生真阳性预测的已接受查询,然后根据先前接受的预测细化其余噪声查询。实验表明,我们的方法可以显着提高基于查询的检测器在拥挤场景中的性能。配备我们的方法,Sparse RCNN 达到 92.0%美联社, 41.4%先生− 2和 83.2%姬在具有挑战性的 CrowdHuman \cite{shao2018crowdhuman} 数据集上,优于指定处理拥挤场景的基于框的方法 MIP \cite{chu2020detection}。此外,所提出的方法对拥挤具有鲁棒性,仍然可以在中等和轻微拥挤的数据集上获得一致的改进,如 CityPersons和 COCO。

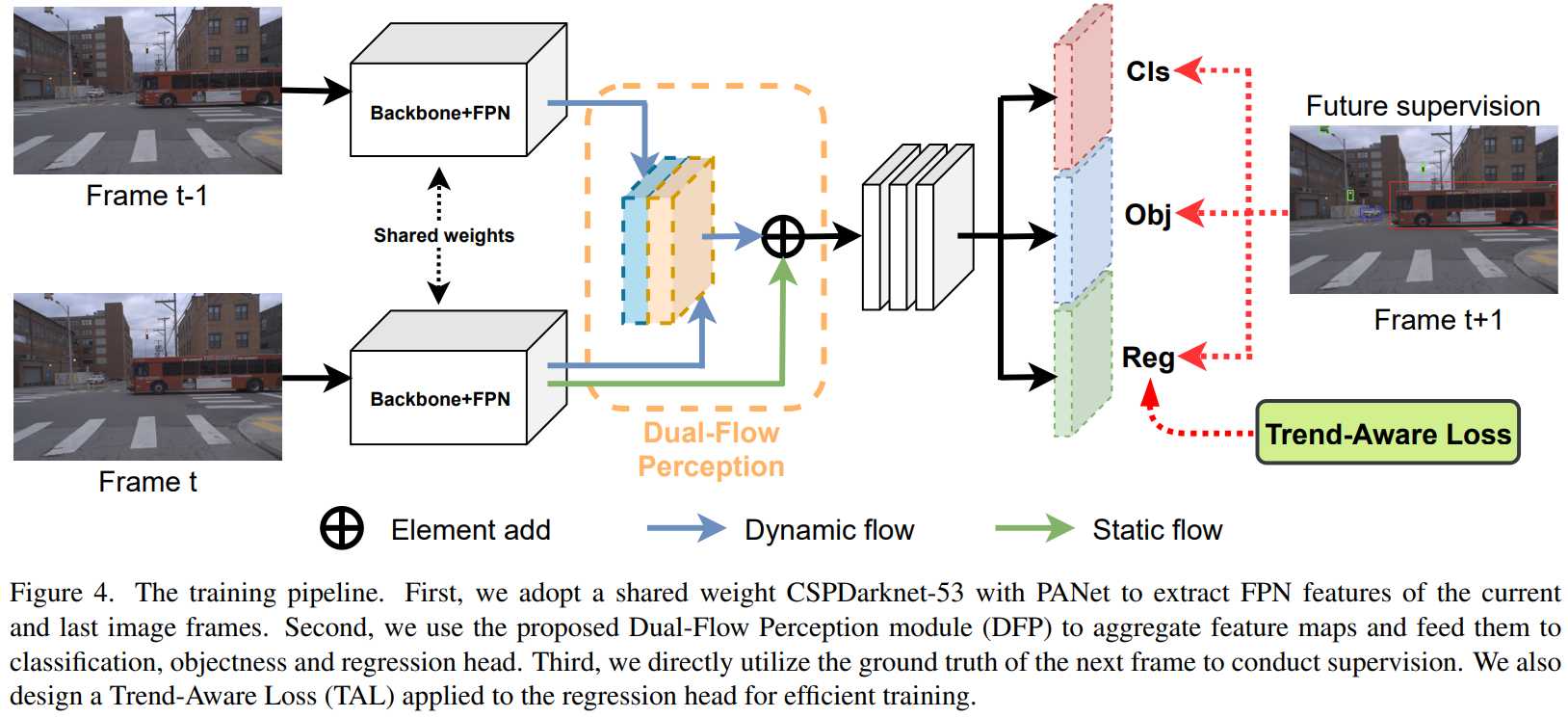

[17] Real-time Object Detection for Streaming Perception(用于流感知的实时对象检测)

paper:https://arxiv.org/abs/2203.12338

code:https://github.com/yancie-yjr/StreamYOLO

摘要:自动驾驶需要模型感知环境并在低延迟内(重新)采取行动以确保安全。虽然过去的工作忽略了处理后环境的不可避免的变化,但提出了流式感知,将延迟和准确性联合评估为视频在线感知的单一指标。在本文中,我们没有像以前的工作那样在准确性和速度之间进行权衡,而是指出赋予实时模型预测未来的能力是解决这个问题的关键。我们为流式感知构建了一个简单有效的框架。它配备了一个新颖的 DualFlow 感知模块 (DFP),其中包括动态和静态流,以捕捉移动趋势和基本检测功能以进行流预测。进一步,我们引入趋势感知损失 (TAL) 与趋势因子相结合,为具有不同移动速度的对象生成自适应权重。我们的简单方法在 Argoverse-HD 数据集上实现了有竞争力的性能,与强基线相比,AP 提高了 4.9%,验证了其有效性。

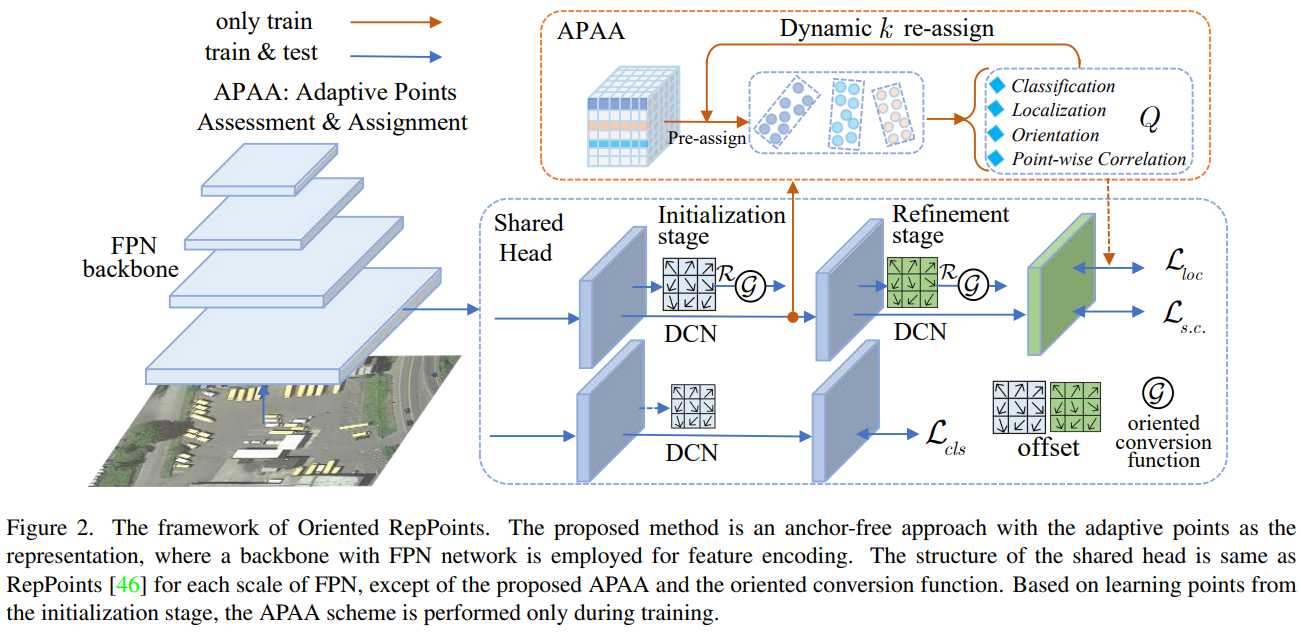

[18]【小目标检测】Oriented RepPoints for Aerial Object Detection(面向空中目标检测的 RepPoints)

paper:https://arxiv.org/abs/2105.11111

code:https://github.com/LiWentomng/OrientedRepPoints

摘要:与通用对象相比,空中目标通常与具有杂乱环境的任意方向非轴对齐。与回归边界框方向的主流方法不同,本文通过利用自适应点表示,提出了一种有效的自适应点学习方法来进行航空目标检测,该方法能够捕获任意方向实例的几何信息。为此,提出了三种定向转换函数,以方便准确定向的分类和定位。此外,我们提出了一种有效的质量评估和样本分配方案,用于自适应点学习,以便在训练期间选择具有代表性的面向代表的重复点样本,它能够从相邻对象或背景噪声中捕获非轴对齐的特征。引入空间约束来惩罚鲁斯特自适应学习的异常点。在包括 DOTA、HRSC2016、UCAS-AOD 和 DIOR-R 在内的四个具有挑战性的航空数据集上的实验结果证明了我们提出的方法的有效性。

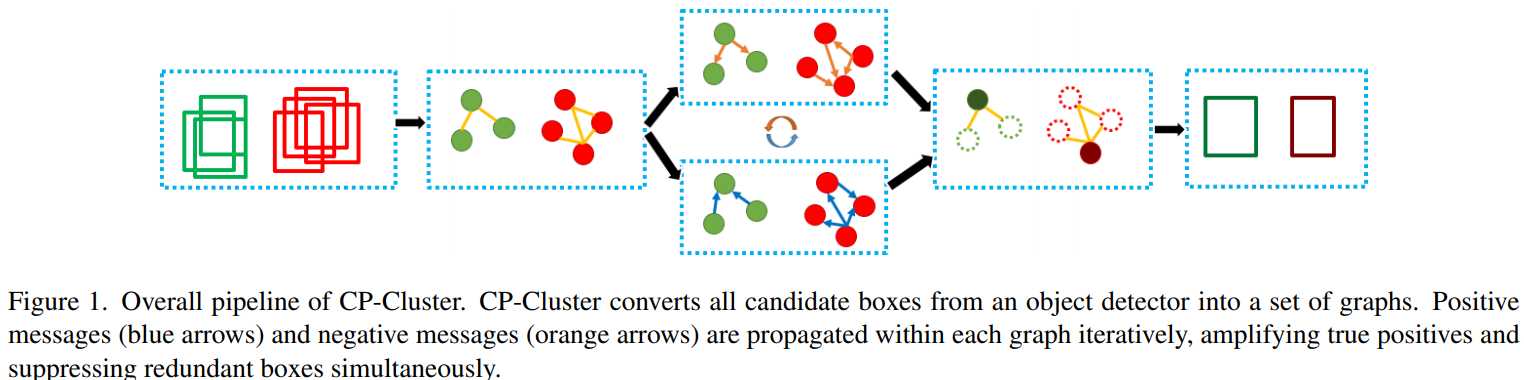

[19] Confidence Propagation Cluster: Unleash Full Potential of Object Detectors(信心传播集群:释放物体检测器的全部潜力)

paper:https://arxiv.org/abs/2112.00342

摘要:长期以来,大多数目标检测方法通过使用非极大值抑制 (NMS) 及其改进版本(如 Soft-NMS)来去除冗余边界框来获取目标。我们从三个方面挑战那些基于 NMS 的方法:1)具有最高置信度值的边界框可能不是与真实框重叠最大的真阳性。2)不仅需要对冗余框进行抑制,而且还需要对那些真正的正例进行置信度增强。3)没有必要按置信度值对候选框进行排序,这样就可以实现完全并行。

在本文中,受信念传播 (BP) 的启发,我们提出了 Confidence Propagation Cluster (CP-Cluster) 来替代基于 NMS 的方法,该方法完全可并行化且准确性更高。在 CP-Cluster 中,我们借用 BP 的消息传递机制来惩罚冗余框并以迭代的方式同时增强真阳性,直到收敛。我们通过将 CP-Cluster 应用于各种主流检测器,如 FasterRCNN、SSD、FCOS、YOLOv3、YOLOv5、Centernet 等验证了 CP-Cluster 的有效性。在 MS COCO 上的实验表明,我们的即插即用方法,无需重新训练检测器,能够稳定与基于 NMS 的方法相比,将所有这些最先进模型的平均 mAP 分别提高了 0.3 到 1.9 的明显余量。

[20] Semantic-aligned Fusion Transformer for One-shot Object Detection(用于一次性目标检测的语义对齐融合转换器)

paper:https://arxiv.org/abs/2203.09093

摘要:One-shot 对象检测旨在仅根据一个给定实例检测新对象。由于数据极度稀缺,目前的方法探索各种特征融合以获得可直接转移的元知识。然而,他们的表现往往不尽如人意。在本文中,我们将此归因于不适当的相关方法,这些方法通过忽略空间结构和尺度变化来错配查询支持语义。经过分析,我们利用注意力机制并提出了一种简单但有效的架构,称为语义对齐融合转换器(SaFT)来解决这些问题。具体来说,我们为 SaFT 配备了用于跨尺度语义增强的垂直融合模块(VFM)和用于跨样本特征融合的水平融合模块(HFM)。一起,他们将每个特征点的视野从支持扩大到查询的整个增强特征金字塔,促进语义对齐的关联。在多个基准上进行的大量实验证明了我们框架的优越性。如果不对新类进行微调,它会为单阶段基线带来显着的性能提升,将最先进的结果提升到更高的水平。

[21]【知识蒸馏】Focal and Global Knowledge Distillation for Detectors(探测器的焦点和全局知识蒸馏)

paper: https://arxiv.org/abs/2111.11837

code: https://github.com/yzd-v/FGD GitHub – yzd-v/FGD: Focal and Global Knowledge Distillation for Detectors (CVPR 2022)

摘要:知识蒸馏已成功应用于图像分类。然而,对象检测要复杂得多,大多数知识蒸馏方法都失败了。在本文中,我们指出,在目标检测中,教师和学生的特征在不同区域有很大差异,尤其是在前景和背景中。如果我们对它们进行同等蒸馏,特征图之间的不均匀差异将对蒸馏产生负面影响。因此,我们提出了焦点和全局蒸馏(FGD)。焦点蒸馏将前景和背景分开,迫使学生专注于教师的关键像素和通道。全局蒸馏重建不同像素之间的关系并将其从教师转移到学生,以补偿焦点蒸馏中丢失的全局信息。由于我们的方法只需要计算特征图上的损失,因此 FGD 可以应用于各种检测器。我们在具有不同主干的各种检测器上进行了实验,结果表明学生检测器实现了出色的 mAP 改进。例如,基于 ResNet-50 的 RetinaNet、Faster RCNN、RepPoints 和 Mask RCNN 与我们的蒸馏方法在 COCO2017 上实现了 40.7%、42.0%、42.0% 和 42.1% 的 mAP,比基线高 3.3、3.6、3.4 和 2.9,分别。我们的代码可在 RepPoints 和 Mask RCNN 与我们的蒸馏方法在 COCO2017 上实现了 40.7%、42.0%、42.0% 和 42.1% 的 mAP,分别比基线高 3.3、3.6、3.4 和 2.9。我们的代码可在 RepPoints 和 Mask RCNN 与我们的蒸馏方法在 COCO2017 上实现了 40.7%、42.0%、42.0% 和 42.1% 的 mAP,分别比基线高 3.3、3.6、3.4 和 2.9。

二、其他

[1]【显著性目标检测】Democracy Does Matter: Comprehensive Feature Mining for Co-Salient Object Detection(共同显著性目标检测的综合特征挖掘)

paper: https://arxiv.org/abs/2203.05787

code:待更新

摘要:以检测一组图像中共存的显著目标为目标的共显著目标检测正日益受到人们的欢迎。最近的研究使用注意机制或额外信息来聚集共同的显著特征,导致对目标对象的不完整甚至不正确的反应。在本文中,我们的目标是在不引入任何额外信息的情况下,挖掘具有民主性的综合共显特征,并减少背景干扰。为了实现这一点,我们设计了一个民主原型生成模块来生成民主响应图,覆盖足够多的共显区域,从而涉及到更多共显对象的共享属性。然后根据响应图生成一个综合原型,作为最终预测的指南。为了抑制原型中的噪声背景信息,我们提出了一个自对比学习模块,该模块在不依赖额外分类信息的情况下形成正负对。此外,我们还设计了一个民主特征增强模块,通过调整注意值来进一步增强共显特征。大量实验表明,我们的模型比以前最先进的方法获得了更好的性能,尤其是在具有挑战性的真实案例中(例如,对于CoCA,我们在相同设置下获得了2.0%的MAE增益、5.4%的最大F-测度增益、2.3%的最大e-测度增益和3.7%的S-测度增益)。

本文网络的框架和学习过程。该网络包含五个主要部分,包括特征提取模块、民主原型生成模块(DPG)、自对比学习模块(SCL)、民主特征增强模块(DFE)和解码器。SCL仅在训练期间使用。

[2]【显著性目标检测】Bi-directional Object-context Prioritization Learning for Saliency Ranking(显着性排名的双向对象上下文优先级学习)

paper:https://arxiv.org/abs/2203.09416

code:https://github.com/GrassBro/OCOR

摘要:最近提出了显着性排序任务来研究人类通常会根据其显着程度将注意力转移到场景的不同对象上的视觉行为。现有方法侧重于学习对象-对象或对象-场景关系。这种策略遵循了心理学中基于对象的注意力的思想,但它倾向于偏爱那些具有强烈语义的对象(例如,人类),从而导致不切实际的显着性排名。我们观察到空间注意与人类视觉识别系统中基于对象的注意同时工作。在识别过程中,人类空间注意力机制会从一个区域到另一个区域(即上下文到上下文)移动、参与和脱离。这激发了我们对区域级交互进行建模,除了对象级推理,用于显着性排名。为此,我们提出了一种新颖的双向方法来统一空间注意力和基于对象的注意力以进行显着性排名。我们的模型包括两个新颖的模块:(1)选择性对象显着性(SOS)模块,通过推断显着对象的语义表示来模拟基于对象的注意力,以及(2)分配显着性的对象-上下文-对象关系(OCOR)模块通过联合建模显着对象的对象-上下文和上下文-对象交互来对对象进行排名。大量实验表明,我们的方法优于现有的状态方法。我们的代码和预训练模型可在 (1) 选择性对象显着性 (SOS) 模块,通过推断显着对象的语义表示对基于对象的注意力进行建模,以及 (2) 对象-上下文-对象关系 (OCOR) 模块,通过联合建模为对象分配显着性等级显着对象的对象-上下文和上下文-对象交互。大量实验表明,我们的方法优于现有的状态方法。我们的代码和预训练模型可在 (1) 选择性对象显着性 (SOS) 模块,通过推断显着对象的语义表示对基于对象的注意力进行建模,以及 (2) 对象-上下文-对象关系 (OCOR) 模块,通过联合建模为对象分配显着性等级显着对象的对象-上下文和上下文-对象交互。大量实验表明,我们的方法优于现有的状态方法。我们的代码和预训练模型可在 大量实验表明,我们的方法优于现有的状态方法。我们的代码和预训练模型可在 大量实验表明,我们的方法优于现有的状态方法。

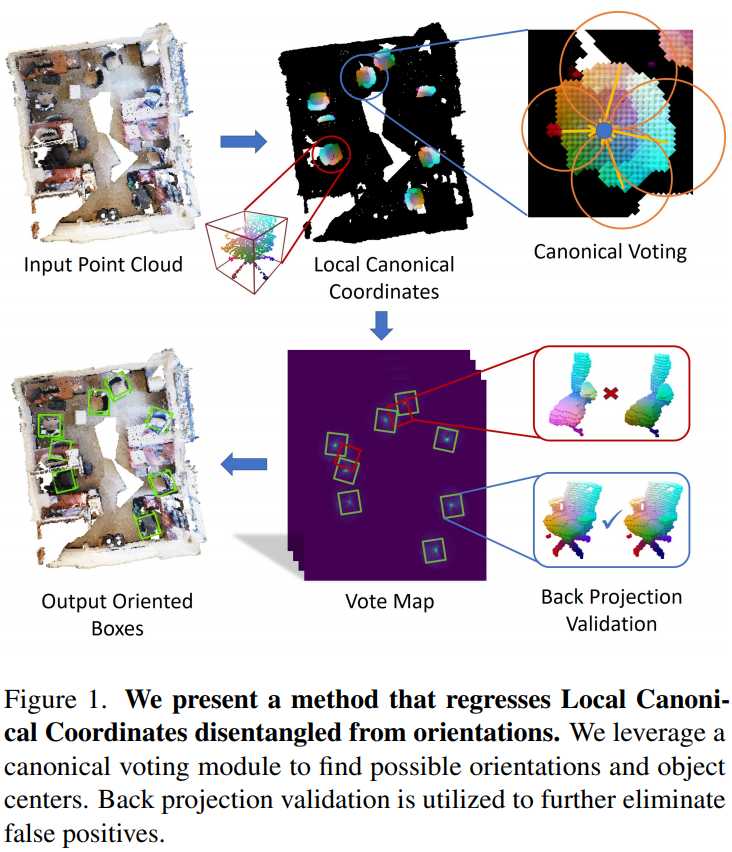

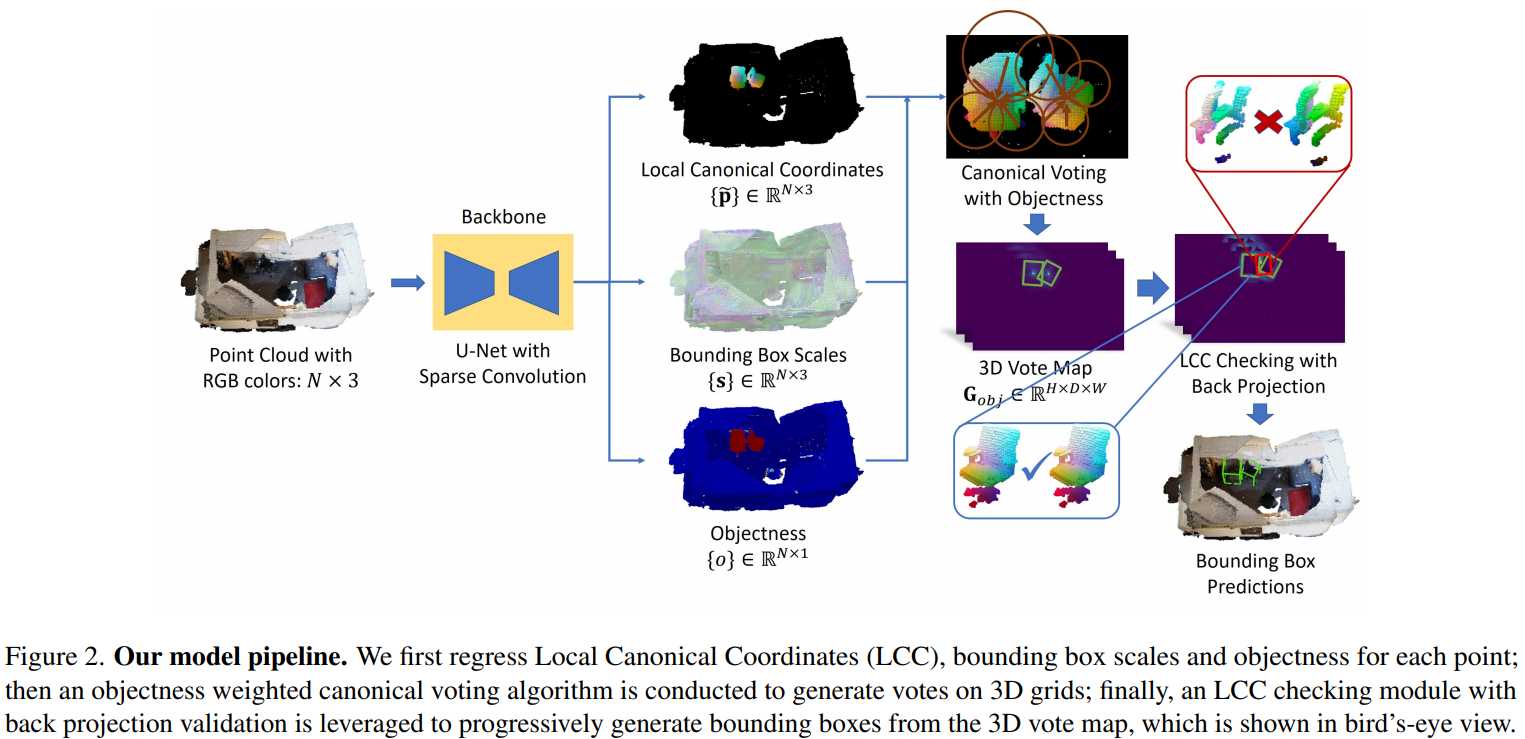

[3]【3D目标检测】Canonical Voting: Towards Robust Oriented Bounding Box Detection in 3D Scenes(规范投票:面向三维场景的鲁棒包围盒检测)

paper: https://arxiv.org/abs/2011.12001

code: https://github.com/qq456cvb/CanonicalVoting

摘要:由于传感器和点云深度学习方法的进步,三维目标检测已经引起了广泛关注。目前最先进的方法,如VoteNet,使用附加的多层感知器网络,将直接偏移回归到对象中心和盒子方向。由于旋转分类的根本困难,它们的偏移量和方向预测都不准确。在这项工作中,我们将直接偏移分解为局部正则坐标(LCC)、盒尺度和盒方向。只有LCC和盒子尺度是回归的,而盒子方向是由标准投票方案生成的。最后,一个LCC感知的反投影检查算法迭代地从生成的投票映射中切出边界框,并消除误报。我们的模型在三个标准的现实世界基准上实现了最先进的性能:ScanNet、SceneNN和SUN RGB-D。

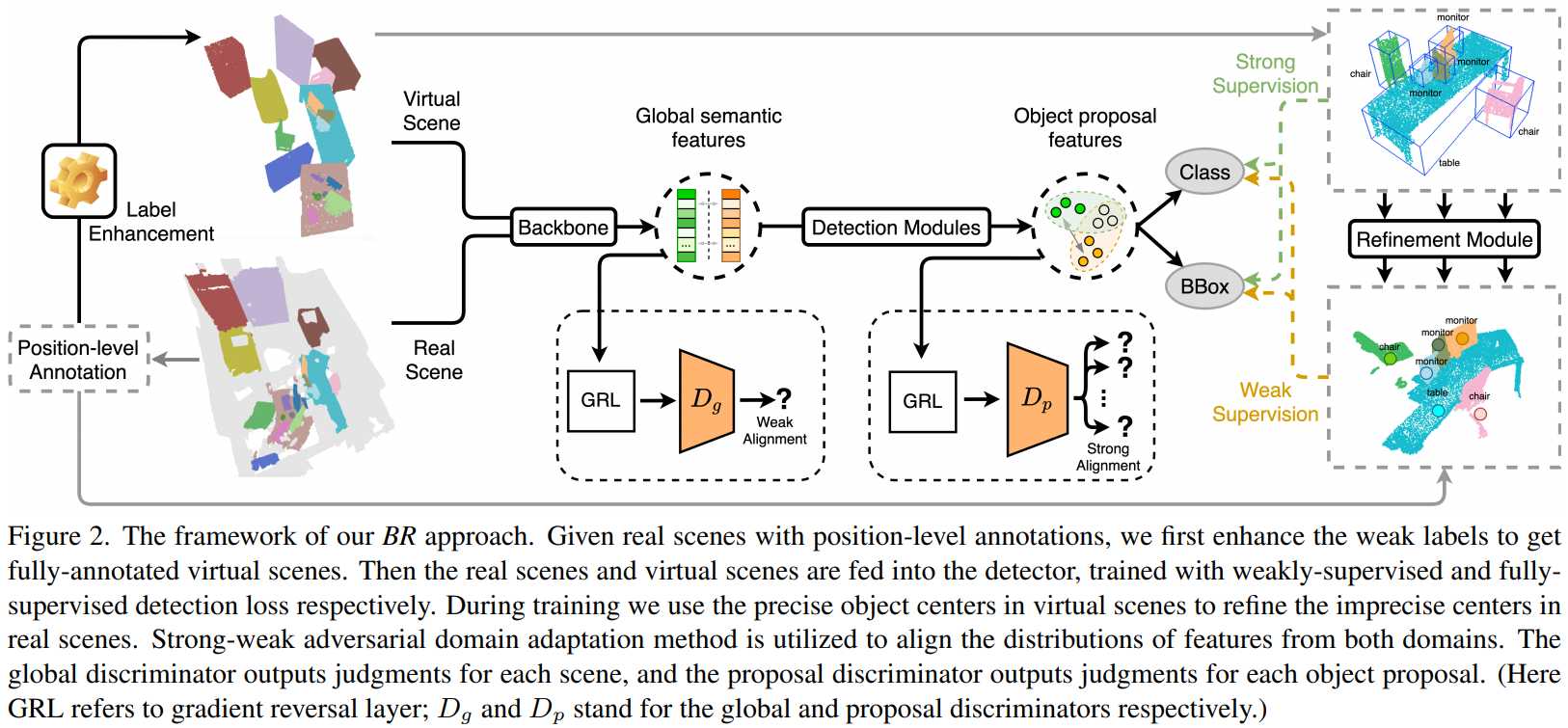

[4]【3D目标检测】Back to Reality: Weakly-supervised 3D Object Detection with Shape-guided Label Enhancement(回到现实:带有形状引导标签增强的弱监督 3D 对象检测)

paper: https://arxiv.org/abs/2203.05238

code: https://github.com/xuxw98/BackToReality

摘要:在本文中,我们提出了一种用于 3D 对象检测的弱监督方法,这使得使用位置级注释(即对象中心的注释)训练强 3D 检测器成为可能。为了弥补从框注释到中心的信息丢失,我们的方法,即回到现实(BR),利用合成的 3D 形状将弱标签转换为全注释的虚拟场景作为更强的监督,进而利用完美的虚拟标签补充和完善真实标签。具体来说,我们首先根据从位置级注释中提取的粗略场景布局,将 3D 形状组装成物理上合理的虚拟场景。然后我们通过应用虚拟到现实的域适应方法回到现实,它细化了弱标签,并用虚拟场景额外监督检测器的训练。此外,我们提出了一个更具挑战性的室内 3D 目标检测基准,目标大小更加多样化,以更好地展示 BR 的潜力。只需不到 5% 的标记工作,我们就可以在广泛使用的 ScanNet 数据集上与一些流行的全监督方法实现相当的检测性能。

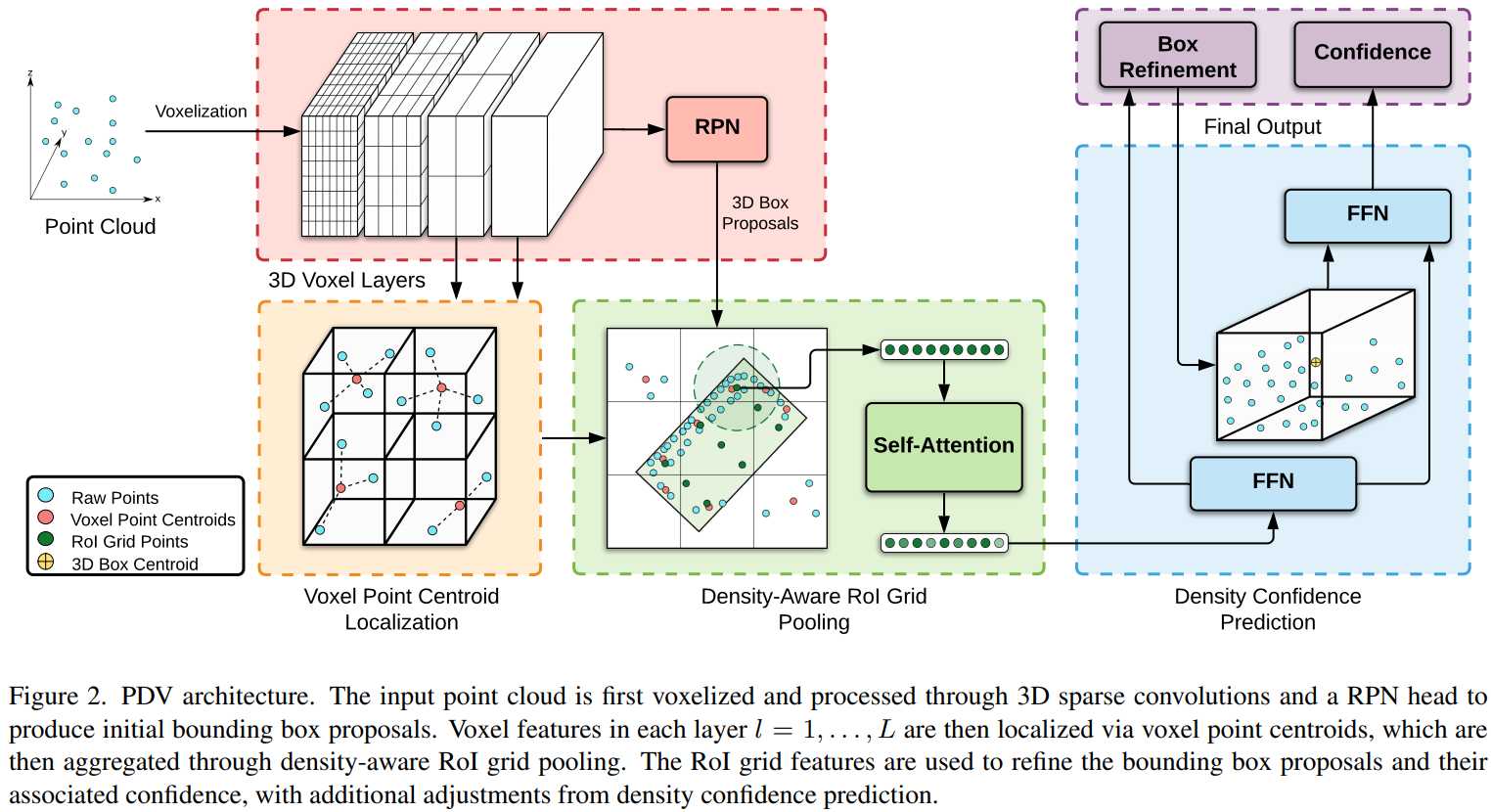

[5]【3D目标检测】Point Density-Aware Voxels for LiDAR 3D Object Detection(用于 LiDAR 3D 对象检测的点密度感知体素)

paper: https://arxiv.org/abs/2203.05662

code: https://github.com/TRAILab/PDV

摘要:LiDAR 已成为自动驾驶中主要的 3D 物体检测传感器之一。然而,随着距离的增加,LiDAR 的发散点模式会导致不均匀的采样点云不适合离散化的体积特征提取。当前的方法要么依赖体素化点云,要么使用低效的最远点采样来减轻由密度变化引起的不利影响,但在很大程度上忽略了点密度作为特征及其与 LiDAR 传感器距离的可预测关系。我们提出的解决方案点密度感知体素网络 (PDV) 是一种端到端的两级 LiDAR 3D 对象检测架构,旨在解决这些点密度变化。PDV 通过体素点质心有效地定位来自 3D 稀疏卷积主干的体素特征。然后通过密度感知 RoI 网格池化模块使用核密度估计 (KDE) 和具有点密度位置编码的自我注意来聚合空间局部化的体素特征。最后,我们利用 LiDAR 的点密度与距离的关系来改进我们最终的边界框置信度。PDV 在 Waymo 开放数据集上优于所有最先进的方法,并在 KITTI 数据集上取得了具有竞争力的结果。我们提供了 PDV 的代码版本,可在 PDV 在 Waymo 开放数据集上优于所有最先进的方法,并在 KITTI 数据集上取得了具有竞争力的结果。我们提供了 PDV 的代码版本,可在 PDV 在 Waymo 开放数据集上优于所有最先进的方法,并在 KITTI 数据集上取得了具有竞争力的结果。

[6]【3D目标检测】A Versatile Multi-View Framework for LiDAR-based 3D Object Detection with Guidance from Panoptic Segmentation(在全景分割的指导下,用于基于 LiDAR 的 3D 对象检测的多功能多视图框架)

paper: https://arxiv.org/abs/2203.02133

code: 暂无

摘要:使用 LiDAR 数据进行 3D 对象检测是自动驾驶系统不可或缺的组成部分。然而,只有少数基于 LiDAR 的 3D 对象检测方法利用分割信息来进一步指导检测过程。在本文中,我们提出了一种新颖的多任务框架,该框架联合执行 3D 对象检测和全景分割。在我们的方法中,鸟瞰图 (BEV) 平面中的 3D 对象检测主干通过从 3D 全景分割主干注入范围视图 (RV) 特征图来增强。这使检测主干能够利用多视图信息来解决每个投影视图的缺点。此外,通过突出显示特征图中每个对象类的位置,结合了前景语义信息以简化检测任务。最后,基于实例级信息生成的新中心密度热图通过建议对象的可能框中心位置来进一步指导检测主干。我们的方法适用于任何基于 BEV 的 3D 对象检测方法,并且如在 nuScenes 数据集上的大量实验所示,它提供了显着的性能提升。值得注意的是,所提出的基于单阶段 CenterPoint 3D 对象检测网络的方法在 nuScenes 3D 检测基准上以 67.3 NDS 实现了最先进的性能。

[7]【3D目标检测】Pseudo-Stereo for Monocular 3D Object Detection in Autonomous Driving(自动驾驶中用于单目 3D 目标检测的伪立体)

paper: https://arxiv.org/abs/2203.02112

code: https://github.com/revisitq/Pseudo-Stereo-3D GitHub – revisitq/Pseudo-Stereo-3D

摘要:伪激光雷达 3D 检测器通过使用深度估计网络增强感知深度的能力,并使用基于激光雷达的 3D 检测架构,在单目 3D 检测方面取得了显着进展。先进的立体 3D 检测器还可以准确定位 3D 对象。立体视图的图像到图像生成的差距远小于图像到 LiDAR 生成的差距。受此启发,我们提出了一种伪立体 3D 检测框架,该框架具有三种新颖的虚拟视图生成方法,包括图像级生成、特征级生成和特征克隆,用于从单个图像中检测 3D 对象。我们对深度感知学习的分析表明,深度损失仅在特征级虚拟视图生成中有效,而估计的深度图在我们框架中的图像级和特征级均有效。我们提出了一种视差动态卷积,其中动态内核从视差特征图中采样,以自适应地从单个图像中过滤特征以生成虚拟图像特征,从而缓解了由深度估计误差引起的特征退化。直到提交(2021 年 11 月 18 日),我们的 Pseudo-Stereo 3D 检测框架在 KITTI-3D 基准上发表的单目 3D 检测器中汽车、行人和骑自行车的人排名第一。代码发布于 我们的 Pseudo-Stereo 3D 检测框架在 KITTI-3D 基准上发表的单目 3D 检测器中,在汽车、行人和骑自行车的人中排名第一。代码发布于 我们的 Pseudo-Stereo 3D 检测框架在 KITTI-3D 基准上发表的单目 3D 检测器中,在汽车、行人和骑自行车的人中排名第一。

[8] 【伪装目标检测】Zoom In and Out: A Mixed-scale Triplet Network for Camouflaged Object Detection(放大和缩小:用于伪装目标检测的混合尺度三元组网络)

paper: https://arxiv.org/abs/2203.02688

code: https://github.com/lartpang/ZoomNet

摘要:最近提出的伪装对象检测 (COD) 试图分割在视觉上融入其周围环境的对象,这在现实世界的场景中是极其复杂和困难的。除了伪装对象与其背景之间的高度内在相似性外,对象通常规模多样,外观模糊,甚至被严重遮挡。为了解决这些问题,我们提出了一个混合尺度的三元组网络 ZoomNet,它模仿人类在观察模糊图像时的行为,即放大和缩小。具体来说,我们的 ZoomNet 采用缩放策略,通过设计的尺度集成单元和分层混合尺度单元来学习判别性混合尺度语义,充分探索候选对象与背景环境之间难以察觉的线索。而且,考虑到来自不可区分纹理的不确定性和模糊性,我们构建了一个简单而有效的正则化约束,即不确定性感知损失,以促进模型准确地产生对候选区域具有更高置信度的预测。没有花里胡哨的东西,我们提出的高度任务友好的模型在四个公共数据集上始终超过现有的 23 种最先进的方法。此外,在 SOD 任务上优于近期前沿模型的性能也验证了我们模型的有效性和通用性。代码将在 \url{ 处提供 促进模型准确地产生对候选区域具有更高置信度的预测。没有花里胡哨的东西,我们提出的高度任务友好的模型在四个公共数据集上始终超过现有的 23 种最先进的方法。此外,在 SOD 任务上优于近期前沿模型的性能也验证了我们模型的有效性和通用性。代码将在 \url{ 处提供 促进模型准确地产生对候选区域具有更高置信度的预测。没有花里胡哨的东西,我们提出的高度任务友好的模型在四个公共数据集上始终超过现有的 23 种最先进的方法。此外,在 SOD 任务上优于近期前沿模型的性能也验证了我们模型的有效性和通用性。

[9] 【模型训练】DN-DETR: Accelerate DETR Training by Introducing Query DeNoising(DN-DETR:通过引入查询去噪加速DETR训练)

paper: https://arxiv.org/abs/2203.01305

code: https://github.com/FengLi-ust/DN-DETR

摘要:本文提出了一种新的去噪训练方法来加速DETR(DEtection TRansformer)训练,加深了对类DETR方法收敛缓慢问题的理解。我们发现,这种缓慢的收敛是由于二部图匹配的不稳定性导致了早期训练阶段的优化目标不一致。为了解决这个问题,除了Hungarian损失外,我们的方法还将带噪声的ground-truth边界框输入到Transformer解码器中,并训练模型重建原始框,这有效地降低了二分图匹配的难度,并导致更快的收敛。该方法是通用的,可以通过添加几十行代码轻松地插入任何类似DETR的方法,从而实现显著的改进。因此,我们的DN-DETR在相同的设置下取得了显著的改善(+1.9AP),并且在使用ResNet-50主干的DETR类方法中取得了最好的结果(分别为AP43.4和48.6,训练时间分别为12和50个)。与相同设置下的基线相比,DN-DETR在50%的训练时间内取得了相当的性能。

[10]【视觉定位/位姿估计】Spatial Commonsense Graph for Object Localisation in Partial Scenes(局部场景中对象定位的空间常识图)

paper: https://arxiv.org/abs/2203.05380

code: 暂无

摘要:我们解决了部分场景中的对象定位问题,这是一个在给定场景的部分 3D 扫描的情况下估计对象的未知位置((e.g. where is the bag?)的新问题。所提出的解决方案基于一种新颖的场景图模型,即空间常识图 (SCG),其中对象是节点,边定义了它们之间的成对距离,并通过常识知识库中的概念节点和关系进行了丰富。这使得 SCG 能够更好地概括其对未知 3D 场景的空间推断。SCG 用于通过两个步骤估计目标对象的未知位置:首先,我们将 SCG 输入一个新颖的 Proximity Prediction Network,这是一种使用注意力来执行表示目标对象的节点与目标对象之间的距离预测的图神经网络。表示 SCG 中观察到的对象的节点;第二,我们提出了一个基于圆形相交的定位模块,以使用所有预测的成对距离来估计对象位置,以便独立于任何参考系统。我们创建了一个部分重建场景的新数据集,以对我们的方法和部分场景中目标定位的基线进行基准测试,其中我们提出的方法实现了最佳定位性能。

[11]【遥感图像–GAN】Adversarial Texture for Fooling Person Detectors in the Physical World(物理世界中愚弄人探测器的对抗性纹理)

paper: https://arxiv.org/abs/2203.03373

code: TBD

摘要:如今,配备人工智能系统的相机可以捕捉和分析图像以自动检测人。然而,人工智能系统在接收现实世界中故意设计的模式时可能会出错,即物理对抗样本。先前的工作表明,可以在衣服上打印对抗性补丁来规避基于 DNN 的人员检测器。然而,当视角(即相机朝向物体的角度)发生变化时,这些对抗性示例可能会导致攻击成功率出现灾难性下降。为了执行多角度攻击,我们提出了对抗纹理(AdvTexture)。AdvTexture 可以覆盖任意形状的衣服,这样穿着这种衣服的人就可以从不同的视角躲避人体探测器。我们提出了一种生成方法,命名为基于环形裁剪的可扩展生成攻击 (TC-EGA),用于制作具有重复结构的 AdvTexture。我们用 AdvTexure 打印了几块布,然后在现实世界中制作了 T 恤、裙子和连衣裙。实验表明,这些衣服可以欺骗物理世界中的人体探测器。

[12]【车道线检测】Rethinking Efficient Lane Detection via Curve Modeling(通过曲线建模重新思考高效车道检测)

paper: https://arxiv.org/abs/2203.02431

code: https://github.com/voldemortX/pytorch-auto-drive GitHub – voldemortX/pytorch-auto-drive: Segmentation models (ERFNet, ENet, DeepLab, FCN…) and Lane detection models (SCNN, PRNet, RESA, LSTR, BézierLaneNet…) based on PyTorch with mixed precision training

摘要:本文提出了一种新的基于参数曲线的 RGB 图像车道检测方法。与最先进的基于分割和基于点检测的方法通常需要启发式解码预测或制定大量锚点不同,基于曲线的方法可以自然地学习整体车道表示。为了解决现有多项式曲线方法的优化困难,我们建议利用参数化贝塞尔曲线,因为它易于计算、稳定性和高自由度的变换。此外,我们提出了基于可变形卷积的特征翻转融合,以利用驾驶场景中车道的对称性。所提出的方法在流行的 LLAMAS 基准上实现了新的最先进的性能。它还在 TuSimple 和 CULane 数据集上实现了良好的准确性,同时保持了低延迟 (> 150 FPS) 和小模型大小 (< 10M)。我们的方法可以作为新的基线,以阐明用于车道检测的参数曲线建模。

[13]【迁移学习/domain/自适应】Weakly Supervised Object Localization as Domain Adaption(作为域适应的弱监督对象定位)

paper: https://arxiv.org/abs/2203.01714

code: https://github.com/zh460045050/DA-WSOL_CVPR2022

摘要:弱监督对象定位 (WSOL) 专注于仅在图像级分类掩码的监督下定位对象。大多数以前的 WSOL 方法都遵循分类激活图 (CAM),它基于具有多实例学习 (MIL) 机制的分类结构来定位对象。然而,MIL 机制使得 CAM 只激活有区别的对象部分而不是整个对象,削弱了其定位对象的性能。为了避免这个问题,这项工作提供了一个新颖的视角,将 WSOL 建模为域适应 (DA) 任务,其中在源/图像域上训练的分数估计器在目标/像素域上进行测试以定位对象。从这个角度来看,DA-WSOL 管道旨在更好地将 DA 方法引入 WSOL 以提高本地化性能。它利用提出的目标采样策略来选择不同类型的目标样本。基于这些类型的目标样本,详细阐述了域适应定位 (DAL) 损失。它通过 DA 对齐两个域之间的特征分布,并通过 Universum 正则化使估计器感知目标域线索。实验表明,我们的管道在多基准测试中优于 SOTA 方法。

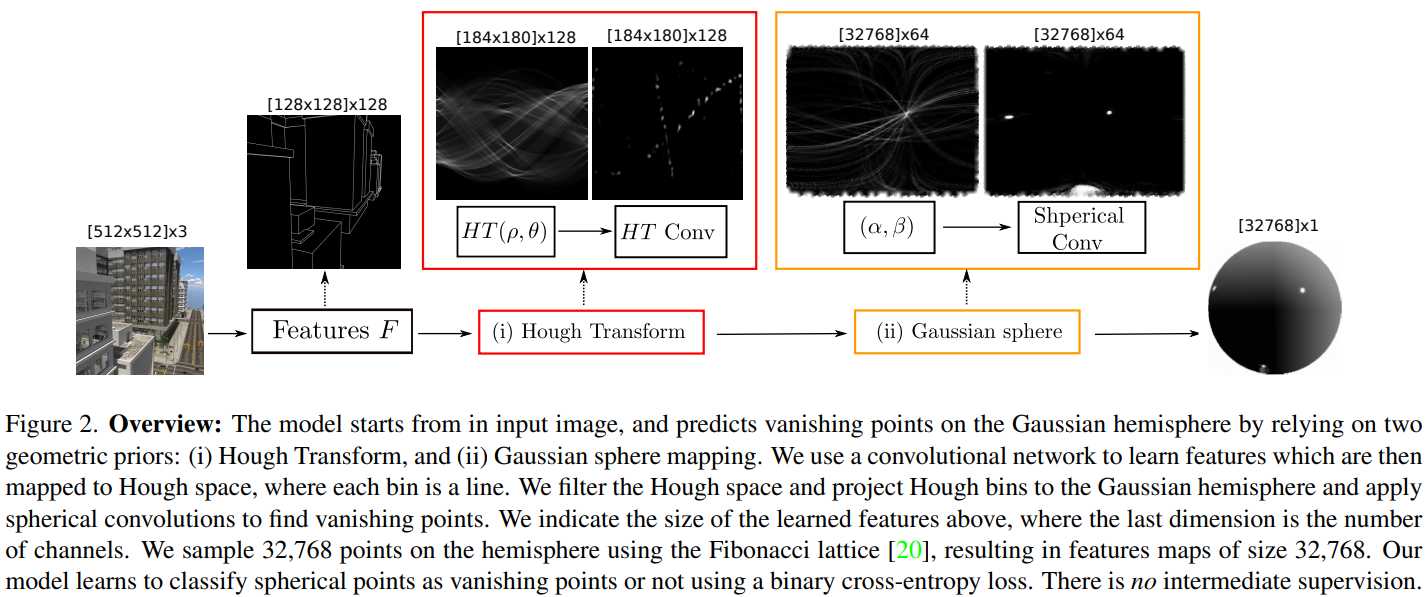

[14]【消失点检测】Deep vanishing point detection: Geometric priors make dataset variations vanish(深度消失点检测:几何先验使数据集变化消失)

paper:https://arxiv.org/abs/2203.08586

code:https://github.com/yanconglin/VanishingPoint_HoughTransform_GaussianSphere

摘要:深度学习改进了图像中的消失点检测。然而,深度网络需要在昂贵的硬件上训练的昂贵的注释数据集,并且不能推广到甚至略有不同的领域和较小的问题变体。在这里,我们通过注入具有先验知识的深度消失点检测网络来解决这些问题。这种先验知识不再需要从数据中学习,节省了宝贵的注释工作和计算,解锁了现实的少样本场景,并减少了领域变化的影响。此外,先验的可解释性允许深度网络适应较小的问题变化,例如在曼哈顿和非曼哈顿世界之间切换。我们无缝地结合了两个几何先验:(i)霍夫变换——将图像像素映射到直线,(ii) 高斯球——将线映射到大圆,其交点表示消失点。在实验上,我们消除了我们的选择,并在大数据设置中显示出与现有模型相当的准确性。我们验证了我们的模型改进的数据效率、对域变化的鲁棒性、对非曼哈顿设置的适应性。

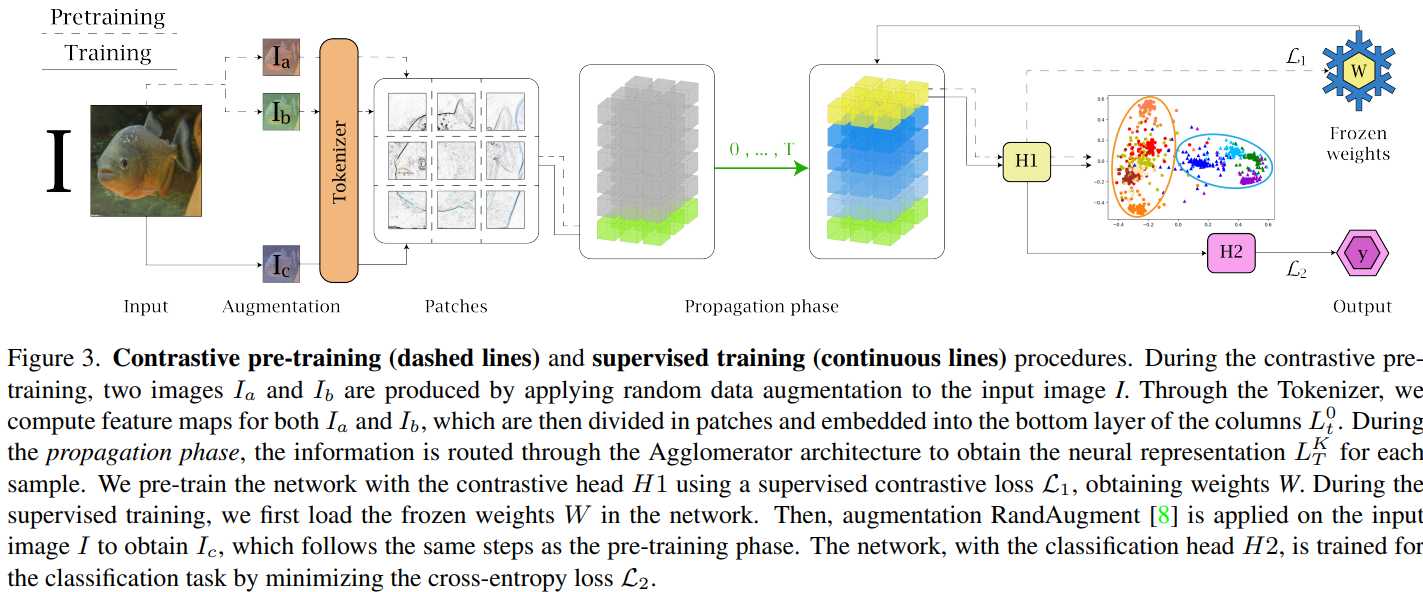

[15]【神经网络可解释性】Interpretable part-whole hierarchies and conceptual-semantic relationships in neural networks(神经网络中可解释的部分-整体层次结构和概念语义关系)

paper:https://arxiv.org/abs/2203.03282

摘要:深度神经网络在各种各样的任务中取得了出色的成绩,通常优于人类专家。然而,当前神经架构的一个已知限制是难以理解和解释网络对给定输入的响应。这与神经模型的大量变量和相关的非线性直接相关,这些模型通常被用作黑匣子。当涉及到自动驾驶、安全和安全、医学和健康等关键应用时,尽管这些系统在给定任务中的性能准确,但网络行为缺乏可解释性往往会引起怀疑和有限的可信度。此外,一个单一的指标,如分类准确度,提供了对大多数现实世界场景的非详尽评估。在本文中,我们希望朝着神经网络的可解释性迈出一步,提供新的工具来解释它们的行为。我们提出了 Agglomerator,这是一个框架,能够提供来自视觉线索的部分整体层次结构的表示,并组织与类之间的概念语义层次结构匹配的输入分布。我们在常见数据集(如 SmallNORB、MNIST、FashionMNIST、CIFAR-10 和 CIFAR-100)上评估我们的方法,提供比其他最先进方法更具可解释性的模型。一个框架,能够根据视觉线索提供部分整体层次结构的表示,并组织与类之间的概念语义层次结构匹配的输入分布。我们在常见数据集(如 SmallNORB、MNIST、FashionMNIST、CIFAR-10 和 CIFAR-100)上评估我们的方法,提供比其他最先进方法更具可解释性的模型。一个框架,能够根据视觉线索提供部分整体层次结构的表示,并组织与类之间的概念语义层次结构匹配的输入分布。我们在常见数据集(如 SmallNORB、MNIST、FashionMNIST、CIFAR-10 和 CIFAR-100)上评估我们的方法,提供比其他最先进方法更具可解释性的模型。

今天的文章CVPR2022 目标检测方向文章(附摘要)分享到此就结束了,感谢您的阅读,如果确实帮到您,您可以动动手指转发给其他人。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌侵权/违法违规的内容, 请发送邮件至 举报,一经查实,本站将立刻删除。

如需转载请保留出处:https://bianchenghao.cn/32771.html