导言:本文从微积分相关概念,梳理到概率论与数理统计中的相关知识,但本文之压轴戏在本文第4节(彻底颠覆以前读书时大学课本灌输给你的观念,一探正态分布之神秘芳踪,知晓其前后发明历史由来),相信,每一个学过概率论与数理统计的朋友都有必要了解数理统计学简史,因为,只有了解各个定理.公式的发明历史,演进历程.相关联系,才能更好的理解你眼前所见到的知识,才能更好的运用之。

前言

一个月余前,在微博上感慨道,不知日后是否有无机会搞DM,微博上的朋友只看不发的围脖评论道:算法研究领域,那里要的是数学,你可以深入学习数学,将算法普及当兴趣。想想,甚合我意。自此,便从rickjin写的“正态分布的前世今生”开始研习数学。

如之前微博上所说,“今年5月接触DM,循序学习决策树.贝叶斯,SVM.KNN,感数学功底不足,遂补数学,从‘正态分布的前后今生’中感到数学史有趣,故买本微积分概念发展史读,在叹服前人伟大的创造之余,感微积分概念模糊,复习高等数学上册,完后学概率论与数理统计,感概道:微积分是概数统计基础,概数统计则是DM&ML之必修课。”包括读者相信也已经感觉到,我在写这个Top 10 Algorithms in Data Mining系列的时候,其中涉及到诸多的数学概念与基础知识(例如此篇SVM文章内诸多max.s.t.对偶.KKT条件.拉格朗日.松弛因子等问题则皆属于数学内一分支:最优化理论与算法范畴内),特别是概率论与数理统计部分。更进一步,在写上一篇文章的时候,看到机器学习中那么多距离度量的表示法,发现连最起码的期望,方差,标准差等基本概念都甚感模糊,于此,便深感数学之重要性。

很快,我便买了一本高等教育出版社出版的概率论与数理统计一书,此书“从0-1分布、到二项分布、正态分布,概率密度函数,从期望到方差、标准差、协方差,中心极限定理,样本和抽样,从最大似然估计量到各种置信区间,从方差分析到回归分析,bootstrap方法,最后到马尔可夫链,以前在学校没开概率论与数理统计这门课,现在有的学有的看了”。且人类发明计算机,是为了辅助人类解决现实生活中遇到的问题,然计算机科学毕竟只发展了数十年,可在数学.统计学中,诸多现实生活问题已经思考了数百年甚至上千年,故,计算机若想更好的服务人类解决问题,须有效借鉴或参考数学.统计学。世间万事万物,究其本质乃数学,于变化莫测中寻其规律谓之统计学。

话休絮烦。本文结合高等数学上下册、微积分概念发展史,概率论与数理统计、数理统计学简史等书,及rickjin写的“正态分布的前世今生”系列(此文亦可看作读书笔记或读后感)与wikipedia整理而成,对数据挖掘中所需的概率论与数理统计相关知识概念作个总结梳理,方便你我随时查看复习相关概念,而欲深入学习研究的课后还需参看相关专业书籍.资料。同时,本文篇幅会比较长,简单来说:

- 第一节、介绍微积分中极限、导数,微分、积分等相关概念;

- 第二节、介绍随机变量及其分布;

- 第三节、介绍数学期望.方差.协方差.相关系数.中心极限定理等概念;

- 第四节、依据数理统计学简史介绍正态分布的前后由来;

- 第五节、论道正态,介绍正态分布的4大数学推导。

5部分起承转合,彼此依托,层层递进。且在本文中,会出现诸多并不友好的大量各种公式,但基本的概念.定理是任何复杂问题的根基,所以,你我都有必要硬着头皮好好细细阅读。最后,本文若有任何问题或错误,恳请广大读者朋友们不吝批评指正,谢谢。

第一节、微积分的基本概念

开头前言说,微积分是概数统计基础,概数统计则是DM&ML之必修课”,是有一定根据的,包括后续数理统计当中,如正态分布的概率密度函数中用到了相关定积分的知识,包括最小二乘法问题的相关探讨求证都用到了求偏导数的等概念,这些都是跟微积分相关的知识。故咱们第一节先复习下微积分的相关基本概念。

事实上,古代数学中,单单无穷小、无穷大的概念就讨论了近200年,而后才由无限发展到极限的概念。

1.1、极限

极限又分为两部分:数列的极限和函数的极限。

1.1.1、数列的极限

定义 如果数列{xn}与常a 有下列关系:对于任意给定的正数e (不论它多么小), 总存在正整数N , 使得对于n >N 时的一切xn, 不等式 |xn-a |<e都成立, 则称常数a 是数列{xn}的极限, 或者称数列{xn}收敛于a , 记为

也就是说,

1.1.2、函数的极限

设函数f(x)在点x0的某一去心邻域内有定义. 如果存在常数A, 对于任意给定的正数e (不论它多么小), 总存在正数d, 使得当x满足不等式0<|x-x0|<d 时, 对应的函数值f(x)都满足不等式 |f(x)-A|<e , 那么常数A就叫做函数f(x)时

也就是说,

几乎没有一门新的数学分支是某个人单独的成果,如笛卡儿和费马的解析几何不仅仅是他们两人研究的成果,而是若干数学思潮在16世纪和17世纪汇合的产物,是由许许多多的学者共同努力而成。

甚至微积分的发展也不是牛顿与莱布尼茨两人之功。在17世纪下半叶,数学史上出现了无穷小的概念,而后才发展到极限,到后来的微积分的提出。然就算牛顿和莱布尼茨提出了微积分,但微积分的概念尚模糊不清,在牛顿和莱布尼茨之后,后续经过一个多世纪的发展,诸多学者的努力,才真正清晰了微积分的概念。

也就是说,从无穷小到极限,再到微积分定义的真正确立,经历了几代人几个世纪的努力,而课本上所呈现的永远只是冰山一角。

1.2、导数

。若

。若 在点

在点 的某个邻域内有定义,则当自变量

的某个邻域内有定义,则当自变量 在

在 处取得增量

处取得增量 (点

(点 仍在该邻域内)时,相应地函数

仍在该邻域内)时,相应地函数 取得增量

取得增量 ;如果

;如果 与

与 之比当

之比当 时的极限存在,则称函数

时的极限存在,则称函数 在点

在点 处可导,并称这个极限为函数

处可导,并称这个极限为函数 在点

在点 处的导数,记为

处的导数,记为 。

。 也可记为:

1.3、微分

在某区间

在某区间 内有定义。对于

内有定义。对于 内一点

内一点 ,当

,当 变动到附近的

变动到附近的 (

( 也在此区间内)时。如果函数的增量

也在此区间内)时。如果函数的增量 可表示为

可表示为 (其中

(其中 是不依赖于

是不依赖于 的常数),而

的常数),而 是比

是比 高阶的无穷小,那么称函数

高阶的无穷小,那么称函数 在点

在点 是可微的,且

是可微的,且 称作函数在点

称作函数在点 相应于自变量增量

相应于自变量增量 的微分,记作

的微分,记作 ,即

,即 ,

, 是

是 的线性主部。通常把自变量

的线性主部。通常把自变量 的增量

的增量 称为自变量的微分,记作

称为自变量的微分,记作 ,即

,即 。

。  的基础上加个后缀

的基础上加个后缀 ,即为:

,即为: 。

。1.4、积分

的不定积分,也称为原函数或反导数,是一个导数等于

的不定积分,也称为原函数或反导数,是一个导数等于 的函数

的函数 ,即

,即  ,在一个实数区间

,在一个实数区间 上的定积分:

上的定积分:

使下式成立:

使下式成立:

,由于

,由于 是

是 的一个原函数,所以

的一个原函数,所以 。

。

1.5、偏导数

定义 设函数z = f(x,y)在点(x0,y0)的某一邻域内有定义,当y固定在y0而x在x0处有增量

时,相应地函数有增量

时,相应地函数有增量 ,

, 。类似的,二元函数对y求偏导,则把x当做常量。

。类似的,二元函数对y求偏导,则把x当做常量。

第二节、离散.连续.多维随机变量及其分布

2.1、几个基本概念点

(一)样本空间

定义:随机试验E的所有结果构成的集合称为E的 样本空间,记为S={e},

称S中的元素e为样本点,一个元素的单点集称为基本事件.

(二)条件概率

- 条件概率就是事件A在另外一个事件B已经发生条件下的发生概率。条件概率表示为P(A|B),读作“在B条件下A的概率”。

- 联合概率表示两个事件共同发生的概率。A与B的联合概率表示为

或者

。

- 边缘概率是某个事件发生的概率。边缘概率是这样得到的:在联合概率中,把最终结果中不需要的那些事件合并成其事件的全概率而消失(对离散随机变量用求和得全概率,对连续随机变量用积分得全概率)。这称为边缘化(marginalization)。A的边缘概率表示为P(A),B的边缘概率表示为P(B)。

。

(三)全概率公式和贝叶斯公式

1、全概率公式

。但后者在连续情况下仍然成立:此处N是任意随机变量。这个公式还可以表达为:”A的先验概率等于A的后验概率的先验期望值。

。但后者在连续情况下仍然成立:此处N是任意随机变量。这个公式还可以表达为:”A的先验概率等于A的后验概率的先验期望值。 2、贝叶斯公式

通常,事件A在事件B(发生)的条件下的概率,与事件B在事件A的条件下的概率是不一样的;然而,这两者是有确定的关系,贝叶斯定理就是这种关系的陈述。

此篇blog第二部分所述“

据维基百科上的介绍,贝叶斯定理实际上是关于随机事件A和B的条件概率和边缘概率的一则定理。

- P(A)是A的先验概率或边缘概率。之所以称为”先验”是因為它不考虑任何B方面的因素。

- P(A|B)是已知B发生后A的条件概率(直白来讲,就是先有B而后=>才有A),也由于得自B的取值而被称作A的后验概率。

- P(B|A)是已知A发生后B的条件概率(直白来讲,就是先有A而后=>才有B),也由于得自A的取值而被称作B的后验概率。

- P(B)是B的先验概率或边缘概率,也作标准化常量(normalized constant)。

按这些术语,Bayes定理可表述为:后验概率 = (相似度*先验概率)/标准化常量,也就是說,后验概率与先验概率和相似度的乘积成正比。另外,比例P(B|A)/P(B)也有时被称作标准相似度(standardised likelihood),Bayes定理可表述为:后验概率 = 标准相似度*先验概率。”

根据条件概率的定义,在事件B发生的条件下事件A发生的概率是

同样地,在事件A发生的条件下事件B发生的概率

整理与合并这两个方程式,我们可以找到

这个引理有时称作概率乘法规则。上式两边同除以P(B),若P(B)是非零的,我们可以得到贝叶斯 定理:

2.2、随机变量及其分布

2.2.1、何谓随机变量

何谓随机变量?即给定样本空间

的取值是有限的或者是可数无穷尽的值,则称

的取值是有限的或者是可数无穷尽的值,则称 为离散随机变量(

为离散随机变量(用白话说,此类随机变量是间断的)。

由全部实数或者由一部分区间组成,则称

由全部实数或者由一部分区间组成,则称 为连续随机变量,连续随机变量的值是不可数及无穷尽的(

为连续随机变量,连续随机变量的值是不可数及无穷尽的(用白话说,此类随机变量是连续的,不间断的):

也就是说,随机变量分为离散型随机变量,和连续型随机变量,当要求随机变量的概率分布的时候,要分别处理之,如:

- 针对离散型随机变量而言,一般以加法的形式处理其概率和;

- 而针对连续型随机变量而言,一般以积分形式求其概率和。

再换言之,对离散随机变量用求和得全概率,对连续随机变量用积分得全概率。这点包括在第4节中相关期望.方差.协方差等概念会反复用到,望读者注意之。

2.2.2、离散型随机变量的定义

(一)(0-1)分布

(二)、二项分布

(三)、泊松分布(Poisson分布)

,

, 趋于无穷时

趋于无穷时 的极限:

的极限:

2.2.3、随机变量分布函数定义的引出

- 对于离散型随机变量而言,其所有可能的取值可以一一列举出来,

- 可对于非离散型随机变量,即连续型随机变量X而言,其所有可能的值则无法一一列举出来,

事实上,只有因为连续,所以才可导,所以才可积分,这些东西都是相通的。当然了,连续不一定可导,但可导一定连续)?

2.2.4、连续型随机变量及其概率密度

;

;

(针对上述第3点性质,我重点说明下:

- 在上文第1.4节中,有此牛顿-莱布尼茨公式:如果函数F (x)是连续函数f(x)在区间[a, b]上的一个原函数, 则

;

- 在上文2.2.3节,连续随机变量X 而言,对于任意实数a,b(a<b),有P{a<X<=b} = P{X <=b} – P{X <= a} = F(b) – F(a);

故结合上述两点,便可得出上述性质3)

在一点

在一点 上连续,那么累积分布函数可导,并且它的导数:

上连续,那么累积分布函数可导,并且它的导数: 。如下图所示:

。如下图所示:

服从一个位置参数为

服从一个位置参数为 、尺度参数为

、尺度参数为 的概率分布,记为:

的概率分布,记为:

,决定了分布的位置;其方差

,决定了分布的位置;其方差 的开平方,即标准差

的开平方,即标准差 等于尺度参数,决定了分布的幅度。正态分布的概率密度函数曲线呈钟形,因此人们又经常称之为钟形曲线。它有以下几点性质,如下图所示:

等于尺度参数,决定了分布的幅度。正态分布的概率密度函数曲线呈钟形,因此人们又经常称之为钟形曲线。它有以下几点性质,如下图所示:

,改变位置参数

,改变位置参数 的大小时,f(x)图形的形状不变,只是沿着x轴作平移变换,如下图所示:

的大小时,f(x)图形的形状不变,只是沿着x轴作平移变换,如下图所示:

,改变尺度参数

,改变尺度参数 的大小时,f(x)图形的对称轴不变,形状在改变,越小,图形越高越瘦,越大,图形越矮越胖。如下图所示:

的大小时,f(x)图形的对称轴不变,形状在改变,越小,图形越高越瘦,越大,图形越矮越胖。如下图所示:

, 尺度参数

, 尺度参数 的正态分布,记为:

的正态分布,记为:

来源:大嘴巴漫谈数据挖掘):

2.2.5、各种分布的比较

摘自盛骤版的概率论与数理统计一书后的附录中):

第三节、从数学期望、方差、协方差到中心极限定理

3.1、数学期望、方差、协方差

依照上文第二节相关内容也可以得出),一种为离散型随机变量的期望值,一种为连续型随机变量的期望值。

- 一个离散性随机变量的期望值(或数学期望、或均值,亦简称期望)是试验中每次可能结果的概率乘以其结果的总和。换句话说,期望值是随机试验在同样的机会下重复多次的结果计算出的等同“期望”的平均值。

绝对收敛,那么期望值E[X]是一个无限数列的和:

绝对收敛,那么期望值E[X]是一个无限数列的和:

- 而对于一个连续型随机变量来说,如果X的概率分布存在一个相应的概率密度函数f(x),若积分

绝对收敛,那么X 的期望值可以计算为:

3.1.2、方差与标准差

是随机变量X的期望值(平均数) 设为服从分布

是随机变量X的期望值(平均数) 设为服从分布 的随机变量,则称

的随机变量,则称 为随机变量或者分布的方差:

为随机变量或者分布的方差:

为

为 具有相同概率,则可用上述公式计算标准差。

具有相同概率,则可用上述公式计算标准差。

当中取出一样本数值组合

当中取出一样本数值组合 ,进而,我们可以定义其样本标准差为:

,进而,我们可以定义其样本标准差为:

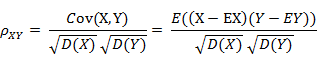

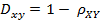

如上篇kd树blog所述相关系数 ( Correlation coefficient )的定义是:

(其中,E为数学期望或均值,D为方差,D开根号为标准差,E{ [X-E(X)] [Y-E(Y)]}称为随机变量X与Y的协方差,记为Cov(X,Y),即Cov(X,Y) = E{ [X-E(X)] [Y-E(Y)]},而两个变量之间的协方差和标准差的商则称为随机变量X与Y的相关系数,记为

相关系数衡量随机变量X与Y相关程度的一种方法,相关系数的取值范围是[-1,1]。相关系数的绝对值越大,则表明X与Y相关度越高。当X与Y线性相关时,相关系数取值为1(正线性相关)或-1(负线性相关)。

具体的,如果有两个变量:X、Y,最终计算出的相关系数的含义可以有如下理解:

- 当相关系数为0时,X和Y两变量无关系。

- 当X的值增大(减小),Y值增大(减小),两个变量为正相关,相关系数在0.00与1.00之间。

- 当X的值增大(减小),Y值减小(增大),两个变量为负相关,相关系数在-1.00与0.00之间。

根据相关系数,相关距离可以定义为:

kd树blog第一部分内容。

来源:大嘴巴满谈数据挖掘):

3.1.4、协方差矩阵与主成成分分析

协方差矩阵

由上,我们已经知道:协方差是衡量两个随机变量的相关程度。且随机变量

故根据已知的样本值可以得到协方差的估计值如下:

可以进一步地简化为:

如此,便引出了所谓的协方差矩阵:

主成成分分析

尽管从上面看来,协方差矩阵貌似很简单,可它却是很多领域里的非常有力的工具。它能导出一个变换矩阵,这个矩阵能使数据完全去相关(decorrelation)。从不同的角度看,也就是说能够找出一组最佳的基以紧凑的方式来表达数据。这个方法在统计学中被称为主成分分析(principal components analysis,简称PCA),在图像处理中称为Karhunen-Loève 变换(KL-变换)。

根据wikipedia上的介绍,主成分分析PCA由卡尔·皮尔逊于1901年发明,用于分析数据及建立数理模型。其方法主要是通过对协方差矩阵进行特征分解,以得出数据的主成分(即特征矢量)与它们的权值(即特征值)。PCA是最简单的以特征量分析多元统计分布的方法。其结果可以理解为对原数据中的方差做出解释:哪一个方向上的数据值对方差的影响最大。

然为何要使得变换后的数据有着最大的方差呢?我们知道,方差的大小描述的是一个变量的信息量,我们在讲一个东西的稳定性的时候,往往说要减小方差,如果一个模型的方差很大,那就说明模型不稳定了。但是对于我们用于机器学习的数据(主要是训练数据),方差大才有意义,不然输入的数据都是同一个点,那方差就为0了,这样输入的多个数据就等同于一个数据了。

简而言之,主成分分析PCA,留下主成分,剔除噪音,是一种降维方法,限高斯分布,n维眏射到k维,

- 减均值,

- 求特征协方差矩阵,

- 求协方差的特征值和特征向量,

- 取最大的k个特征值所对应的特征向量组成特征向量矩阵,

- 投影数据=原始样本矩阵x特征向量矩阵。其依据为最大方差,最小平方误差或坐标轴相关度理论,及矩阵奇异值分解SVD(即SVD给PCA提供了另一种解释)。

也就是说,

高斯是0均值,其方差定义了信噪比,所以

PCA是在对角化低维表示的协方差矩阵

,故某一个角度而言,只需要理解方差、均值和协方差的物理意义,PCA就很清晰了。

再换言之,PCA提供了一种降低数据维度的有效办法;如果分析者在原数据中除掉最小的特征值所对应的成分,那么所得的低维度数据必定是最优化的(也即,这样降低维度必定是失去讯息最少的方法)。主成分分析在分析复杂数据时尤为有用,比如人脸识别。

3.2、中心极限定理

3.2.1、独立同分布的中心极限定理

3.2.2、棣莫弗-拉普拉斯中心极限定理

此外,据wikipedia上的介绍,包括上面介绍的棣莫弗-拉普拉斯定理在内,历史上前后发展了三个相关的中心极限定理,它们得出的结论及内容分别是:

- 棣莫弗-拉普拉斯(de Movire – Laplace)定理是中心极限定理的最初版本,讨论了服从二项分布的随机变量序列。

其内容为:若是n次伯努利实验中事件A出现的次数,

,则对任意有限区间

:

(i)当及

时,一致地有

(ii)当时,一致地有,

,其中

。

它指出,

参数为n, p的二项分布以np为均值、np(1-p)为方差的正态分布为极限。

- 林德伯格-列维(Lindeberg-Levy)定理,是棣莫佛-拉普拉斯定理的扩展,讨论独立同分布随机变量序列的中心极限定理。

其内容为:设随机变量独立同分布, 且具有有限的数学期望和方差

,

。

记,

,则

,其中

是标准正态分布的分布函数。

独立同分布、且数学期望和方差有限的随机变量序列的标准化和以标准正态分布为极限。

- 林德伯格-费勒定理,是中心极限定理的高级形式,是对林德伯格-列维定理的扩展,讨论独立,但不同分布的情况下的随机变量和。

其内容为:记随机变量序列(

独立但不一定同分布,

且有有限方差)部分和为

记

,

如果对每个

,序列满足

则称它满足林德伯格(Lindeberg)条件。

满足此条件的序列趋向于正态分布,即

与之相关的是李雅普诺夫(Lyapunov)条件:

满足李雅普诺夫条件的序列必满足林德伯格条件。

它表明,满足一定条件时,独立,但不同分布的随机变量序列的标准化和依然以标准正态分布为极限。

3.2.3、历史

令 Sn=X1+X2+⋯+Xn, 那么

定理Laplace,1812]设 ei(i=1,⋯n)为独立同分布的测量误差,具有均值μ和方差σ2。如果λ1,⋯,λn为常数,a>0,则有

Lindeberg-Levy中心极限定理] 设X1,⋯,Xn独立同分布,且具有有限的均值μ和方差σ2,则在n→∞时,有

如上所述,中心极限定理的历史可大致概括为:

- 中心极限定理理的第一版被法国数学家棣莫弗发现,他在1733年发表的卓越论文中使用正态分布去估计大量抛掷硬币出现正面次数的分布;

- 1812年,法国数学家拉普拉斯在其巨著 Théorie Analytique des Probabilités中扩展了棣莫弗的理论,指出二项分布可用正态分布逼近;

- 1901年,俄国数学家李雅普诺夫用更普通的随机变量定义中心极限定理并在数学上进行了精确的证明。

如今,中心极限定理被认为是(非正式地)概率论中的首席定理。

第四节、从数理统计简史中看正态分布的历史由来

本节将结合数理统计学简史一书,从早期概率论的发展、棣莫弗的二项概率逼近讲到贝叶斯方法、最小二乘法、误差与正态分布等问题,有详有略,其中,重点阐述正态分布的历史由来。

4.1、正态分布的定义

4.2、早期概率论:从萌芽到推测术

4.2.1、惠更新的三个关于期望的定理

。

。 - 公理:每个公平博弈的参与者愿意拿出经过计算的公平赌注冒险而不愿拿出更多的数量。即赌徒愿意押的赌注不大于其获得赌金的数学期望数。

对这一公理至今仍有争议。所谓公平赌注的数额并不清楚,它受许多因素的影响。但惠更斯由此所得关于数学期望的3 个命题具有重要意义。这是数学期望第一次被提出,由于当时概率的概念还不明确,后被拉普拉斯( Laplace ,1749 —1827) 用数学期望来定义古典概率。在概率论的现代表述中,概率是基本概念,数学期望则是二级概念,但在历史发展过程中却顺序相反。

关于数学期望的三个命题为:

- 命题1 若某人在赌博中以等概率1/2获得赌金a元、b元,则其数学期望值为:a*1/2+b*1/2,即为( a + b)/2;

- 命题2 若某人在赌博中以等概率1/3获得赌金a 、b 元和c元 ,则其数学期望值为( a + b + c)/3元;

- 命题3 若某人在赌博中以概率p 和q ( p ≥0 , q ≥0 , p + q = 1) 获得赌金a元、b元 ,则获得赌金的数学期望值为p*a + q*b 元。

这些今天看来都可作为数学期望定义,不准确的说,数学期望来源于取平均值。同时,根据上述惠更斯的3个命题不难证明:若某人在赌博中分别以概率p1…,pk(p1+..+pk=1)分别赢得a1,..ak元,那么其期望为p1*a1+…+pk*ak,这与本文第一节中关于离散型随机变量的期望的定义完全一致(

各值与各值概率乘积之和)。

C,(C为常量)。我当时的物理老师叫刘新见,记得他在讲伯努利方程的时候,曾开玩笑说,“’伯努利‘好记好记,‘白努力‘嘛”。

。事件X在每次试验中发生的概率为P。则对任意正数,下式成立:

。事件X在每次试验中发生的概率为P。则对任意正数,下式成立:

ε>0和

η>0,取足够大的抽取次数N,使得事件

的概率不超过

的概率不超过η,这意思是

,表面估计误差未达到制定的接近程度

,表面估计误差未达到制定的接近程度η。

(N趋于无穷大)

(N趋于无穷大)

4.3、棣莫弗的二项概率逼近

(赌博贡献很大丫哈)。有一天一个哥们,也许是个赌徒,向棣莫弗提了一个和赌博相关的一个问题:A,B两人在赌场里赌博,A,B各自的获胜概率是p和q=1−p,赌n局,若A赢的局数X>np,则A付给赌场X−np元,否则B付给赌场np−X元。问赌场挣钱的期望值是多少?按定义可知,此期望值为:

计算不易,故棣莫弗想找到一个更方便于计算的近似公式。

计算不易,故棣莫弗想找到一个更方便于计算的近似公式。

(其中,m= N/2)

结合后,便有了:

结合后,便有了:

rickjin的式子转化下:

正态分布的概率密度(函数)在上述的积分公式中出现了!于此,我们得到了一个结论,原来二项分布的极限分布便是正态分布。与此同时,还引出了统计学史上占据重要地位的中心极限定理。

棣莫弗-拉普拉斯定理」

:设随机变量Xn(n=1,2…)服从参数为p的二项分布,则对任意的x,恒有下式成立:

也就是上文3.2节中所讲的中心极限定理的一般形式):

Lindeberg-Levy中心极限定理」设X1,⋯,Xn独立同分布,且具有有限的均值μ和方差σ2,则在n→∞时,有

当样本量趋于无穷时,一系列重要统计量的极限分布如二项分布,都有正态分布的形式,也就是说,这也构成了数理统计学中大样本方法的基础。

|的概率可任意接近于1,由于

|的概率可任意接近于1,由于 ,故对于任意给定的

,故对于任意给定的ε>0, 有下式成立:

注:上面讨论的是对称情况,即p=1/2的情况)。

、和

、和 的的意义都不告诉我们(

的的意义都不告诉我们(位置参数

即为数学期望,尺度参数为

即为数学期望,尺度参数为 即为方差,换句话说,有了期望

即为方差,换句话说,有了期望 和方差

和方差 ,即可确定正态分布)。

,即可确定正态分布)。

通过阅读下文4.6节你将知道,高斯引入正太误差理论,才成就了正态分布,反过来,拉普拉斯在高斯的工作之上用中心极限定理论证了正态分布)。如

rickjin所言:’‘学家研究数学问题的进程很少是按照我们数学课本的安排顺序推进的,现代的数学课本都是按照数学内在的逻辑进行组织编排的,虽然逻辑结构上严谨优美,却把数学问题研究的历史痕迹抹得一干二净。DNA双螺旋结构的发现者之一James Waston在他的名著《DNA双螺旋》序言中说:‘科学的发现很少会像门外汉所想象的一样,按照直接了当合乎逻辑的方式进行的。’ ’‘

4.4、贝叶斯方法

An essay towards solving a problem in the doctrine of chances(机遇理论中一个问题的解)的遗作,此文在他发表后很长一段时间起,在学术界没有引起什么反响,直到20世纪以来,突然受到人们的重视,此文也因此成为贝叶斯学派最初的奠基石(又一个梵高式的人物)。

2.1小节已对其做简要介绍,再者,此文

从决策树学习谈到贝叶斯分类算法、EM、HMM第二部分也详细介绍过了贝叶斯方法,故为本文篇幅所限,不再做过多描述。

4.5、最小二乘法,数据分析的瑞士军刀

- 纵的方面指平均值本身,诸如伯努利及其后众多的大数定律,棣莫弗-拉普拉斯中心极限定理,高斯的正太误差理论,这些在很大程度上都可以视为对算术平均的研究成果,甚至到方差,标准差等概念也是由平均值发展而来;

- 横的方面中最为典型的就是此最小二乘法。

当然,取平方和作为目标函数知识众多可取的方法之一,例如也可以取误差4次方或绝对值和,取平方和是人类千百年实践中被证实行之有效的方法,因此被普遍采用)。

说实话,最小二乘法试图解决的是误差最小的问题,而正态分布则是试图寻找误差分布规律的问题,无论是最小二乘法,还是正态分布的研究工作,至始至终都围绕着误差进行)。

- 土星和木星是太阳系中的大行星,由于相互吸引对各自的运动轨道产生了影响,许多大数学家,包括欧拉和拉普拉斯都在基于长期积累的天文观测数据计算土星和木星的运行轨道。

- 勒让德承担了一个政府给的重要任务,测量通过巴黎的子午线的长度。

- 海上航行经纬度的定位。主要是通过对恒星和月面上的一些定点的观测来确定经纬度。

以上求解线性矛盾方程的问题在现在的本科生看来都不困难,就是统计学中的线性回归问题,直接用最小二乘法就解决了,可是即便如欧拉、拉普拉斯这些数学大牛,当时也未能对这些问题提出有效的解决方案。可见在科学研究中,要想在观念上有所突破并不容易。有效的最小二乘法是勒让德在1805年发表的,基本思想就是认为

测量中有误差,所以所有方程的累积误差为:

注:勒让德时期的最小二乘法还只是作为一个处理测量数据的代数方法来讨论的,实际上与统计学并无多大关联,只有建立在了测量误差分布的概率理论之后,这个方法才足以成为一个统计学方法。尽管拉普拉斯用他的中心极限定理定理也可以推导出最小二乘法,但无论是之前的棣莫弗,还是当时的勒让德,还是拉普拉斯,此时他们这些研究成果都还只是一个数学表达式而非概率分布)。

后续更是导出了误差服从正态分布的结论),最后,1837年,统计学家们正式确立误差服从正态分布,自此,人们方才真正确信:观测值与理论值的误差服从正态分布。

4.6、误差分布曲线的建立

测量中的随机误差应该服从怎样的概率分布?算术平均的优良性和误差的分布有怎样的密切联系?

- 误差是对称分布的分布在0的两侧;

- 大的误差出现频率低,小的误差出现频率高。

4.6.1、辛普森的工作

- 设真值为θ,而

为n次测量值,现在用测量值

去估计真值

,那么每次测量的误差为

,

- 但若用算术平均

去估计θ呢,则其误差为

。

相比于

相比于 取小值的机会更大。辛普森的这个工作很粗糙,但是这是第一次在一个特定情况下,从概率论的角度严格证明了算术平均的优良性。

取小值的机会更大。辛普森的这个工作很粗糙,但是这是第一次在一个特定情况下,从概率论的角度严格证明了算术平均的优良性。

4.6.2、拉普拉斯的工作

在1772-1774年间,拉普拉斯也加入到了寻找误差分布函数的队伍中。与辛普森不同,拉普拉斯不是先假定一种误差分后去设法证明平均值的优良性,而是直接射向应该去怎么的分布为误差分布,以及在确定了误差分布之后,如何根据观测值

密度函数f(x)满足如下性质:

,C>0且为常数,由于

,C>0且为常数,由于 ,得

,得 。故当x<0,结合概率密度的性质之一(

。故当x<0,结合概率密度的性质之一(参看上文2.2.4节):

,解得c=m/2。

,解得c=m/2。

密度,拉普拉斯开始考虑如何基于测量的结果去估计未知参数的值,即用什么方法通过观测值

去估计真值

去估计真值 呢?要知道咱们现今所熟知的所谓点估计方法、矩估计方法,包括所谓的极大似然估计法之类的,当时可是都还没有发明。

呢?要知道咱们现今所熟知的所谓点估计方法、矩估计方法,包括所谓的极大似然估计法之类的,当时可是都还没有发明。

4.6.3、高斯导出误差正态分布

正太误差”的理论之后,它正太理论才得以“概率分布“的身份进入科学殿堂,从而引起人们的重视。

跟上面一样,还是设真值为

,而

,而 为n次独立测量值,每次测量的误差为

为n次独立测量值,每次测量的误差为 ,假设误差ei的密度函数为f(e),则测量值的联合概率为n个误差的联合概率,记为

,假设误差ei的密度函数为f(e),则测量值的联合概率为n个误差的联合概率,记为第一个创新的想法便是:高斯并没有像前面的拉普拉斯那样采用贝叶斯的推理方式,而是直接取L(θ)达到最小值的

作为

作为 的估计值,这也恰恰是他解决此问题采用的创新方法,即

的估计值,这也恰恰是他解决此问题采用的创新方法,即高斯的

第二点创新的想法是:他把整个问题的思考模式倒过来,既然千百年来大家都认为算术平均是一个好的估计,那么就直接先承认算术平均就是极大似然估计(换言之,极大似然估计导出的就应该是算术平均),所以高斯猜测:

以迎合这一点。即寻找这样的概率分布函数

以迎合这一点。即寻找这样的概率分布函数 ,使得极大似然估计正好是算术平均

,使得极大似然估计正好是算术平均 。通过应用数学技巧求解这个函数f,高斯证明了所有的概率密度函数中,唯一满足这个性质的就是(记为

。通过应用数学技巧求解这个函数f,高斯证明了所有的概率密度函数中,唯一满足这个性质的就是(记为(11)式):

,就这样,误差的正态分布就被高斯给推导出来了!

,就这样,误差的正态分布就被高斯给推导出来了!

摘自数理统计学简史第127页注2,图中开头所说的高斯的第2原则就是上面所讲的高斯的第二点创新的想法,而下图最后所说的(11)式就是上面推导出来的概率密度函数):

,则结合高斯的第一个创新方法:极大似然估计及上述的概率密度,(e1,⋯,en)的联合概率分布为

,则结合高斯的第一个创新方法:极大似然估计及上述的概率密度,(e1,⋯,en)的联合概率分布为 取最小值,这正好就是最小二乘法的要求。

取最小值,这正好就是最小二乘法的要求。

,借此表明在高斯的一切科学贡献中,尤以此”正太分布“的确立对人类文明的进程影响最大。

,借此表明在高斯的一切科学贡献中,尤以此”正太分布“的确立对人类文明的进程影响最大。

- 如你所见,相比于勒让德1805给出的最小二乘法描述,高斯基于误差正态分布的最小二乘理论显然更高一筹,高斯的工作中既提出了极大似然估计的思想,又解决了误差的概率密度分布的问题,由此我们可以对误差大小的影响进行统计度量了。

- 但事情就完了么?没有。高斯设定了准则“最大似然估计应该导出优良的算术平均”,并导出了误差服从正态分布,推导的形式上非常简洁优美。但是高斯给的准则在逻辑上并不足以让人完全信服,因为算术平均的优良性当时更多的是一个经验直觉,缺乏严格的理论支持。高斯的推导存在循环论证的味道:因为算术平均是优良的,推出误差必须服从正态分布;反过来,又基于正态分布推导出最小二乘和算术平均,来说明最小二乘法和算术平均的优良性,故其中无论正反论点都必须借助另一方论点作为其出发点,可是算术平均到并没有自行成立的理由。

第二点创新的想法“

他把整个问题的思考模式倒过来:既然千百年来大家都认为算术平均是一个好的估计,那么就直接先承认算术平均就是极大似然估计(换言之,极大似然估计导出的就应该是算术平均)”存在着隐患,而这一隐患的消除又还得靠咱们的老朋友拉普拉斯解决了。

换言之,按中心极限定理来说,正态分布是由大量的但每一个作用较小的因素的作用导致而成)。而20世纪中心极限定理的进一步发展,也给这个解释提供了更多的理论支持。

4.6.4、正态分布的时间简史

- 1705年,伯努力的著作推测术问世,提出伯努利大数定律;

- 1730-1733年,棣莫弗从二项分布逼近得到正态密度函数,首次提出中心极限定理;

- 1780年,拉普拉斯建立中心极限定理的一般形成;

- 1805年,勒让德发明最小二乘法;

- 1809年,高斯引入正态误差理论,不但补充了最小二乘法,而且首次导出正态分布;

- 1811年,拉普拉斯利用中心极限定理论证正态分布;

- 1837年,海根提出元误差学说,自此之后,逐步正式确立误差服从正态分布。

当然,最后拉普拉斯用中心极限定理论证了正态分布),能了解这些历史,想想,都觉得是一件无比激动的事情。所以,我们切勿以为概率论与数理统计的教材上是先讲的正态分布,而后才讲的中心极限定理,而颠倒原有历史的发明演进过程。

第五节、论道正态,正态分布的4大数学推导

因为任何时代,大部分人的研究所得都不过是基于前人的研究成果,前人所做的是开创性工作,而这往往是最艰难最有价值的,他们被称为真正的先驱。牛顿也曾说过,他不过是站在巨人的肩上。你,我则更是如此)。

注:本节主要整编自rickjin写的”正态分布的前后今生”系列」

误差分布导出的极大似然估计 = 算术平均值

,而

,而 为

为 次独立测量值,每次测量的误差为

次独立测量值,每次测量的误差为 ,假设误差

,假设误差 的密度函数为

的密度函数为 ,则测量值的联合概率为n个误差的联合概率,记为

,则测量值的联合概率为n个误差的联合概率,记为 ,由上式可以得到

,由上式可以得到 ,把解带入上式,可以得到

,把解带入上式,可以得到 ,有

,有 ,并且

,并且 是任意的,由此得到:

是任意的,由此得到: .再在(6)式中取

.再在(6)式中取 ,并且要求

,并且要求 ,且

,且 ,则有

,则有 ,并且

,并且 而满足上式的唯一的连续函数就是

而满足上式的唯一的连续函数就是 ,从而进一步可以求解出

,从而进一步可以求解出 是概率分布函数,把

是概率分布函数,把 正规化一下就得到正态分布密度函数

正规化一下就得到正态分布密度函数

5.2、Herschel(1850)和麦克斯韦(1860)的推导

第二条小径是天文学家John Hershcel和物理学家麦克斯韦(Maxwell)发现的。1850年,天文学家Herschel在对星星的位置进行测量的时候,需要考虑二维的误差分布,为了推导这个误差的概率密度分布f(x,y),Herschel设置了两个准则:

- x轴和y轴的误差是相互独立的,即误差的概率在正交的方向上相互独立;

- 误差的概率分布在空间上具有旋转对称性,即误差的概率分布和角度没有关系。

应该具有如下形式

应该具有如下形式 ,有

,有 具有旋转对称性,也就是应该和

具有旋转对称性,也就是应该和 无关,所以

无关,所以 ,综合以上,我们可以得到

,综合以上,我们可以得到 ,得到

,得到 ,所以上式可以转换为

,所以上式可以转换为 ,则有

,则有 ,从而可以得到

,从而可以得到 的一般形式如下

的一般形式如下 就是正态分布

就是正态分布 ,而

,而 就是标准二维正态分布函数。

就是标准二维正态分布函数。 。这就是著名的麦克斯韦分子速率分布定律。大家还记得我们在普通物理中学过的麦克斯韦-波尔兹曼气体速率分布定律吗?

。这就是著名的麦克斯韦分子速率分布定律。大家还记得我们在普通物理中学过的麦克斯韦-波尔兹曼气体速率分布定律吗? 所以这个分布其实是三个正态分布的乘积。你的物理老师是否告诉过你其实这个分布就是三维正态分布?反正我是一直不知道,直到今年才明白。

Herschel-Maxwell推导的神妙之处在于,没有利用任何概率论的知识,只是基于空间几何的不变性,就推导出了正态分布。美国诺贝尔物理学奖得主费曼(Feymann)每次看到一个有

5.3、Landon的推导(1941)

第三条道是一位电气工程师,Vernon D. Landon 给出的。1941年,Landon 研究通信电路中的噪声电压,通过分析经验数据他发现噪声电压的分布模式很相似,不同的是分布的层级,而这个层级可以使用方差

- 随机噪声具有稳定的分布模式

- 累加一个微小的随机噪声,不改变其稳定的分布模式,只改变分布的层级(用方差度量)

用数学的语言描述:如果

.现在我们来推导函数

.现在我们来推导函数 应该长成啥样。按照两个随机变量和的分布的计算方式,

应该长成啥样。按照两个随机变量和的分布的计算方式, 的分布函数将是

的分布函数将是 的分布函数和

的分布函数和 的分布函数的卷积,即有

的分布函数的卷积,即有 在x′处做泰勒级数展开(为了方便,展开后把自变量由x′替换为x),上式可以展开为

在x′处做泰勒级数展开(为了方便,展开后把自变量由x′替换为x),上式可以展开为 ,则有

,则有 ,我们认为他取正值或者负值是对称的,所以

,我们认为他取正值或者负值是对称的,所以 。所以有

。所以有

(8)

增加为

增加为 ,所以按照Landon的分布函数模式不变的假设,新的噪声电压的分布函数应该为。把

,所以按照Landon的分布函数模式不变的假设,新的噪声电压的分布函数应该为。把 在

在 处做泰勒级数展开,得到

处做泰勒级数展开,得到

(9)

概率论沉思录作者E.T.Jaynes对于这个推导的评价很高,认为Landon的推导本质上给出了自然界的噪音形成的过程。他指出这个推导基本上就是中心极限定理的增量式版本,相比于中心极限定理来说,是一次性累加所有的因素,Landon的推导是每次在原有的分布上去累加一个微小的扰动。而在这个推导中,我们看到,正态分布具有相当好的稳定性;只要数据中正态的模式已经形成,他就容易继续保持正态分布,无论外部累加的随机噪声

是什么分布,正态分布就像一个黑洞一样把这个累加噪声吃掉。

是什么分布,正态分布就像一个黑洞一样把这个累加噪声吃掉。

5.4、正态分布和最大熵

还有一条小径是基于最大熵原理的,物理学家E.T.Jaynes在最大熵原理上有非常重要的贡献,他在《概率论沉思录》里面对这个方法有描述和证明,没有提到发现者,不过难以确认这条道的发现者是否是Jaynes本人。

熵在物理学中由来已久,信息论的创始人香农(Claude Elwood Shannon)把这个概念引入了信息论,读者中很多人可能都知道目前机器学习中有一个非常好用的分类算法叫最大熵分类器。要想把熵和最大熵的来龙去脉说清楚可不容易,不过这条道的风景是相当独特的,E.T.Jaynes对这条道也是偏爱有加。

对于一个概率分布

的均值

的均值 和方差

和方差 (给定均值和方差这个条件,也可以描述为给定一阶原点矩和二阶原点矩,这两个条件是等价的)则在所有满足这两个限制的概率分布中,熵最大的概率分布

(给定均值和方差这个条件,也可以描述为给定一阶原点矩和二阶原点矩,这两个条件是等价的)则在所有满足这两个限制的概率分布中,熵最大的概率分布 就是正态分布

就是正态分布 。

。这个结论的推导数学上稍微有点复杂,不过如果已经猜到了给定限制条件下最大熵的分布是正态分布,要证明这个猜测却是很简单的,证明的思路如下。

考虑两个概率分布

和

和 ,使用不等式

,使用不等式 ,得

,得

(

读者注意:经好友白石指正,上述等式,右边的第一项p(x)之后,1/p(x) 之前少画了个log符号

)

。

。对于

,在给定的均值

,在给定的均值 和方差

和方差 下,我们取

下,我们取 ,则可以得到

,则可以得到 的均值方差有如下限制:

的均值方差有如下限制: ,于是

,于是 的时候,上式可以取到等号,这就证明了结论。

的时候,上式可以取到等号,这就证明了结论。

E.T.Jaynes显然对正态分布具有这样的性质极为赞赏,因为这从信息论的角度证明了正态分布的优良性。而我们可以看到,正态分布熵的大小,取决于方差的大小。这也容易理解,因为正态分布的均值和密度函数的形状无关,正态分布的形状是由其方差决定的,而熵的大小反应概率分布中的信息量,显然和密度函数的形状相关。

Physicists believe that the Gaussian law has been proved in mathematics while mathematicians think that it was experimentally established in physics.

—Henri Poincaré

OK,虽然上文已经花了如此多的篇幅讲了那么多的概念,然事实上,在概率论与数理统计中,上文所讲的概念尚不到1/3,限于篇幅,还有诸多概念没有阐述完毕(这些知识将放于数据挖掘中所需的概率论与数理统计知识、下中介绍),如下图所示:

So,如上,之前微博上http://weibo.com/1580904460/z9htU9VzT 说要写的概率论与数理统计的科普blog、上部分已经初步整理完成(当然,后续一个星期之内会继续修补完善)。从前天晚上开始,连续写了两天,花了半身力气,文章若有任何问题,欢迎指正,尤能给出批评修订意见,则倍感荣幸,谢谢。.同时,但所有以上这些绝大部分都只是概率论与数理统计的基础知识,因此本文只能作个科普之效,若要深入学习,还是烦请读者朋友们阅读相关书籍,或加以动手实践。

参考文献及推荐阅读

- 高等数学第六版上下册,同济大学数学系编;

- 微积分概念发展史,[美] 卡尔·B·波耶 著,唐生 译;

- 概率论与数理统计,高教版,盛骤等编;

- 浙大版概率论与数理统计电子PPT课件;

- 数理统计学简史,陈希孺院士著;

(极力推荐上书,相信每一个学概率统计的朋友都有必要看一看,同时,此书也是正态分布的前后今生这一系列的主要参考) - rickjin,正态分布的前后今生:http://t.cn/zlH3Ygc ;

- 正态分布的前后今生系列集成版上:http://t.cn/zjJStYq,下:http://t.cn/zjoAtUQ;

- 大嘴巴漫谈数据挖掘:http://vdisk.weibo.com/s/bUbzJ;

- 误差论与最小平方法 & 数学传播,蔡聪明;

- 正态分布进入统计学的历史演化,吴江霞;

- Probability Theory & The Logic of Science (概率论沉思录),E.T. Jaynes 著;

- 手写数学公式编辑器:http://webdemo.visionobjects.com/equation.html?locale=zh_CN;

- wikipedia上标准差:http://zh.wikipedia.org/wiki/%E6%A0%87%E5%87%86%E5%B7%AE;

- 泊松分布与概率分布:http://zh.wikipedia.org/wiki/%E6%B3%8A%E6%9D%BE%E5%88%86%E4%BD%88;

- wikipedia上一堆概念;

- ….

今天的文章概率论与数理统计题目与答案详解_概率知识点归纳总结分享到此就结束了,感谢您的阅读。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌侵权/违法违规的内容, 请发送邮件至 举报,一经查实,本站将立刻删除。

如需转载请保留出处:https://bianchenghao.cn/74955.html

或者

或者 。

。

。

。

;

; ;

;

绝对收敛,那么X 的期望值可以计算为:

绝对收敛,那么X 的期望值可以计算为:

是对总体方差

是对总体方差 的无偏估计。

的无偏估计。  中分母为 n-1 是因为

中分母为 n-1 是因为 的自由度为n-1(

的自由度为n-1(

是n次伯努利实验中事件A出现的次数,

是n次伯努利实验中事件A出现的次数, ,则对任意有限区间

,则对任意有限区间 :

: 及

及 时,一致地有

时,一致地有

,其中

,其中 。

。 独立同分布, 且具有有限的数学期望和方差

独立同分布, 且具有有限的数学期望和方差 ,

, 。

。 ,

, ,则

,则 ,其中

,其中 是标准正态分布的分布函数。

是标准正态分布的分布函数。  (

( 且有有限方差)部分和为

且有有限方差)部分和为

,

,

,序列满足

,序列满足

(其中,m= N/2)

(其中,m= N/2)

为n次测量值,现在用测量值

为n次测量值,现在用测量值 去估计θ呢,则其误差为

去估计θ呢,则其误差为 。

。