TRAR:Routing the attention spans in transformer for visual question answering学习笔记

摘要

问题:如何动态调度全局和局部依赖关系建模

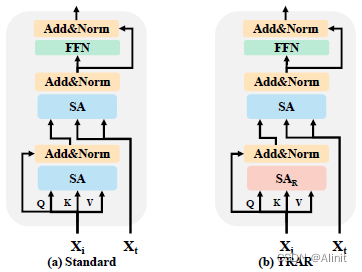

解决方法:基于实例的路由方案——TRAR。在TRAR中,每个视觉transformer层都配备了具有不同注意广度的路由模块。该模型可以根据前一步推理的输出动态选择相应的注意,以为每个实例制定最优路由路径。

introduction

image transformers:仅依赖SA中的全局依赖项建模难以满足需求

TRAR:实现了注意力的自动选择。

相关工作

动态神经网络:在推理过程中调整结构或参数以适应给定实例。

Transformer Routing

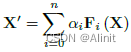

创建多分支网络结构,其中每层都配备不同设置的模块。X为最后一个推理步骤的特征,F为路由空间,n为特征个数,d为特征维度。下一个推理步骤的输出为:

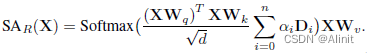

优化后:

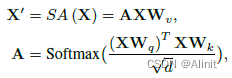

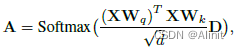

SA:

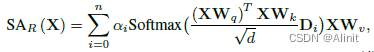

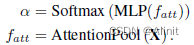

在TRAR中,每个视觉SA层都配备了一个路径控制器来预测路由选项的概率,即模块选择:

3. attention span(注意广度)

注意广度代表注意特征的接受域。

4. optimization

软路由

硬路由

5. network

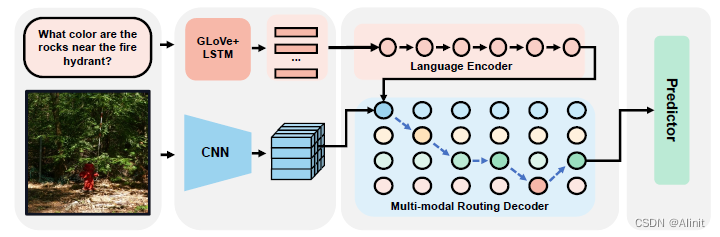

基于MCAN:将视觉SA模块替换为路由模块;在视觉和语言输出之后添加了两个attentionpooling层。

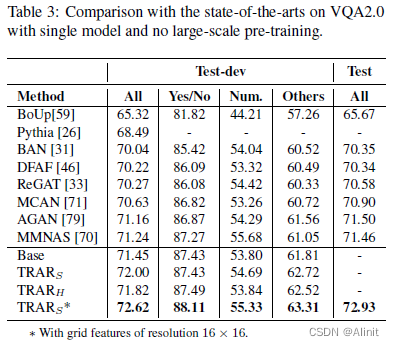

实验结果

今天的文章TRAR:Routing the attention spans in transformer for visual question answering学习笔记分享到此就结束了,感谢您的阅读。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌侵权/违法违规的内容, 请发送邮件至 举报,一经查实,本站将立刻删除。

如需转载请保留出处:https://bianchenghao.cn/83794.html