摘自:http://www.droneyee.cn/index.php?m=content&c=index&a=show&catid=82&id=36

看来有公司专门做这方面的

基于机器视觉无人平台自主导航避障系统

2019-04-02

-

产品概况

基于机器视觉无人平台自主导航避障系统,由北京卓翼智能科技有限公司与北航专业视觉导航团队联合打造,为各科研团队提供专业的无人平台机器视觉自主slam导航避障综合系统。

系统结合目前热门研究领域与研究方向,集无人机、无人车、双目视觉、机载AI视觉处理板卡于一体,形成全套的无人平台控制、通讯链路、视觉图像采集、图像识别、三维重建、定位解算等软件算法解决方案。为各科研团队、高校实验室提供硬件完善、功能齐全、开发环境完整、引领行业发展的全系统全功能开发测试环境,让各科研团队专注于slam导航避障算法研究。同时提供完整全套。

该系统提供全套的学科教学课程以及示例算法等,可快速展开相关课程设计,进行实际教学应用阶段。教科书级专业指导,永葆技术先进性。

- 整体方案

基于机器视觉无人平台自主导航避障系统组成架构:

基于机器视觉无人平台自主导航避障系统硬件由:开发工作站、无人机系统、机载双目视觉、机载图像处理板、VR三维显示等组成。

1、开发工作站

开发工作站是系统开发实验控制平台,主要用于双目视觉目标识别训练系统开发使用,为前期视觉系统控制平台,当在上位机中控制成功后即可以移植到TX2上进行实时自主控制。

2、无人机平台

无人机平台为专为基于机器视觉无人平台自主导航避障系统研发,具有飞行稳定。可通过串口、USB接口、网络通讯等多种通讯控制接口控制。可搭载超声波、激光、光流GPS、RTK等诸多传感器,适应多种应用环境与系统组合。

3、机载双目视觉系统

机载双目视觉系统包括双目相机、图传系统,双目相机固定于无人机底部,实时采集无人机巡视拍摄信息,发送至TX2机载处理板卡进行避障、跟随以及slam计算,或下传至地面图传接收机由开发工作站进行处理。机载双目视觉系统所使用的双目视觉相机为小觅双目视觉相机。

采用小觅双目摄像头标准版,双目帧在硬件上同步。以60Hz的频率采集图像,分辨率达到752×480像素,如图2.2为小觅双目标准摄像头。内置六轴IMU传感器,频率可以达到500Hz。双目基线120mm。采用全局快门,可实现两个摄像头的所有像元同时曝光。在高速移动的拍摄场景中,能有效降低图像畸变,提供更加精准的图像源。

-

系统特点

IMU 六轴传感器,IMU 与图像的同步精度高达0.05ms,为 SLAM 算法以及空间移动算法的研发提供数据校正;

IR 主动光,2颗IR主动光探测器发射的红外结构光,有效增强白墙和玻璃等物体的识别精度,适用于完全黑暗环境;

自动白平衡,精准调教的感光元件和镜头提供室内外感光的自适应和调节;

双目帧同步,提供两颗摄像头的硬件级帧同步,减小因图像不同步而导致的误差;

全局快门,实现每个像元的同时曝光有效降低高速移动拍摄时的图像畸变;

灰度镜头,提供清晰的黑白视觉研究图像源,分辨率为 752×480/60fps;

基线长度,120mm 的基线长度�适用绝大多数双目应用场景;

铝合金外壳,阳极铝加工外壳坚固耐用,采用标准 1/4”螺丝接口;

适用于双目SLAM研究,支持 VINS,OKVIS, ORB_SLAM2, VIORB 等多个开源 VSLAM 项目,并在 SDK 中提供样例;

CUDA 加速,提供基于 CUDA 加速的实时深度输出,使 GPU 能够解决复杂的计算问题;

丰富数据信息,通过 SDK 获取原始数据/校正双目图像、视差图像、实时深度图像、实时点云图像、IMU 数据等;

多平台SDK,SDK 适配 Windows、Linux、ROS、Mac、Android、TX1/2 等多种平台�并提供丰富工具。

4、Jetson TX2机载图像处理板

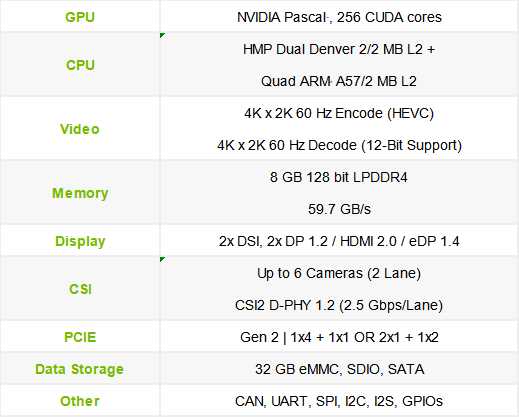

Jetson TX2是无人机平台搭载的深度学习目标检测算法运行板,为后期将图像处理移植于机载端进行处理,是深度学习、计算机视觉、图像处理和GPU计算的优秀系统,非常适合于无人机、自主机器人、移动医学成像等嵌入式系统应用。

Jetson TX2为2017年3月发布的新一代产品,集成256核NVIDIA Pascal GPU和一个6核64位的ARMv8处理器集群,拥有8GBLPDDR4 128位内存。ARMv8处理器集群包含一个双核NVIDIA Denver 2以及一个4核ARM Cortex-A57。Jetson TX2模块大小为50 x 87 mm,重量为85克,典型功耗为7.5瓦。

Jetson TX2基于16纳米NVIDIA Tegra “Parker” SOC,其效能比Jetson TX1提升2倍,性能表现超过了Intel Xeon服务器级CPU。

Jetson TX2提供两种运行模态:一种是MAX Q,能效比能达到最高,是上一代的TX1的2倍,功耗在7.5W以下;另一种是MAX P,性能可以做到最高,能效比同样可以做到前一代的2倍,功耗则在15W以下。

技术指标:

5、VR眼镜进可选硬件

VR眼镜主要应用于三维显示使用,其图像来源为图传系统,显示延迟为50ms。

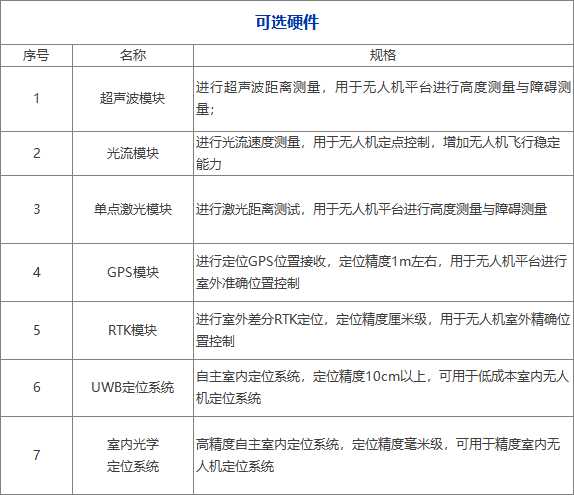

6、可选硬件

本系统可以选配件如下:

- 软件开发与技术支持

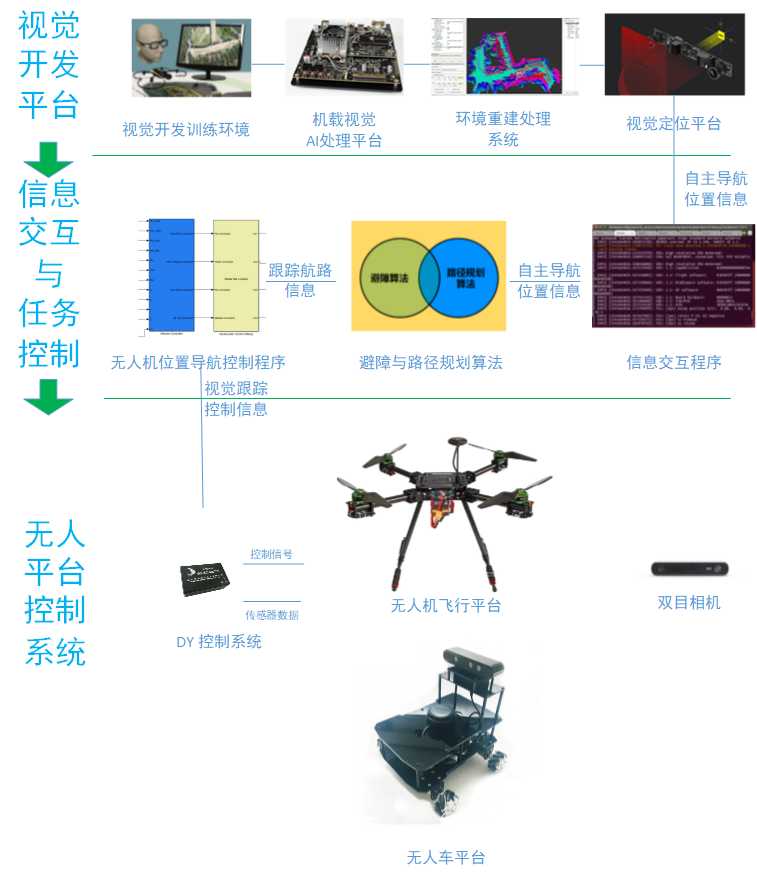

1、基于机器视觉无人平台自主导航避障系统软件开发体系

基于机器视觉无人平台自主导航避障系统软件开发体系由视觉开发平台、信息交互与任务控制平台、无人机系统等组成。

双目摄像头采集图像,通过立体匹配技术计算出二维图像的深度信息,同时利用视觉惯性融合技术估计相机自身的运动姿态,融合多帧深度信息,重建空间环境的体素地图。由地图获取障碍物距离信息,生成可执行路径。

视觉开发平台:由视觉开发训练环境Jetson TX2 视觉处理开发系统等组成、视觉定位平台、环境重建系统等组成。

信息交互与任务控制平台:由信息交互程序、避障与路径规划算法、无人机位置导航控制程序等组成。

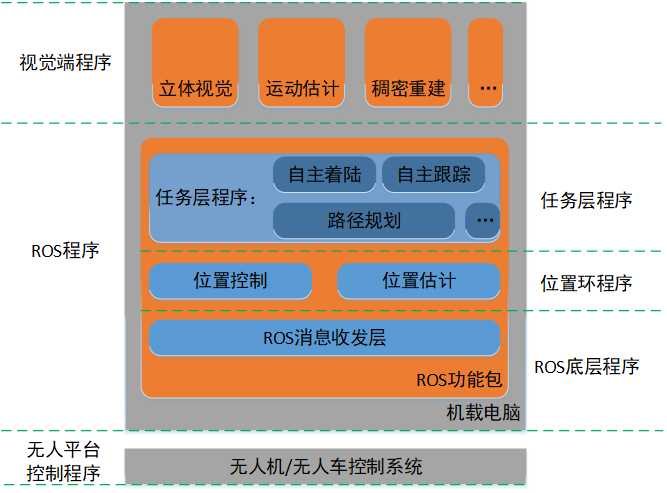

系统软件运行架构如下图所示:

2、技术服务

1)开发环境

提供全套基于机器视觉无人平台自主导航避障系统软件开发体系:

a、视觉端开发环境;

b、Mavros开发环境;

c、飞控开发环境。

2)软件源码

提供全套基于机器视觉无人平台自主导航避障系统相关源代码:视觉系统代码

立体视觉:

主要是在双目立体视觉系统中,获取图像的深度图。基于立体匹配的生成概率模型ELAS立体视觉算法,用于快速匹配高分辨率图像。在双目立体图像间建立点点对应然后根据对应点的视差计算出深度。用左右图像的互相推测,来执行左右一致性检查,消除遮挡区域中的虚假不匹配和视差。

运动估计:

主要用于计算每帧图像无人机的位姿。通过滑动窗口优化进行实时光流点跟踪与匹配,视觉和IMU的紧耦合。通过稀疏特征点提取与跟踪、IMU预积分与初始化处理、KLT光流法进行后端融合优化、利用共视的特征点进行闭环检测等步骤,完成利用视觉惯导融合的定位算法,实现无人机精确定位。

稠密重建:

主要实现单帧深度图融合,重建出无人机的环境。采用在线实时动态增量式生成ESDF算法。ESDF是基于体素网格的方法,每个点包含了该点到最近障碍物的欧几里得距离。在计算机图形和视觉应用中,TSDF近来已经成为一种常用的隐函数表面表示方法。因为TSDF的快速重建和过滤传感器噪声,并且可以使用子体素分辨率创建人类可读的地图网格。

航迹规划:

根据传感器的信息来不断地跟新其内部的环境信息,从而确定出机器人在地图中的当前位置及周围局部范围内的障碍物分布情况,并在此基础上,规划出一条从当前点到某一子目标点的最优无碰撞路径。

a、Mavros程序

Mavros的最底层程序完成Mavros消息发布与订阅,负责将飞控发来的mavlink消息转换为ros中的话题,为上层的程序提供消息订阅,将任务层发出的ros话题转换为mavlink消息发送给飞控。

b、无人机位置控制程序

位置控制程序包含位置估计程序与位置控制程序,代替了飞控中位置控制程序的一部分功能,然后在这个基础上借助命令发布这个话题给上层应用提供了接口,便于上层开发。位置估计做为飞控的位置姿态状态估计,将雷达定位信息转成飞控能够使用的类型发送给飞控进行解算。

c、任务层程序

无人机基本动作控制程序:一键起飞、降落、悬停、紧急上锁、惯性系及机体系下的控制指令等无人机自主控制程序。

组合功能控制程序:自主着陆、自主跟踪、路径自主规划等无人机自主复杂功能控制程序。

3)提供功能示例

a、利用双目相机实现无人机自主避障功能;

b、利用双目相机实现slam路径规划。

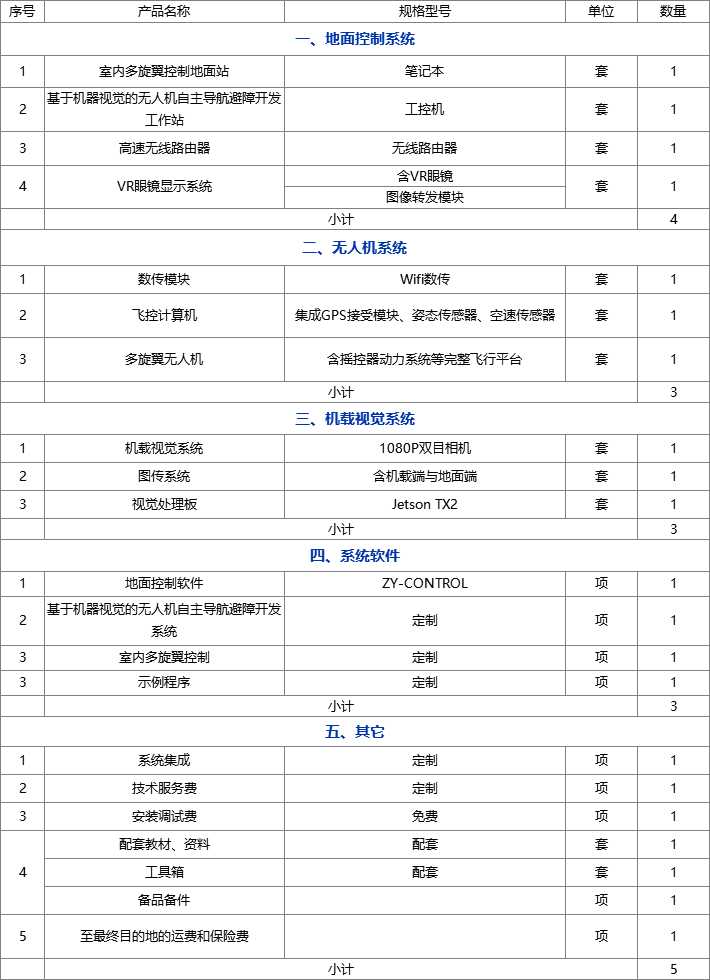

- 设备列表

关于我们

- 关于我们

- 重点实验室

- 荣誉资质

- 瑶光研究院

核心产品

- 教学类产品

- 竞赛类产品

- 科研开发平台

新闻中心

- 卓翼大事记

- 媒体中心

- 精彩视频

解决方案

- 教学

- 竞赛

- 科研开发

联系我们

地址: 北京市海淀区知春路27号量子芯座大厦406室

电话: 广告,供应商及其他,联系邮箱:support@droneyee.com

座机: 座机:010-62064221 业务电话:15901

今天的文章基于机器视觉无人平台自主导航避障系统(卓翼智能)分享到此就结束了,感谢您的阅读。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌侵权/违法违规的内容, 请发送邮件至 举报,一经查实,本站将立刻删除。

如需转载请保留出处:https://bianchenghao.cn/66914.html