上一节我们详细的讲解了Hopfield神经网络的工作过程,引出了吸引子的概念,简单来说,吸引子就是Hopfield神经网络稳定时其中一个状态,不懂的请看Hopfield神经网络详解,下面我们就开始看看吸引子有什么性质:

1.吸引子的性质

性质1:若

证明: 因为

所以

性质2: 若

注:所谓海明距离是通信的含义就是说状态位不一样的个数,如1100和1000,其海明距离为1,因为不同的位就只有1位,

证明:两个向量的海明距离

由假设条件知,

所以

性质3:

若有一组向量

2.吸引子的吸引域

能使网络稳定在同一吸引子的所有初态的集合,称该吸引子的吸引域,下面给出吸引域的定义:

定义1: 若

定义2:若对于某些

欲使反馈网络具有联想能力,每个吸引子应该都具有一定的吸引域,这样这样带噪声和缺失信息的初始样本,网络才能经过动态演变而稳定到某一个吸引子状态,从而实现正确的联想。反馈网络设计的目的就是要使网络能落到期望的稳定点上,并且具有最可能大的吸引域,以增强联想的功能即抗干扰的能力。

下面举个例子来说明是如何联想的:

这里就不画图了,直接从书中截图过来,然后详细讲解:

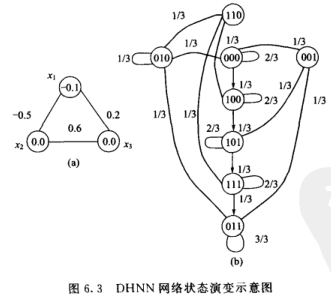

先解释一下,(a)图是说明

设各节点状态取值为1或者0,3节点的DHNN网络应有

第一步更新

![深度学习 — Hopfield神经网络详解(吸引子的性质、网络的权值的设计、网络的信息存储容量)插图55 x_1 = sgn[(-0.5)\times 0+0.2\times 0-(-0.1)]=sgn(0.1)=1](https://bianchenghao.cn/wp-content/uploads/2022/12/2022122605452522.jpg)

第二步,此时的网络为

![深度学习 — Hopfield神经网络详解(吸引子的性质、网络的权值的设计、网络的信息存储容量)插图69 x_2 = sgn[(-0.5)\times 1+0.6\times 0-0]=sgn(-0.5) = 0,](https://bianchenghao.cn/wp-content/uploads/2022/12/2022122605452522.jpg)

第三步,此时的网络状态为

同理可算出其他状态的直接的演变过程和状态转移概率,如上图b给出八种状态,从图中我们看到

上面就是网络的转移过程和联想过程,下面我们来看看,如何设计吸引子,即如何设置网络权值。

3.网络的权值设计

从上面我们知道了网络是如何动态的更新到吸引子的,那么我们现在如何设计吸引子呢?

吸引子的分布是由权值决定的,设计吸引子的核心是如何设计一组合适的权值,为了使所设计的权值满足要求,权值矩阵应符合如下要求:

- 为保证异步方式工作时网络收敛,

应该为对称阵

- 为保证同步方式工作时网络收敛,

应该为非负定对称阵

- 保证给定的样本是网络的吸引子,并且要有一定的吸引域

根据所要求的的吸引子的数量,可以采用不同的方法设计吸引子,如下:

联立方程法:

下面根据上图的3个节点继续设计吸引子,设要求设计的吸引子为

考虑到

对于

联立可以接得:权值的范围,在范围内选择一个权值就可以,下面直接给出答案了,权值不唯一:

因此该参数的从初态最终会演变到我们设计的两个吸引子中。

但是此种方法只适合吸引子较少的时候计算,如果吸引子较多时就需要采用外积和法。

外积和法:

更为通用的权值设计方法是采用Hebb规则的外积和法,设给定P个模式样本

若

![深度学习 — Hopfield神经网络详解(吸引子的性质、网络的权值的设计、网络的信息存储容量)插图113 W = \sum_{p=1}^{P}[x^p(x^p)^T-I]](https://bianchenghao.cn/wp-content/uploads/2022/12/2022122605452522.jpg)

式中,

所以上面w必然满足对称性要求,下面还需要检查一下是否为吸引子。

因P个样本

所以:

因为n>p,所以有:

可见给定样本

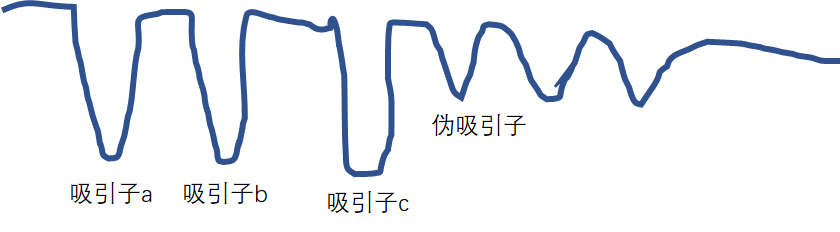

假如吸引子a,b,c是我们设计的吸引子,但是后面的就是伪吸引子,如何处理伪吸引子,我们将在下节继续讨论,这里先提一下。

4.网络的信息存储容量

当网络规模一定时,所能记忆的模式是有限的,对于所容许的联想出错率,网络所能存储的最大模式数

定理1: 若DHNN网络的规模为n,且权矩阵主对角线元素为0,该网络的信息容量上界为n。

定理2: 若P个记忆模式

定理3:若P个记忆模式

从上面的定理可知,当用外积设计DHNN网络时,如果记忆模式都满足两两正交的条件,则规模为n维网络最多可记忆n个模式,一般情况,模式样本不可能都满足正交条件,对于非正交模式,网络的信息存储会大大降低。

事实上,当网络规模n一定时,要记忆的模式越来越多,联想时出错的可能性很大,反之,要求出错率越低,网络的信息存储容量上限越小。研究表明当存储模式数P超过0.15n时,联想时就有可能出错,错误结果对应的是能量的局部极小点,或称为伪吸引子。

提高网络存储容量有两个基本途径:

1.改进网络拓扑结构

2.改进网络的权值设计方法

常用的改进方法有:反复学习法、纠错学习法、移动兴奋门限法、伪逆法、忘记规则和非线性谢谢规则等。

我们们知道了, Hopfield神经网络的最大问题在于伪吸引子的存在,一旦存在伪吸引子,因此容易造成错误,如何处理伪吸引子就是我们下一节所要解决的。

到这里DHNN就结束了,CHNN这里不讲了,感兴趣的自行查阅资料了解。

今天的文章深度学习 — Hopfield神经网络详解(吸引子的性质、网络的权值的设计、网络的信息存储容量)分享到此就结束了,感谢您的阅读。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌侵权/违法违规的内容, 请发送邮件至 举报,一经查实,本站将立刻删除。

如需转载请保留出处:https://bianchenghao.cn/83095.html