最近适用了这五款分词工具,光是下载安装就踩了很多坑,特别是pyltp和hanlp,装到我怀疑人生。

以下是整理的安装过程和注意事项。

希望能给大家提供些帮助。

目录

一、Nlpir

第一步:下载工具。

下载地址

NLPIR工具每七天要更新一次License, 去原项目(原项目地址点这)下载下面的文件覆盖源文件里的License文件。

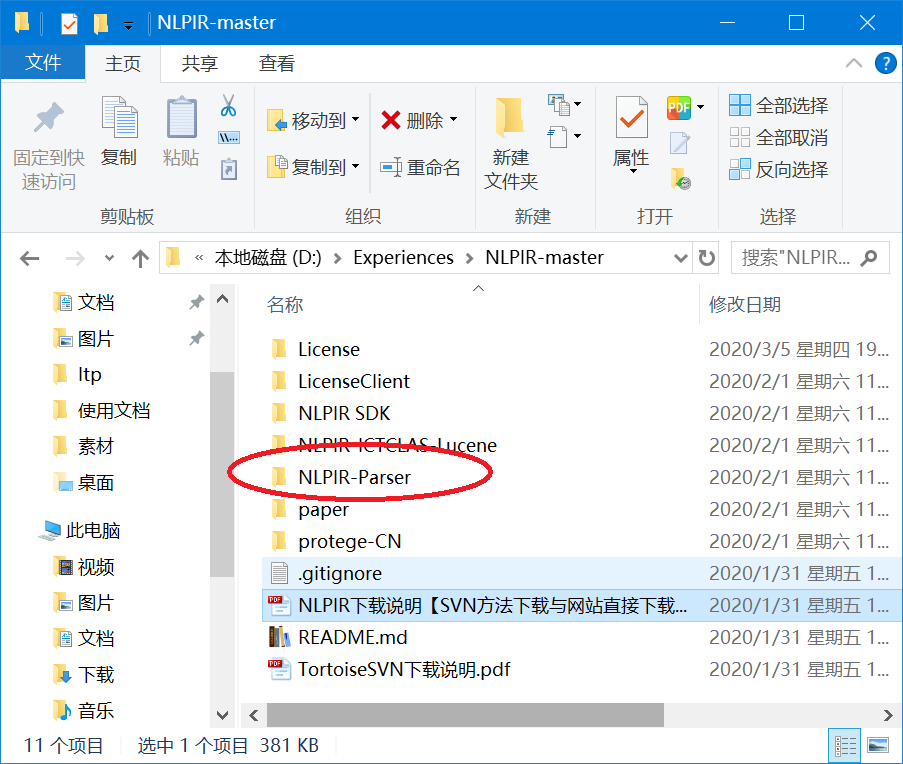

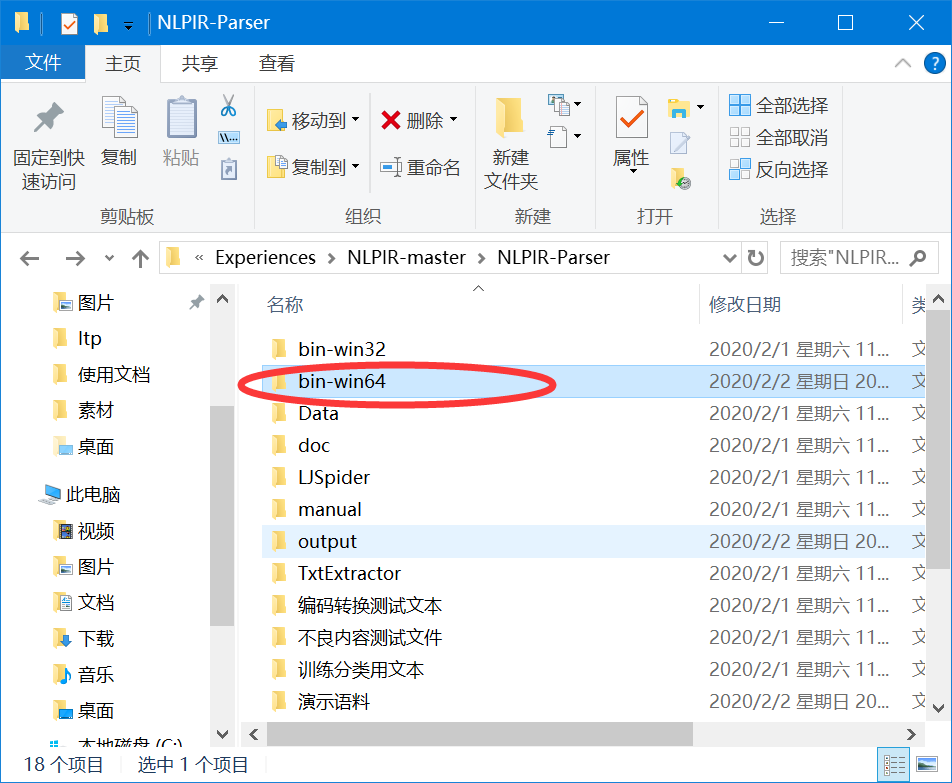

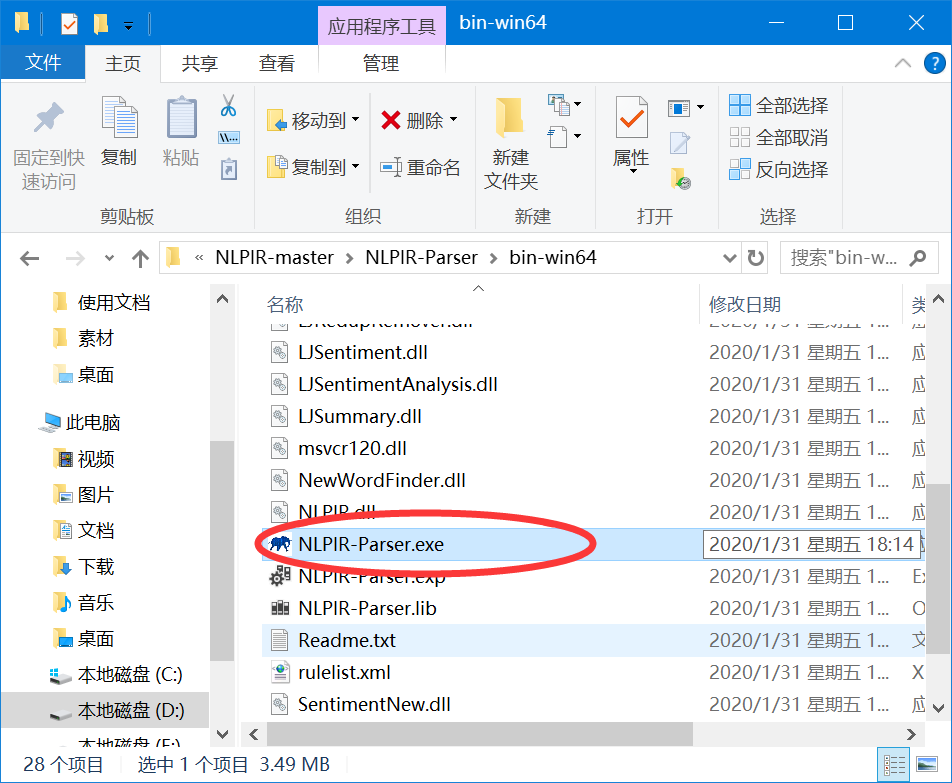

第二步:下载后,解压,按如下顺序进入目录。

按自己电脑版本选择进入win32或win64。

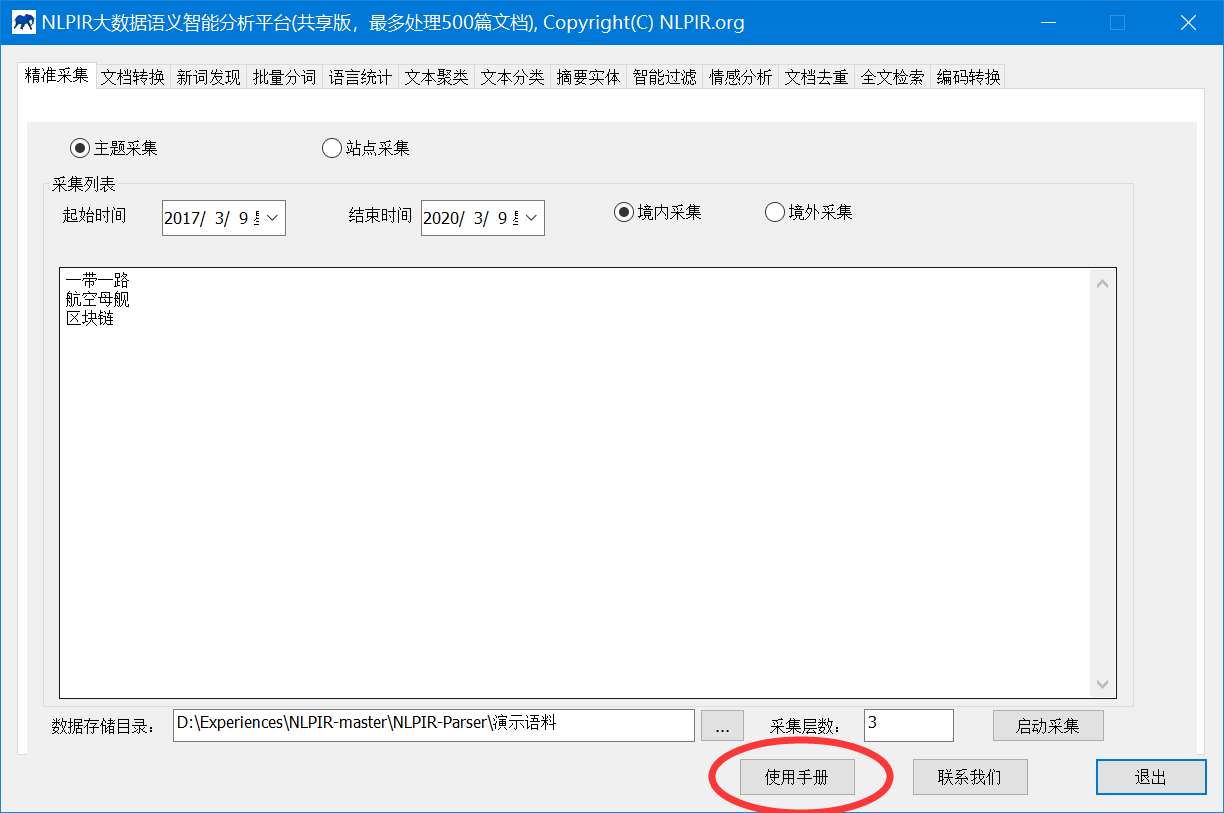

打开NIPIR-Parser.exe

第三步:打开工具,可以看到有精准采集、文档转换、批量分词等功能。具体使用方法可参考右下角“使用手册”。

二、 Pyltp

pyltp 是 LTP 的 Python 封装,提供了分词,词性标注,命名实体识别,依存句法分析,语义角色标注的功能。(目前pyltp 暂不提供语义依存分析功能)。

第一步:下载安装Pyltp。

可参考:pyltp目录、pyltp在windows下的编译安装

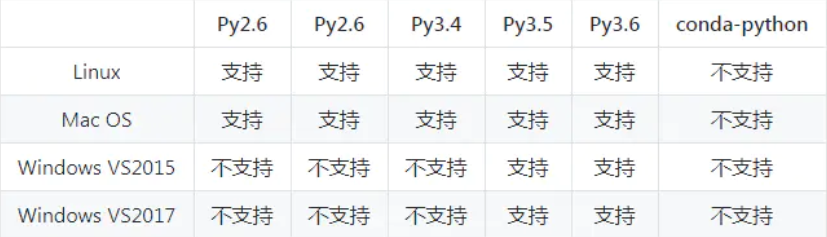

注意:pyltp不支持python7及以上版本;要先下载好VC2015。

第二步:下载模型。

下载地址

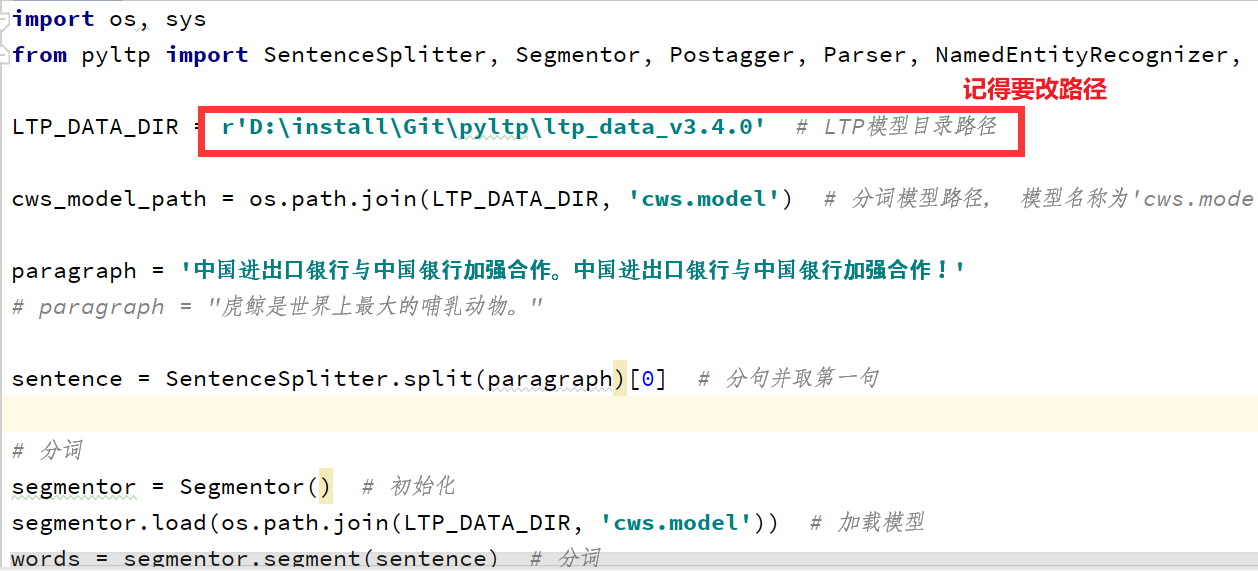

注意:模型文件可放在随意位置,使用时指定绝对地址即可。

第三步:使用基本组件。

可参考:pyltp的使用教程

三、 Jieba

第一步:pip安装,指令为

pip install jieba -i https://pypi.douban.com/simple/

(使用清华镜像,超快)

可参考:jieba安装下载

第二步:基于python中jieba包的中文分词中详细使用。

可参考:jieba安装下载

四、 Hanlp

第一步:下载Hanlp 。

下载链接

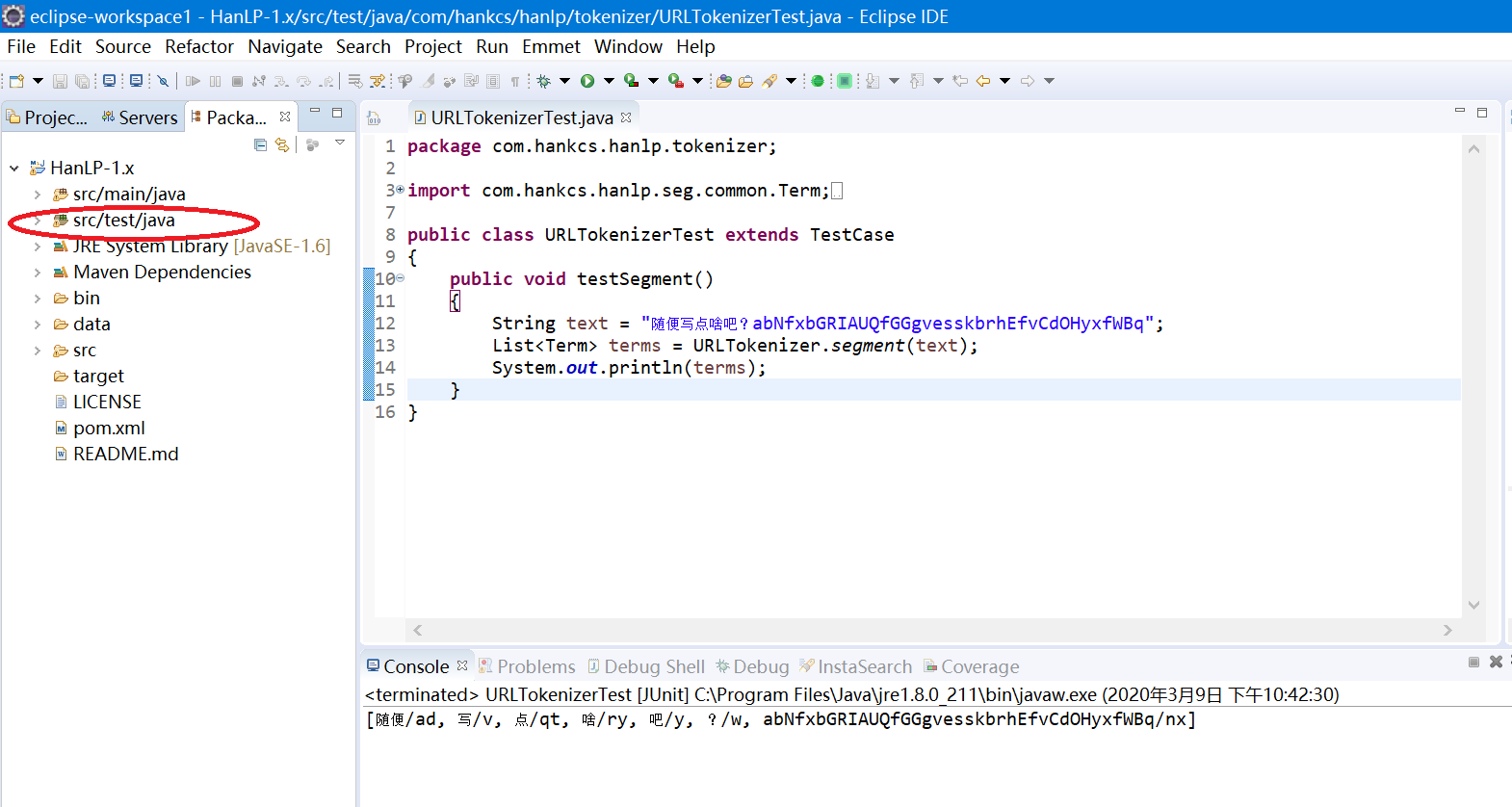

第二步:在eclipse里导入项目。点开下图文件夹,即可使用Hanlp各个功能。

五、 Snownlp

第一步:安装。

指令为 pip install snownlp

第二步:使用。

可参考:Py之SnowNLP:SnowNLP中文处理包的简介、安装、使用方法、代码实现之详细攻略

今天的文章nlpir汉语分词系统怎么用_nlpayer安卓分享到此就结束了,感谢您的阅读。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌侵权/违法违规的内容, 请发送邮件至 举报,一经查实,本站将立刻删除。

如需转载请保留出处:https://bianchenghao.cn/84389.html