TARN: Temporal Attentive Relation Network for Few-Shot and Zero-Shot Action Recognition(TARN:时间注意力关系网络解决小样本和零样本的动作识别问题)

注:转载请标明出处。相关论文链接:https://xueshu.baidu.com/usercenter/paper/show?paperid=1d1406u0m6590ve06a3f0t300x055344&site=xueshu_se

1 摘要

在本文中,我们提出了一种新颖的时间注意力关系网络(TARN),用于解决小样本和零样本的动作识别问题。我们网络的核心是一种元学习的方法,该方法可以学会比较可变时间长度的表示,即两个不同长度的视频(小样本学习)或一个视频和一个语义表示如单词向量(零样本学习)。

与小样本和零样本动作识别中的其他方法相比,我们的方法有两方面提高:

a)利用注意力机制(attention mechanism)来实现视频的时间对齐;

b)在视频的片段级别上,对已经对齐的表示进行深度度量。

我们采用episode、end-to-end的方式训练我们的网络。该方法不像存储网络那样,需要在目标域中进行网络微调或存储记忆。实验结果表明,该结构在小样本动作识别中优于现有的state-of-the-art方法,并在零样本动作识别中获得了有竞争力的结果。

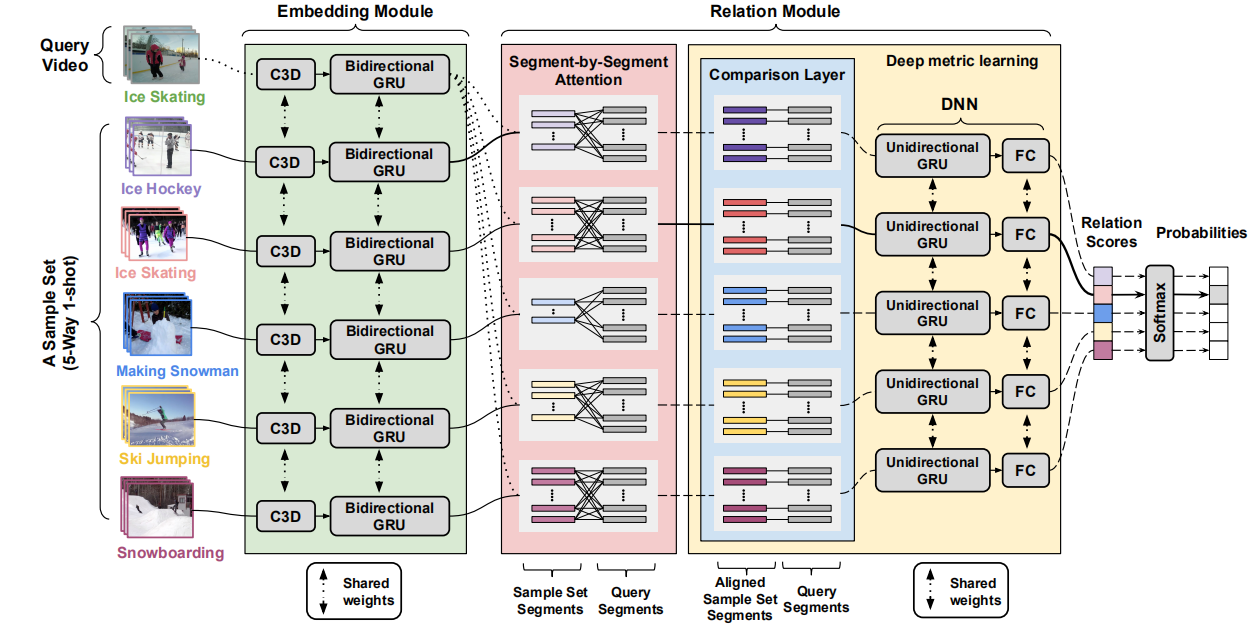

图1:TARN体系结构。由嵌入模块和关系模块组成。在C-way K-shot任务(其中K> 1)中,查询集视频与支持集视频每个类别的关系得分,是该类别的样本关系得分的平均值。

2 绪论

我们的网络(TARN)通过在视频片段级别上进行工作,来计算查询集视频与其他支撑集视频之间的关系得分,并为查询集视频分配得分最高的支撑集视频所对应的标签。

关系/相似度比较分两个阶段:嵌入阶段和关系阶段。

在嵌入阶段中,3D CNN(C3D)网络后接一层双向门控循环单元(Gated Recurrent Unit),可从视频的短片段中提取特征。 GRU学习了一种通用的嵌入功能,可以在不同任务之间转移。

在关联阶段中,使用逐段注意力机制将一对查询集视频和支撑集视频的分段嵌入对齐,然后比较对齐的分段。也就是说,我们引入了段到段的比较来作为视频到视频比较的前一步,并对它们的时间演变进行建模。然后将比较的输出送入到一个深度神经网络,该神经网络用于视频匹配的深度测量,并输出一对视频的最终关系得分。

我们的方法可以推广到基于视频的ZSL,其中支撑集中没有视频可用于训练,而是提供了类别描述(例如属性向量)。在这种情况下,查询集和支撑集具有不同类型的数据(分别为视觉和语义),因此我们分别使用两个不同的嵌入模块。在FSL和ZSL情况下,以端到端的方式训练TARN(不包括C3D模型)。

我们工作的主要贡献包括三个方面:

1.我们提出了一种用于小样本和零样本动作识别的关系网络;

2.不需要像内存网络这样的额外资源,也不需要对目标问题进行微调;

3.在不同的基准数据集上测试,FSL中获得了state-of-the-art的结果,并在ZSL中获得了非常有竞争力的性能。

3 提出的体系结构

图1显示了网络概述。 TARN学习将查询集视频与一组视频样本(FSL)或语义属性(ZSL)进行比较。在FSL情况下,输入一方面是查询集视频和支撑集视频的分段视觉表示;而在ZSL情况下,一方面是查询集视频的分段视觉表示,另一方面是看不见的类语义表示。输出是一个关系得分。更具体地说,TARN由两个模块组成:嵌入模块和关系模块。首先,嵌入模块处理视觉或语义表示,保留视觉特征的时间结构,并生成嵌入表示,以为了后面进行比较。其次,关系模块先应用逐段注意力机制,要么将支撑集的视觉表示转换为具有与查询集视频相同数量的片段(FSL),要么转换看不见的类语义表示,以允许它们与视觉表示之间进行逐段比较(ZSL),之后,执行每个段的比较。 最终,关系模块通过考虑查询集视频所有片段之间的比较差异,得出关系得分。

3.1 嵌入模块

TARN在FSL中,使用单个嵌入模块,嵌入查询集视频和支撑集视频;而在ZSL中,使用两个不同的嵌入模块,一个用于嵌入查询集的视觉数据,而另一个用于嵌入支撑集的语义数据。

视频嵌入:已经经过预训练的C3D网络用于提取视频短片段的时空特征,该网络在嵌入模块中充当本地特征提取器。然后,双向GRU使用已经得到的本地特征来学习更多具有全局意识的特征,从而允许每个时间步可以访问到整个视频中的前后向信息。此外,双向GRU还减小了C3D所得特征的尺寸。 该视觉嵌入模块以相同的方式应用于在FSL和ZSL中。

语义嵌入:ZSL首先将从查询集视频片段中提取的视觉表示,与支撑集中提取的类语义表示进行比较。我们需要将原始语义信息编码为一种表示形式,该表示形式允许将视频片段与类相关属性进行丰富的特征比较,因此要求该表示形式与视频片段的视觉表示具有相同的尺寸。语义嵌入模块由两个堆叠的全连接层(FC)组成。

3.2 关系模块

在本节中,我们将从FSL角度说明关系模块,然后说明如何拓展到ZSL的关系模块。

在FSL中:

1.为了使查询集视频与支撑集视频特征相匹配,首先,我们将查询集视频与支撑集中的每个视频配对;

2.其次,针对给定的视频对,我们使用逐段注意力层对齐视频中所含的段。注意力层将支撑集视频映射为具有与查询集视频相同数量的分段嵌入;

3.第三,将查询集中的每个片段与对应的对齐支撑集视频片段进行比较;

4.第四,将不同片段的比较输出结果输入到一个深度神经网络,该神经网络用于学习视频匹配的一种深度度量方式,并输出每对视频的相关分数;

5.最后,使用softmax()将关系得分映射到0~1之间。

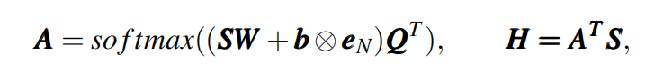

逐段注意力机制:最近有关文本序列匹配和文本蕴涵的一些著作中,使用了一种称为逐单词注意力机制来对齐两个给定句子的单词。类似地,如图1所示,我们在体系结构中采用逐单词注意力机制来对齐支撑集和查询集的分段嵌入(即逐段注意力机制)。给定支撑集视频S∈RN×d和查询集视频Q∈RM×d,其中S和Q中的每一行表示维数为d的分段嵌入矢量,其中N和M分别表示视频S和Q中的分段数目。 逐段注意力机制计算如下:

其中,W∈Rd×d和b∈Rd是要学习的参数,运算符“⊗eN”表示将偏置向量b重复N次,以形成N×d维的矩阵。A∈RN×M是注意力权重矩阵,H是S经对齐后所得的向量。H中每个行向量都是S片段嵌入的加权和,表示S中与Q的相应行向量(每一行代表一个片段的嵌入表示)最相似的部分。最后,Q和H的行向量将作为输入,输入到比较层中。

图2 维度变化示意图,将S变成了与Q维度一致的特征向量H,均为M×d。

深度度量学习:关系模块通过使用顶部的比较层和非线性分类器,来完成深度距离度量学习。

比较层用来计算Q∈RM×d和H∈RM×d中,M个对应片段行向量之间的相似性度量。此度量方式可以基于以下操作之一完成:乘法(Mult)、减法(Subt)、神经网络(NN)、减法和乘法后跟神经网络(SubMultNN)或欧几里得距离和余弦相似度(EucCos)。由于我们是对M个组合片段对进行的度量估算,因此比较层的输出也是具有M个维度。比较层可以看做为对比的中间阶段,用于生成支撑集和查询集片段之间的低级表示。正如我们在实验部分展示的那样,将查询集样本匹配问题分解为跨片段的多个比较问题,要比仅对代表支撑集视频和查询集视频的两个向量进行一次比较效果更好。

我们使用深度神经网络进行深度度量学习。也就是说,比较层的输出将传递到深度网络,该深度网络将学习整个视频的全局深度度量。

对于FSL,我们使用单向GRU来学习跨不同片段比较的时间信息,并使用全连接(FC)层来得到最终的关系得分。来自不同样本示例的最终关系得分将传递到softmax层,将关系得分映射为概率分布0~1之间。最后为查询集视频分配支撑集中最相关的视频标签。 若支撑集中每个类别所含的样本数K> 1,则每类所有样本的关系得分的平均值,将作为查询集视频与该类别的关系得分。

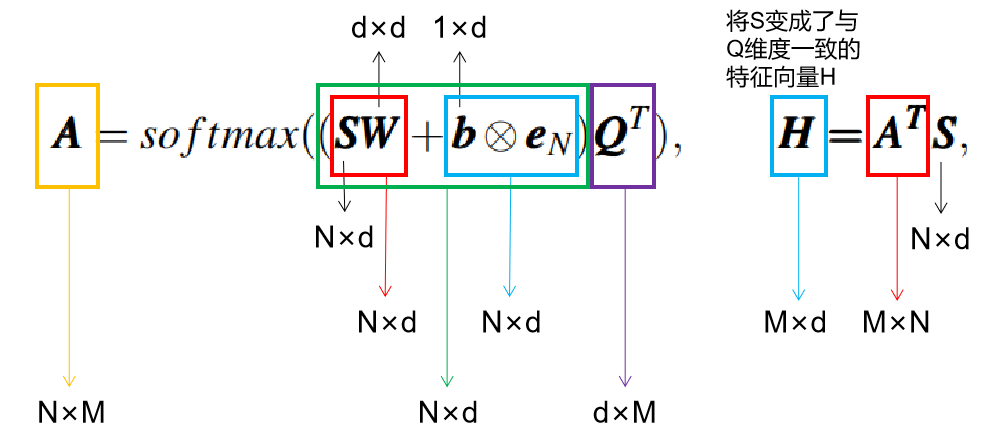

完整的体系结构(不包括C3D模型)以end-to-end的方式、使用episode的训练方案来训练,并将二进制交叉熵作为损失函数:

其中K表示样本数量,C表示每个episode的类别数量,t是真实的关系得分,q是预测的关系得分。

在零样本学习中,每个支撑集类都由语义属性或者词向量表示。在这种情况下,注意力机制会估计语义向量和查询集视频每个片段之间的相似性,而不是像FSL情况那样对齐视频片段。语义嵌入模块将类属性编码为表示形式,以允许在基础类属性和查询集视频片段之间找到关系。我们利用这些细粒度的信息,来进行多个片段和属性之间的比较,以改善训练过程并减少过拟合的情况。使用两个FC层和一个产生最终关系得分的平均池化层,将比较输出汇总到所有查询集的视频片段上。在这种情况下,比较层,FC层和池化层代表用于度量学习的深度网络。 请注意,由于在深度网络中没有要学习的时间对齐信息,因此已替换了FSL的单向GRU。

4 实验结果

4.1 小样本动作识别

实施细节:数据集是对原始Kinetics数据集的修改。将数据集每个视频切成16帧的固定长度片段,然后将这些片段送到已经在Sports-1M数据集上预训练过的C3D网络中[15]。从C3D网络的最后一个FC层(即FC7)中提取视觉特征,并将其用作双向GRU的输入。C3D所得特征的尺寸为4096,GRU具有256个隐藏状态。在关系模块中,比较层的输出将作为大小为256的单向GRU层的输入,最后一步的GRU输出被输入到具有单个神经元的FC层,以预测最终的关系得分。我们使用20,000个episode进行训练,使用500个episode进行验证,并使用1,000个episode进行测试。每个插曲episode有5个类。使用随机梯度下降(SGD)训练我们的体系结构。

结果:

实验一:研究了可用作比较层中的各种距离/相似性度量方案对TARN性能的影响。欧几里得距离和余弦相似度(EucCos)获得精度最高。

实验二:研究了使用逐段注意力机制,以及逐段比较表示的好处。

TARN-single模型:没有注意力层,直接对每个视频对执行一次比较。嵌入模块,使用大小为256的单向GRU替换双向GRU。关系模块,使用大小为256的FC层替换单向GRU。TARN结果更佳,得到了SOTA的精度。

实验三:使用相同的特征提取架构,比较我们将TARN模型与[49]中提出的体系结构。使用经ImageNet 预训练的ResNet-50模型进行特征提取。 TARN-f模型:将TARN模型修改为使用帧级的ResNet50特征而不是片段级的C3D特征,嵌入模块中的双向GRU替换为单向GRU。TARN-f-single:不使用注意力机制和段级比较。将单向GRU应用于整个视频,然后将输出的直接输入到比较层。TARN-f的性能要优于CMN,C3D的性能要优于ResNet。由于C3D是时空的,而ResNet是静态的。

今天的文章知网国外文献怎么看全文_文献阅读笔记分享到此就结束了,感谢您的阅读。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌侵权/违法违规的内容, 请发送邮件至 举报,一经查实,本站将立刻删除。

如需转载请保留出处:https://bianchenghao.cn/88561.html