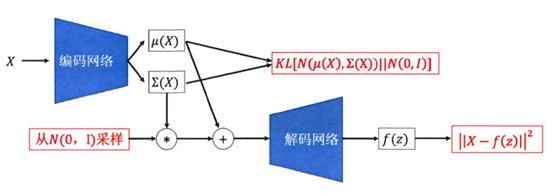

谈起重参数化技巧,不得不提变分自编码器(VAE);在VAE中,我们知道需要对编码器的输出

-

概率分布:

直接从边缘概率分布中采样,即给定一个随机变量y,并且

先从

中采样得到

.

根据表达式

,以这种方式等价从

采样,用

表该采样样本.

没错,过程就是这么简单,这里我们把采样得到的

L(y)作为关于y的损失函数,也即目标函数,那么训练过程中关于参数

L是我们自定义的损失函数,关于y的偏导便是已知项,而

我们需要对y的采样转换成从

-

条件概率分布:

直接从后验概率分布中采样与前面不同的是,这里y是x给定下的条件下概率

具体做法:

先从

中采样得到

.

根据表达式

,我们知道

都是和x相关,即:

,于是前面表达式写成

,以这种方式等价从y的后验中采样,用

表该采样样本.。

上述过程,在VAE中的表现形式:

接下来,我们来看看训练过程,采样的结果y关于参数

故:

个人感觉,对

在学习过程中,将自己的收获记录下来,以便日后翻阅、查缺补漏。

今天的文章VAE中重参数化技巧分享到此就结束了,感谢您的阅读。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌侵权/违法违规的内容, 请发送邮件至 举报,一经查实,本站将立刻删除。

如需转载请保留出处:https://bianchenghao.cn/9063.html