目录

一、 计算公式

在shannon提出信息论到现在已经有70多年的历史。信息论中常用的概念有信息熵、联合熵、条件熵、互信息等概念。

1、信息熵H(X)

定义:一个离散随机变量X的熵H(X)定义为

H ( X ) = − ∑ x ∈ χ p ( x ) log p ( x ) H(X)=-\sum_{x\in \chi}p(x)\log p(x) H(X)=−x∈χ∑p(x)logp(x)

2、联合熵H(X,Y)

定义:对于服从联合分布为p(x,y)的一对离散随机变量(X,Y),其联合熵H(X,Y) (joint entropy)定义为:

H ( X , Y ) = − ∑ x ∈ X ∑ y ∈ Y p ( x , y ) log p ( x , y ) H(X,Y)=-\sum_{x\in \mathit{X}}\sum_{y\in\mathit{Y}}p(x,y)\log p(x,y) H(X,Y)=−x∈X∑y∈Y∑p(x,y)logp(x,y)

3、互信息I(X,Y)

定义:考虑两个随机变量X和Y,他们的联合概率密度函数为p(x,y),其边际概率密度函数分别为p(x)和p(y)。互信息I(X;Y)为联合分布p(x,y)和p(x)p(y)之间的相对熵,即:

I ( X ; Y ) = ∑ x ∈ χ ∑ y ∈ ν p ( x , y ) log p ( x , y ) p ( x ) p ( y ) I(X;Y)=\sum_{x\in \chi}\sum_{y\in \nu}p(x,y)\log \frac{p(x,y)}{p(x)p(y)} I(X;Y)=x∈χ∑y∈ν∑p(x,y)logp(x)p(y)p(x,y)

4、条件熵H(X|Y)

定义:若(X,Y)~p(x,y),条件熵(Conditional entropy) H(Y|X)定义为:

H ( Y ∣ X ) = ∑ x ∈ χ p ( x ) H ( Y ∣ X = x ) = − ∑ x ∈ χ p ( x ) ∑ y ∈ ν p ( y ∣ x ) log p ( y ∣ x ) = − ∑ x ∈ χ ∑ y ∈ ν p ( x , y ) log ( y ∣ x ) = − E log p ( Y ∣ X ) H(Y|X)=\sum_{x\in \chi}p(x)H(Y|X=x)=-\sum_{x\in \chi}p(x)\sum_{y\in \nu }p(y|x)\log p(y|x)\\ =-\sum_{x\in \chi}\sum_{y\in \nu}p(x,y)\log(y|x)=-E\log p(Y|X) H(Y∣X)=x∈χ∑p(x)H(Y∣X=x)=−x∈χ∑p(x)y∈ν∑p(y∣x)logp(y∣x)=−x∈χ∑y∈ν∑p(x,y)log(y∣x)=−Elogp(Y∣X)

二、举例说明

为了对以上公式进行更加直观的理解,通过以下例子对信息熵、联合熵、条件熵、互信息、条件互信息进行举例。

1、信息熵H(X)

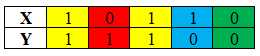

假设有两个二进制的变量X和Y

x = [1 0 1 1 0]’;

y = [1 1 1 0 0]’;

根据概率

p(x=0)=2/5; p(x=1)=3/5;

p(y=0)=2/5; p(y=1)=3/5;

H ( x ) = − 2 5 ∗ log ( 2 5 ) − 3 5 ∗ log ( 3 5 ) = 0.9710 H(x)=-\frac{2}{5}*\log(\frac{2}{5})-\frac{3}{5}*\log(\frac{3}{5})=0.9710 H(x)=−52∗log(52)−53∗log(53)=0.9710

同理计算得到 h ( y ) = 0.9710 h(y)=0.9710 h(y)=0.9710

2、联合熵H(X,Y)

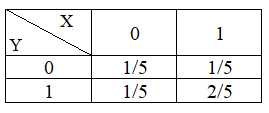

要计算H(X,Y),需要先知道P(X,Y)。

根据X,Y的值可以得到P(X,Y):

上图绿色标记: p ( x = 0 ; y = 0 ) = 1 / 5 p(x=0;y=0)=1/5 p(x=0;y=0)=1/5

上图红色标记: p ( x = 0 ; y = 1 ) = 1 / 5 p(x=0;y=1)=1/5 p(x=0;y=1)=1/5

上图蓝色标记: p ( x = 1 ; y = 0 ) = 1 / 5 p(x=1;y=0)=1/5 p(x=1;y=0)=1/5

上图黄色标记: p ( x = 1 ; y = 1 ) = 2 / 5 p(x=1;y=1)=2/5 p(x=1;y=1)=2/5

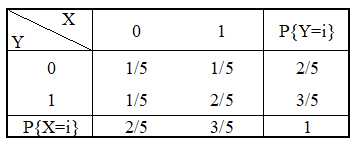

得到(X,Y)的分布律如下:

最终计算H(X,Y)得到:

H ( X , Y ) = − 1 5 ∗ log ( 1 5 ) − 1 5 ∗ log ( 1 5 ) − 1 5 ∗ log ( 1 5 ) − 2 5 ∗ log ( 2 5 ) = 1.9219 \begin{aligned} H(X,Y)=&-\frac{1}{5}*\log(\frac{1}{5})-\frac{1}{5}*\log(\frac{1}{5})\\ \\ &-\frac{1}{5}*\log(\frac{1}{5})-\frac{2}{5}*\log(\frac{2}{5})\\ =&1.9219 \end{aligned} H(X,Y)==−51∗log(51)−51∗log(51)−51∗log(51)−52∗log(52)1.9219

3、互信息I(X,Y)

I ( X ; Y ) = H ( X ) + H ( Y ) − H ( X , Y ) = 0.9710 + 0.9710 − 1.9219 = 0.02 \begin{aligned} I(X;Y)=&H(X)+H(Y)-H(X,Y)\\ =&0.9710+0.9710-1.9219\\ =&0.02 \end{aligned} I(X;Y)===H(X)+H(Y)−H(X,Y)0.9710+0.9710−1.92190.02

4、条件熵H(X|Y)

根据(X,Y)的分布律可知:

其中 P ( X = 0 ∣ Y = 0 ) P(X=0|Y=0) P(X=0∣Y=0)表示在Y=0的情况下X=0的概率,可计算得到:

P ( X = 0 ∣ Y = 0 ) = P ( X = 0 , Y = 0 ) P ( Y = 0 ) = 1 / 5 2 / 5 = 1 / 2 P ( X = 1 ∣ Y = 0 ) = P ( X = 1 , Y = 0 ) P ( Y = 0 ) = 1 / 5 2 / 5 = 1 / 2 P ( X = 0 ∣ Y = 1 ) = P ( X = 0 , Y = 1 ) P ( Y = 1 ) = 1 / 5 3 / 5 = 1 / 3 P ( X = 1 ∣ Y = 1 ) = P ( X = 1 , Y = 1 ) P ( Y = 1 ) = 2 / 5 3 / 5 = 2 / 3 P(X=0|Y=0)=\frac{P(X=0,Y=0)}{P(Y=0)}=\frac{1/5}{2/5}=1/2\\ P(X=1|Y=0)=\frac{P(X=1,Y=0)}{P(Y=0)}=\frac{1/5}{2/5}=1/2\\ P(X=0|Y=1)=\frac{P(X=0,Y=1)}{P(Y=1)}=\frac{1/5}{3/5}=1/3\\ P(X=1|Y=1)=\frac{P(X=1,Y=1)}{P(Y=1)}=\frac{2/5}{3/5}=2/3\\ P(X=0∣Y=0)=P(Y=0)P(X=0,Y=0)=2/51/5=1/2P(X=1∣Y=0)=P(Y=0)P(X=1,Y=0)=2/51/5=1/2P(X=0∣Y=1)=P(Y=1)P(X=0,Y=1)=3/51/5=1/3P(X=1∣Y=1)=P(Y=1)P(X=1,Y=1)=3/52/5=2/3

通过以上计算可到条件互信息为:

H ( X ∣ Y ) = − ∑ Y P ( Y ) log P ( X ∣ Y ) = − P ( Y = 0 ) [ H ( P ( X = 0 ∣ Y = 0 ) + H ( P ( X = 1 ∣ Y = 0 ) ] − P ( Y = 1 ) [ H ( P ( X = 0 ∣ Y = 1 ) + H ( P ( X = 1 ∣ Y = 1 ) ) ] = − ( 2 / 5 ) ∗ [ ( 1 / 2 ) ∗ log ( 1 / 2 ) + ( 1 / 2 ) ∗ log ( 1 / 2 ) ] − ( 3 / 5 ) ∗ [ ( 1 / 3 ) ∗ log ( 1 / 3 ) − ( 2 / 3 ) ∗ log ( 2 / 3 ) ] = 0.9510 \begin{aligned} H(X|Y)=&-\sum_Y P(Y)\log P(X|Y)\\ =&-P(Y=0)[H (P(X=0|Y=0)+H (P(X=1|Y=0)]\\ &-P(Y=1)[H (P(X=0|Y=1)+H(P(X=1|Y=1))]\\ =&-(2/5)*[(1/2)*\log(1/2)+(1/2)*\log(1/2)]\\ &-(3/5)*[(1/3)*\log(1/3)-(2/3)*\log(2/3)]\\ = &0.9510 \end{aligned} H(X∣Y)====−Y∑P(Y)logP(X∣Y)−P(Y=0)[H(P(X=0∣Y=0)+H(P(X=1∣Y=0)]−P(Y=1)[H(P(X=0∣Y=1)+H(P(X=1∣Y=1))]−(2/5)∗[(1/2)∗log(1/2)+(1/2)∗log(1/2)]−(3/5)∗[(1/3)∗log(1/3)−(2/3)∗log(2/3)]0.9510

也可以通过公式

H ( X ∣ Y ) = H ( X ) − I ( X ; Y ) = 0.9710 − 0.02 = 0.9510 \begin{aligned} H(X|Y)=&H(X)-I(X;Y)\\ =&0.9710-0.02\\ =&0.9510 \end{aligned} H(X∣Y)===H(X)−I(X;Y)0.9710−0.020.9510

总结

通过举例X,Y对信息熵、联合熵、条件熵和互信息进行计算,加深对信息熵等概念的理解。

今天的文章举例说明信息熵、互信息的计算过程分享到此就结束了,感谢您的阅读。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌侵权/违法违规的内容, 请发送邮件至 举报,一经查实,本站将立刻删除。

如需转载请保留出处:https://bianchenghao.cn/12457.html